Auteur | nuage de technologie Modifier | Camel Cet article est l'Académie chinoise d'ingénierie et une lettre du nuage ensemble à la technologie complète étant employée papier AAAI2020 « Couplé vision profonde Classififier apprentissage de plusieurs annotateurs Noisy » interprétation.

Ces dernières années, l'apprentissage en profondeur a prouvé l'efficacité des différentes tâches de classification, telles que l'utilisation de contrôle du vent modèle de train profond réseau de neurones (DNN) sur l'étiquette de données, et obtenu de bons résultats. Cependant, dans de nombreuses situations pratiques, telles que la surveillance vidéo et des images de diagnostic médical d'une scène réelle, il est difficile de recueillir un étiquetage clair et précis.

Les nuages de l'Académie chinoise des sciences et de la technologie et de la lettre travail publié « Couplé vue DeepClassififier apprentissage de plusieurs Noisy annotateurs », capables d'explorer une utilisation plus efficace des étiquettes d'information faible méthode de classification de l'apprentissage en profondeur, une nouvelle étiquette des gens bruyants nouvelle méthode pour l'apprentissage du classificateur en profondeur à double vue de l'étiquette.

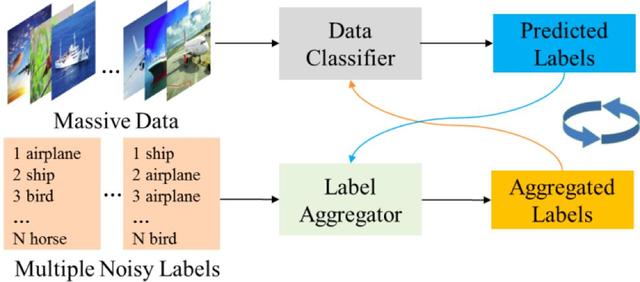

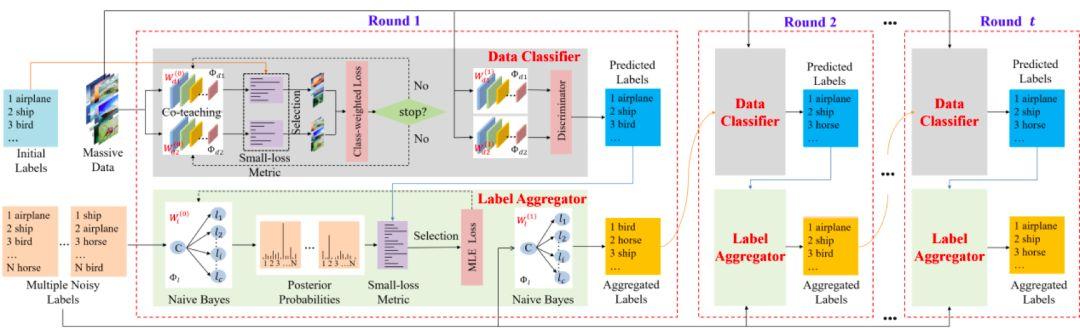

Ce document, nous nous concentrons sur l'étude approfondie du bruit du réseau de neurones de personnes étude marquée de la classification de l'étiquette de la question, l'attente maximisation algorithme de processus estimation itérative des problèmes d'apprentissage mutuel vu que les vues de l'étiquette et des vues de données (figure 1). Nous apprenons en ayant deux points de vue sont générés par un pseudo-label l'autre point de vue, mettre ce problème en un problème d'apprentissage supervisé, et en mettant à jour l'étiquette et les paramètres du modèle pseudo-itératif, de sorte que les deux points de vue apprennent les uns des autres. Notre méthode proposée (appelée CVL) réduit l'erreur d'étiquettes surajustement, et a une performance de convergence plus stable.

NOUVEAU DOUBLE algorithme vue classification en fonction de la profondeur de l'apprentissage, l'utilisation complète des informations provenant de plusieurs balises de modélisation faible dans la surveillance de la sécurité, le contrôle du trafic aérien, la sécurité financière et d'autres domaines peuvent être appliqués, peut améliorer efficacement le niveau de sécurité et des affaires de contrôle des risques. Et le domaine de la sécurité avec des applications innovantes combiner améliorer considérablement la sécurité de renforcer le système de réglementation plus efficace de renforcer la capacité de combat de la sécurité, d'améliorer l'efficacité de la sécurité. Pendant ce temps, dans le domaine du contrôle des risques financiers, la technologie de sécurité innovante, dispose également d'un utilitaire stable.

Figure 1: nouvelle méthode pour le modèle logique

Nouvel algorithme Vue d'ensemble

Les nouvelles tentatives d'algorithme pour construire un classificateur dans l'espace de représentation et de l'espace d'étiquettes en deux vues, respectivement, dans le processus de formation, le résultat de deux classificateurs guident les uns des autres, la surveillance mutuelle, en alternance mise à jour itérative, la performance stable de la formation finale du classificateur.

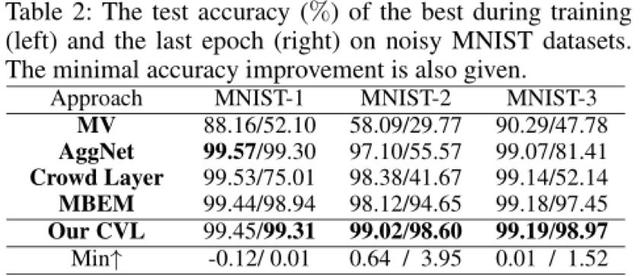

Des expériences ont été réalisées deux ensembles de données synthétiques (MNIST et CIFAR10) et un ensemble de données réelles (LabelMe AMT), les derniers résultats de comparaison a montré que, en termes de l'efficacité de la méthode CVL, la robustesse et la stabilité sont meilleurs que d'autres.

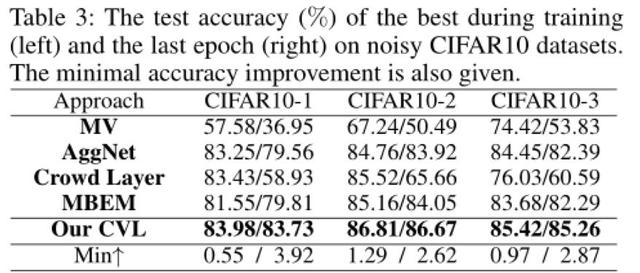

2 la figure, la figure 3: Dans les expériences de mnist ensemble de données synthétiques et cifar10, notre méthode est mieux que d'autres exemple de l'art antérieur des résultats en termes d'efficacité et de robustesse

Figure 4: Notre méthode est mieux que d'autres algorithmes sur la convergence de la stabilité

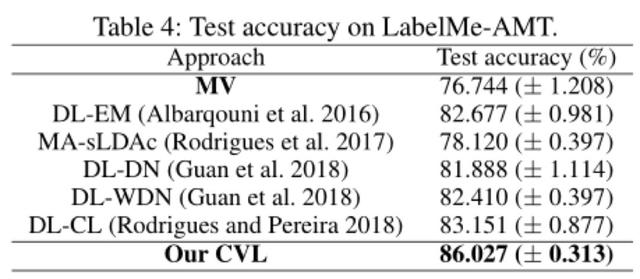

Figure 5: Les données réelles établies LabelMe AMT, nos résultats nettement en avance sur d'autres algorithmes existants

Méthodes de lecture

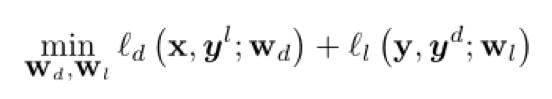

tout, nous pouvons d'abord être faible surveillance de la question de la recherche sur les deux points de vue les uns des autres problèmes d'apprentissage:

Après l'initialisation et pré-formation, ce problème peut être sous la supervision des balises prévues et les étiquettes mises à jour alternants recueillies en remplaçant la solution d'optimisation. Ce point de vue double perspective offre un moyen simple et de manière polyvalente, la polymérisation et l'échange de connaissances classificateur de données d'étiquettes avec l'autre.

Par la suite, nous avons adopté plusieurs stratégies en matière d'apprentissage en vue de promouvoir Converge d'apprentissage mutuel à un bon et des résultats stables.

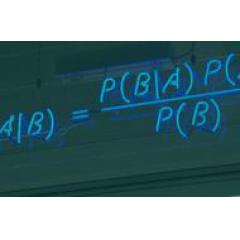

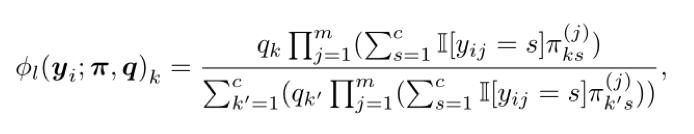

1, vue de l'onglet Le modèle de base. Si l'on suppose que le bruit de l'étiquette est le cas aléatoire et indépendante de chaque étiquette, nous avons utilisé une matrice comme des paramètres confus de bruit pour l'étude des classificateur bayésiens naïfs. Dans le cas où la catégorie de bruit et de la matrice de confusion q constant distribution a priori, la probabilité a posteriori de la classe k i-ième échantillon est calculée par l'équation suivante:

Modèle de formation. L'insuffisance des problèmes de formation seront rencontrés deux vues de vue, cela signifie que les informations fournies sont insuffisantes pour voir prédire adéquatement parfaitement tous les échantillons, ce qui inévitablement erreur de prédiction. Pour réduire l'impact de ce facteur, nous utilisons une petite perte de mesures en tant que mesure de confiance dans l'étiquette, pour effectuer la sélection de l'échantillon.

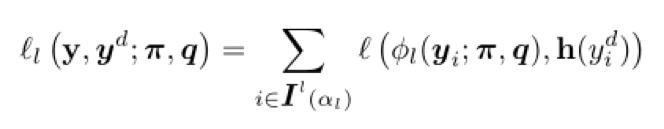

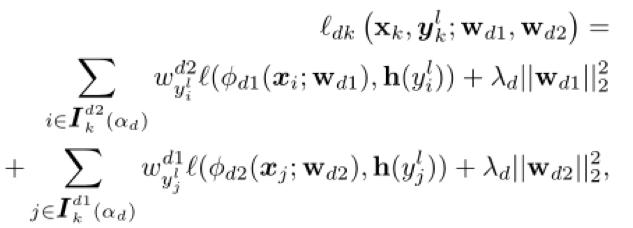

Compte tenu de l'étiquette, après une petite perte onglet de sélection métrique perte d'estimation de probabilité maximale comme suit:

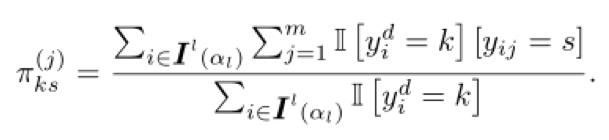

La fonction de perte, le paramètre peut être estimée par la formule suivante:

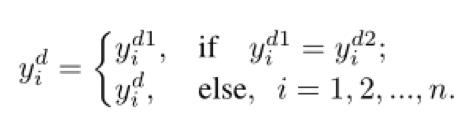

En outre, dans le cas des classes connues ensemble équilibré.

Mise à jour polymérisation tag. Chaque tour, l'étiquette met à jour son point de vue des étiquettes contrefaites une fois:

2, vue Le modèle de base. Depuis la profondeur du réseau a une grande capacité à apprendre, nous avons choisi les données de classificateur de réseau de neurones.

classificateur formé. En plus d'utiliser les mêmes petites mesures de perte, nous vous proposons également deux stratégies. Tout d'abord, puisque la profondeur du réseau de grande capacité, des données arbitraires peuvent être installées, après la perte petite métrique, initialisées en raison de différentes causes différentes biais de sélection d'erreur. Nous autres stratégies de co-enseignement adoptées pour réduire cet impact. Cela signifie que

Utilisez la même structure, mais deux réseaux différents et l'initialisation, et dans chaque lot, chaque réseau sera sélectionné une faible perte de l'échantillon considéré comme des connaissances utiles, et ces échantillons pour enseigner leur réseau de pairs pour paramètres de mise à jour. Étant donné que les deux réseaux ont différentes capacités d'apprentissage, qui peut filtrer les différents types d'erreurs causées par tag bruyante. En second lieu, puisque la catégorie échantillon sélectionné est généralement asymétrique, il est nécessaire d'ajouter les contraintes de l'équilibre des classes. Pour classificateur profondeur, étant donné que notre méthode sera choisie dans chaque lot d'échantillons, nous avons une perte dynamique de poids dans chaque catégorie dans le lot, afin d'éviter que certaines catégories de préférence sur un réseau.

Au cours de la formation, chaque époque, nous allons d'abord mélanger et en lot p ,, (k = 1, 2, ..., p). Ensuite, deux réseaux sélectionnés dans chaque lot d'échantillons d'un ensemble respectif de petites pertes à l'apprentissage du réseau de pairs. K-ième fonction de perte de charge suit comme:

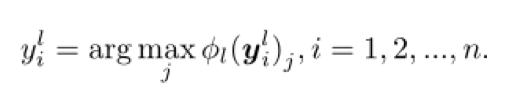

étiquette prévision actualisée. Chaque tour, dans le cas où deux sorties de réseau et les résultats de la classification, respectivement, par la vue de formule suivante met à jour l'onglet.

Actes de AAAI 2020: AAAI 2020 @ papier Wangjing interprétera (PPT télécharger )