[New Ji-won EXAMEN 20 jours à gauche en 2018, il n'a pas réduit la popularité de l'intelligence artificielle. En plus d'échecs, reconnaissance des visages, l'intelligence artificielle développée exactement dans quelle mesure? Résumé des réalisations les plus hautes études universitaires dans divers domaines, aujourd'hui, regardons la vision informatique et le langage naturel traitement situation réelle de ces deux axes de progrès en IA.

2018, AI en vie, les résultats continuent.

Bien que moins fréquemment l'an dernier, « au-delà de l'homme » dans l'esprit, mais « aide humaine » dans l'intelligence artificielle, et maintenant exactement dans quelle mesure? Soit la venue à une fin en 2018 quand, par un examen simple.

En dépit de la toxicité de conversation est l'intimidation dose, et des ensembles de données mis à part une tâche spécifique pour parler des progrès de l'intelligence artificielle, aussi. « État du art.ai » MIT et étudiants de l'UNAM font un site Web, intégré dans la vision couvre l'algorithme optimal ordinateur à jour, les jeux, le traitement du langage naturel, des diagrammes de réseau et base de connaissances, des procédures d'induction et la synthèse de programme , traitement audio, série de temps de traiter dans sept domaines.

Ici, nous avons basé sur des documents de recherche publiés, jetez un oeil sur le cas de la vision informatique et le langage naturel traitement de ces deux domaines de l'intelligence artificielle.

Vision par ordinateur

3D / reconstruction 3D

« 3D » peut être un CV mot maintenant les zones plus chaudes. Cette année, il y a diverses propagande téléphones intelligents fait référence à la « lumière structurée 3D. » Ensuite, le développement visuel 3D dans quelle mesure?

2017 CVPR, MIT, Université du Massachusetts à Amherst et chercheurs Google DeepMind a démontré le résultat, en utilisant un codeur automatique (VAE), construit un cadre appelé SingleVPNet, profondeur de multiples perspectives la figure ou un contour correspondant (Silhouette) génère le modèle d'apprentissage, en utilisant la fonction de rendu pour générer des images de détail fines de la forme 3D.

Non seulement cela, mais aussi par le cadre de leur projet de carte 2D intégré profondeur des perspectives différentes (même dans le cas de l'abri), une nouvelle génération de formes 3D.

0,35 SingleVPNet résultats d'erreur moyenne ont été obtenus sur les données de forme 3D fixe SharpNetCore. En d'autres termes, réaliste forme 3D générée par une certaine distance.

Supplément, SharpNetCore est un sous-ensemble de ShapeNet comprend actuellement 55 classes d'objets communs (couvrant le champ de vision informatique commun des ensembles de données de référence 3D PASCAL 3D + classe d'objet 12), environ 51.300 uniques modèles 3D, chaque modèle vous devez vérifier manuellement les catégories et aligner les commentaires, cofondée par Princeton, Stanford et de l'Institut Toyota (TTIC) membre du personnel technique.

reconnaissance d'action

des moyens de reconnaissance de mouvement identifiant différent de l'action vidéo, cela peut être à travers la vidéo, ou non. reconnaissance d'image d'identification de mouvement est prolongée, elle se rapporte à la reconnaissance d'image vidéo à partir d'une pluralité de trames, puis rassemble les résultats de chacun des châssis de prédiction.

2017 NeurIPS, les chercheurs CMU College of Robot Rohit Girdhar et Deva Ramanan utilisent des mécanismes de mise en commun d'intérêt (attentionnel), tout en maintenant la complexité et la quantité de l'informatique de réseau est essentiellement le même, l'identification des trois images fixes et des standards vidéo de mouvement améliorer l'identification de l'ensemble de données de référence de l'opération. Où, dans l'ensemble de données posture corporelle acquise MPII 12,5% amélioration relative.

Cependant, regardez la valeur absolue de la précision moyenne est toujours bloqué à 52,2 pour cent au-dessus.

reconnaissance des visages

Selon les résultats de l'Institut national américain des normes et de la technologie (NIST) a annoncé 16 Novembre de cette année dans l'industrie dite « étalon-or » dans le test de l'algorithme de reconnaissance globale du visage (de FRVT) conformément à des dizaines de millions par la technologie de carte précision de la reconnaissance sous une fausse alarme de 99%, le maintien gagnant du concours mondial de reconnaissance.

précision de la reconnaissance à des dizaines de millions de sous peu plus de faux positifs de 99%, ce qui signifie scène de sécurité de base plus critique est déverrouillé. Par rapport à la même période de l'année dernière, la performance globale de reconnaissance augmente de 80%.

Il est à noter que, dans le procès-verbal, publié en chinois pour montrer la force de la société de l'intelligence artificielle, selon les plans de la technologie (yitu), dynastie Shang technologie (sensetime), Kuang, comme la technologie (megvii) englobe les cinq sièges dans les dix premiers, plus classé cinquième sur l'Institut Shenzhen de la technologie de pointe Académie chinoise des sciences (de SIAT), la Chine a plus de la moitié de l'équipe, et « écran tyrans » fermement cinq, le leader mondial dans l'algorithme de reconnaissance faciale.

estimation de la pose humaine

En Février de cette année, la ligne de la politique de l'Université Jiaotong de Shanghai Lu sur mon équipe MVIG système de laboratoire AlphaPose, est la première dans le jeu de données COCO peut atteindre le système d'estimation de pose open source 70+ mAP.

Septembre, système AlphaPose mise à niveau à l'aide cadre PyTorch, l'estimation de la pose sur un ensemble de test standard ensemble de validation de COCO, obtenir la 71mAP de précision (spécifique OpenPose levage par rapport à 17%, masque RCNN opposant levage 8%), alors que la vitesse de 20fps (OpenPose rapport relativement augmenté de 66%, le masque-RCNN 300% d'augmentation relatif).

AlphaPose systèmes, deux étapes cadre est fondé RMPE (ICCV 2017 papier) groupe de l'Université de Shanghai Jiao Tong MVIG proposé la construction, par rapport à d'autres systèmes open source a considérablement amélioré la précision que OpenPose augmentation relative de 17%, masque RCNN augmentation relative 8.2 %.

Après la mise à niveau, chacun cadre ouvert performances COCO-validation, une seule carte indicateurs 1080ti temps GPU mesurés sont les suivants:

systèmes Open Source

précision

La vitesse moyenne

Openpose (CMU)

60 mAP

12 FPS

Masque-RCNN (Facebook)

67 mAP

5 FPS

Alphapose (SJTU)

71 Plan

20 FPS

Classification des images

Précision de l'ordinateur dans la tâche de classification d'image va au-delà de l'humain, et donc la précision actuelle de classification d'image les meilleurs résultats, souvent un sous-produit d'autres études. IPSC 2017, Google cerveau Barret Zoph et Quôc V. Le publié un « Neural architecture Recherche avec l'apprentissage par renforcement », ils recherchent automatiquement la structure du réseau de neurones avec l'apprentissage de renforcement, et en fin de compte la conception AI leur propre modèle, faire une image sur des ensembles de données ICRA-10 classement obtenu 96,35 pour cent de précision.

Peut-être surprenant, le meilleur résultat de la classification d'image est Facebook AI recherche de Benjamin Graham dans son 2015 traduit papier Arxiv « partiel Max-Pooling », après l'erreur est seulement après 100 tests sur-10 ICRA 3,47% . Ce document présente une nouvelle méthode de mise en commun max fractionnée et réduire le surajustement sur une variété d'ensembles de données.

Le générateur d'image

En ce qui concerne la génération d'images, que la nature est générée contre le réseau (GAN).

GAN de plus en plus cette année, année BigGAN IPSC DeepMind proposé, peut être décrit comme le modèle de génération d'image actuelle la plus forte, sur la formation IMAGEnet 128x128 résolution, BigGAN le score de lancement (IS) peut atteindre 166,3, Frechet la distance Inception (FID) 9.6.

A propos BigGAN plus de détails, voir ici.

GAN améliorer aussi l'avenir et dans quelle mesure, il convient d'examiner avec impatience!

La segmentation d'images

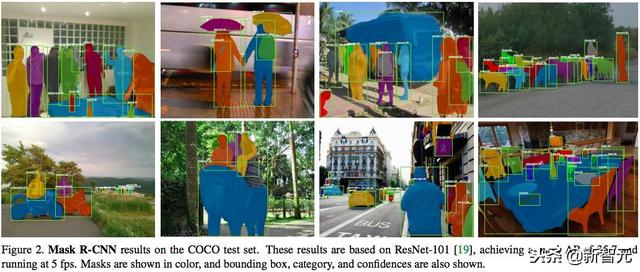

Oui, la segmentation d'image est ce que le roi Kai Ming et al., 2017 proposé Masque-RCNN, la valeur mAP 26,2.

Août 2018, l'Université du Michigan et des chercheurs de Google cerveau de proposer un cadre de traitement d'image sémantique hiérarchique qui peut réaliser la manipulation d'images au niveau des pixels et la compréhension sémantique, tout ajout dans l'image, le changement, les objets se déplacent, et transparente original, vrai « Il n'y a aucune trace de PS. »

Bien que pas encore des documents évalués par des pairs en rapport, mais les résultats du papier Arxiv rapporté, ils supérieurs dans la segmentation d'images Selon les chercheurs.

Traitement du langage naturel

Catégorie / sémantique similitude / grammaire / Critique de film / sémantiquement équivalent / Q / reconnaissance d'entités

BERT Le nom récemment dans le domaine de la PNL peut être décrit comme en plein essor.

13 octobre modèle BERT Google a publié une nouvelle équipe AI dans le niveau supérieur de la lecture de la machine SQuAD1.1 test de compréhension a exposé des résultats étonnants: La pleine mesure au-delà de l'humanité à la fois! Et aussi 11 tests différents PNL créer les meilleurs résultats , Y compris la référence COLLE poussé à 80,4% (amélioration absolue de 7,6%), la précision MultiNLI atteint 86,7% (le taux d'amélioration de 5,6% en valeur absolue) et similaires.

équipe Google Thang Luong directement défini: modèle BERT a ouvert une nouvelle ère de la PNL!

BERT nouveau modèle de représentation linguistique, ce qui représente la représentation du codeur bidirectionnel transformateur. Et autre langue récente représente un modèle différent, objectifs BERT Réglage commune dans le cadre de toutes les couches sont formés au préalable représente bidirectionnelle en profondeur . Par conséquent, peut être affiné par une couche de sortie supplémentaire représentation BERT pré-formation, pour construire le modèle le plus avancé est applicable à un large éventail de tâches.

Comme mentionné ci-dessus, BERT a établi un record de performance dans 11 tâches de la PNL! Dans un mouvement que l'un des résultats.

les résultats des tests COLLE, donnés par le COLLE serveur d'évaluation. Les chiffres ci-dessous chaque tâche représente le nombre d'exemples de formation. colonne « moyenne » des données avec les résultats officiels COLLE est légèrement différent, parce que nous avons écarté la question du jeu WNLI. résultats BERT et OpenAI TPG sont les données sous un seul modèle, une seule tâche. Tous les résultats de https://gluebenchmark.com/leaderboard et https://blog.openai.com/language-unsupervised/

Résultats. SQUAD BERT est d'utiliser différentes formations et affinent pré-intégrées les graines de point de contrôle (graines réglage fin) du système 7x.

, CoNLL-2003 Résultats de NER. parameter Ultra ensemble sélectionné par le développeur, les scores de développement et de test obtenus en utilisant ces paramètres sur la moyenne des cinq redémarrage aléatoire.

Dans l'ensemble, le numéro de modèle BERT des tâches dans le domaine de la PNL est actuellement obtenu les meilleurs résultats, y compris

Classification, similarité sémantique, grammaire, critiques de films, l'équivalence sémantique, questions et réponses, la reconnaissance de l'entité et ainsi de suite.

raisonnement Commonsense

le raisonnement du sens commun (Commensense Inference), a atteint le niveau le plus avancé est Antonio Lieto, qui en 2017 a publié l'article: Double PECCS: un système cognitif pour la représentation conceptuelle et la catégorisation .

Bien sûr, le résultat de l'article est actuellement le meilleur sur le concept de précision de la classification (Concept de précision Catégorisation), 89, mais dans Dev et la précision de test, le modèle actuel est toujours les meilleurs résultats BERT, respectivement 86,6 et 86,3.

traduction automatique

Dans les tâches de traduction automatique (traduction automatique), a maintenant atteint les meilleurs résultats de l'article Zhen Yang et al, publié le Arxiv en Avril de cette année.:

L'algorithme principal de l'article combinats Transformer + BR-CSGAN, la notation des résultats obtenus dans l'UEBL est 43,01, est actuellement les meilleurs résultats.

inférence de langage naturel

En mission de l'inférence de langage naturel (langage naturel Inference), actuellement les meilleurs résultats de l'article Yichen Gong et al, Publié le Arxiv en mai de cette année.:

L'algorithme utilise un DIIN de papier, en termes de taux de précision est actuellement 89,84, actuellement au niveau optimal.

Ce sont les derniers développements dans la vision informatique et le traitement du langage naturel dans les deux zones. AI veulent connaître les résultats meilleurs dans d'autres domaines chaque tâche accomplis à ce jour peut se référer aux liens suivants:

https://www.stateoftheart.ai/