Source: New Ji-won

Cet article sur 4200 mots Suggestions de lecture 10+ minutes.

Cet article facile à comprendre pour expliquer l'apprentissage de la machine, et nous nous efforçons de donner aux lecteurs aucune formation scientifique peut comprendre.

Bien qu'il y ait beaucoup de cours dans l'apprentissage de la machine, le MIT, sur Coursera UC Berkeley, et d'autres experts, y compris des cours Andrew Ng ont été très classique, mais il y a un certain arrière-plans scientifiques sont des professionnels. Cet article tente de la machine d'apprentissage ce cours ésotériques pour être plus facile à comprendre de parler, pas d'arrière-plan de la science afin que les lecteurs puissent comprendre.

Le complexe simple choses, à des laïcs peut comprendre en peu de temps, et exposé expression soudain réalisé, est une compétence très puissante.

Par exemple. Vous postulez ingénieur d'apprentissage machine, face à un fond d'arts libéraux dans les RH, si nous pouvons dans les plus brefs délais pour lui faire savoir votre expertise, peut grandement améliorer le taux de réussite de l'entrevue.

Maintenant, l'apprentissage machine un tel feu, voudrait rejoindre de plus en plus de gens, cependant, étaient les gens confus de plus en plus. Parce que le public est difficile de comprendre pourquoi l'apprentissage de la machine? Les mystérieux concept d'une bouchée, comme la régression logistique, descente de gradient à la fin est quoi?

Un professionnel de l'étudiant de pharmacologie de 23 ans a dit que quand il est allé assister à un cours de formation sur l'apprentissage de la machine, la grand-mère se sentait à la maison qui ne comprennent pas la technologie moderne.

Puis un homme nommé Audrey Lorberfeld diplômés en essayant de diviser entre l'apprentissage public et la machine, les mains de remplissage. Donc, avec cette série d'articles.

La première conférence de cette série:

- descente de gradient

- régression linéaire

- La régression logistique

Algorithmes vs modèle

Avant de comprendre commencer à comprendre l'apprentissage de la machine, nous devons apprendre à connaître deux concepts de base: algorithmes et modèles.

Nous pouvons modèle considéré comme un distributeur automatique, entrée (argent), la sortie (Coca-Cola). L'algorithme est utilisé pour former le modèle,

Modèle sur la base de l'entrée donnée, la prise de décision correspondant pour atteindre le résultat souhaité. Par exemple, un algorithme basé sur le montant investi, le prix unitaire de Coca-Cola, déterminer assez d'argent, si plus que cela beaucoup d'argent pour trouver.

Dans l'ensemble, l'algorithme est un modèle mathématique de la vitalité derrière. Aucun modèle, un algorithme est juste une équation mathématique. Différents modèles, en fonction de l'utilisation de différents algorithmes.

descente de gradient / la mieux adaptée ligne

(Bien que cela ne soit pas considéré comme un algorithmes d'apprentissage machine traditionnelle, mais comprendre gradient de savoir combien d'algorithmes d'apprentissage machine à disposition, et comment optimiser critique.) Descente de gradient nous aider, selon certaines données, les prévisions les plus précises.

Par exemple. Avez-vous une grande liste, tout le monde la liste que vous connaissez la taille et du poids. Ce profil est ensuite fait de ce qui suit:

La figure ci-dessus un nombre assez étrange? Ne pas se soucier de ces détails.

Maintenant, qui se tiendra dans un quartier résidentiel sur la taille et jeu de devinettes de poids, le gagnant étant des enveloppes rouges. Pour utiliser cette image. Comment faites-vous?

Vous pouvez tracer une ligne sur le graphique, cette ligne donne la correspondance parfaite entre la hauteur et le poids.

Par exemple, selon cette ligne parfaite 1,5 mètres de haut 60 kg personne en poids de manière substantielle. Eh bien, voici comment trouver la racine du hors ligne parfaite de celui-ci? A: descente de gradient.

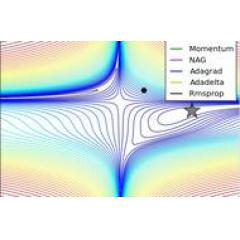

Mentionnons un concept appelé RSS (la somme résiduelle des carrés). RSS est le carré de la différence entre les points et les lignes et cette valeur représente la distance à quelle distance des points et des lignes. descente de gradient est de trouver la valeur minimale de RSS.

Chaque fois que nous recherchons cette ligne pour visualiser les différents paramètres, vous obtenez quelque chose appelé la courbe des coûts. Le point où la courbe est notre minimum de RSS.

Descent gradient trouvées (en utilisant Matplotlib)

scientifiques données de l'incroyable Bhavesh Bhatt

descente de gradient il y a d'autres segments, comme « étape » et « taux d'apprentissage » (qui est, dans quelle direction nous voulons prendre part à la fin du fond).

En bref, nous trouvons le plus petit espace entre les points de données et le meilleur ajustement ligne par descente de gradient, et la meilleure ligne que vous êtes et nous ne prédisons la base directe.

régression linéaire

La régression linéaire est variable entre une autre une ou plusieurs variables (variables indépendantes), la relation entre l'intensité de la méthode d'analyse.

La régression linéaire des signes, comme son nom l'indique, à savoir la relation entre les variables indépendantes et les variables de résultat est linéaire, qui est de dire la relation entre les variables peut Citylink une ligne droite.

Il semble que nous faisons ce qui précède! En effet, les meilleures pratiques de la droite de régression linéaire avant dans notre « régression ». Les meilleurs spectacles de la meilleure ligne d'ajustement de la relation linéaire entre notre point. À son tour, cela nous permet de faire des prédictions.

Un autre objectif est de régression linéaire, les résultats d'une variable ou « varie en fonction d'autres variables » variable (bit autour Ha) est toujours continue. Mais qu'est-ce que cela veut dire?

Supposons que nous voulons mesurer les facteurs qui influencent les précipitations, État de New York: La variable de résultat est la pluviométrie, est ce que la plupart de nos relations, et l'impact des précipitations variable indépendante est au-dessus du niveau de la mer.

Si la variable de résultat n'est pas continue, il peut apparaître dans une certaine altitude, aucune variable de résultat, nous ne pouvons pas faire des prédictions conduisent.

A l'inverse, une altitude donnée, nous pouvons faire des prédictions. C'est là le plus cool de régression linéaire!

LASSO régression et la régression des crêtes

Maintenant, nous savons ce qu'est une régression linéaire, alors il y a des frais, comme la régression de la crête. Au début de la régression de la crête compréhension avant de commencer à comprendre la régularisation.

Autrement dit, les scientifiques utilisent des données de régularisation, assurez-vous que le modèle concerné uniquement avec des variables indépendantes peuvent avoir un impact significatif sur les variables de résultats.

Mais ces résultats ne touchent pas de manière significative l'argument sera régulièrement ignoré? Bien sûr que non! La raison derrière nous et puis développez pour entrer dans les détails.

En principe, nous créons ces modèles, les données d'alimentation, puis tester notre modèle est assez bon.

Peu importe si les arguments ne sont pas pertinents corrélation Ye dans l'alimentation, et enfin nous allons trouver le modèle impressionnant dans le traitement des données de formation, mais le traitement des données de test sur notre super mauvais.

En effet, notre modèle est pas assez souple, le visage de nouvelles données devient un peu à perte. Cette fois, nous appelons « surajustement » ou « sur-apprentissage. »

Ensuite, nous passons un long exemple, pour comprendre ce que surajustement.

Disons que vous êtes une nouvelle maman, votre bébé aiment manger des nouilles. Pendant des mois, vous développez une fenêtre dans les habitudes de cuisine et d'alimentation, parce que vous aimez l'air frais.

Ensuite, vous donnez à votre bébé un tablier de neveu, donc il ne mangeriez pas couvert sont confus, et vous développez une nouvelle habitude: pour nourrir le bébé à manger des nouilles, il doit porter un tablier.

Ensuite, vous tournez un chien errant adoptiez, chaque fois que le bébé à manger chien accroupie à côté de la chaise, en attendant de manger le bébé est tombé les nouilles.

En tant que nouvelle maman, vous pensez naturellement, fenêtres ouvertes + tablier + chaise bébé suivant le chien, est de rendre votre bébé heureux de pouvoir manger des nouilles condition sine qua non.

Jusqu'au jour où vous rentrez chez vous le week-end. Lorsque vous trouvez la cuisine, pas de fenêtres vous un peu nerveux, alors vous voulez soudainement dépêchez-vous et aller tabliers n'ont pas pris, le plus terrible est remis à un voisin pour occuper les chiens, mon Dieu!

Vous panique débordés qu'ils oublient de nourrir le bébé, le mettre directement au lit. Regardez, lorsque vous êtes confronté à une toute nouvelle scène vous agissez très mauvais. La maison est tout à fait une autre sorte de style.

Après un modèle redessiné, filtre tout le bruit (données non pertinentes) vous trouvez que, en fait, le bébé comme les pâtes vous fait moi-même.

Le lendemain, vous pourrez au calme dans une cuisine sans fenêtre, ne pas porter des tabliers au bébé, il n'y a pas de chien à côté, nourrir avec bonheur le bébé à manger des nouilles.

Ceci est la machine d'apprentissage fait regularization've: faire de votre modèle ne concerne que des données utiles, en ignorant distracteurs.

A gauche: la régression LASSO (vous pouvez voir le coefficient rouge représenté rung en passant par l'axe y peut être égal à zéro)

A droite: Ridge régression (vous pouvez voir le coefficient est proche de, mais pas égal à zéro, parce qu'ils ne passent jamais par l'axe y)

Source: Prashant Gupta "régularisation de l'apprentissage machine"

Dans une variété de régularisation, il y a un facteur de pénalité que l'on appelle (la lettre grecque lambda: ). Le rôle de facteur de pénalité dans les calculs mathématiques, réduit le bruit dans les données.

Dans la régression des crêtes, parfois appelé « L2 retour », la valeur du facteur de pénalité est le carré des variables et des coefficients. Facteur de pénalité réduire le coefficient de la variable indépendante, mais jamais les éliminer complètement. Cela signifie que par régression de crête, modèle de bruit sera toujours votre modèle en compte.

Une autre régularisation est LASSO ou régularisation « L1 ». En régularisation LASSO, la seule peine caractéristiques élevées de coefficient, au lieu de chaque donnée de caractéristique de la peine.

De plus, LASSO peut être coefficient a été réduit à zéro. Cela permettra d'éliminer essentiellement ces caractéristiques de l'ensemble de données parce que leur « poids » est maintenant zéro (ils sont effectivement multipliés par zéro).

Par modèle de régression LASSO il est possible d'éliminer la majeure partie du bruit dans l'ensemble de données. Ceci est utile dans certains cas!

La régression logistique

Nous savons maintenant que l'impact de certaines variables de régression linéaire = une autre variable, et il y a deux hypothèses:

- Le résultat est une variable continue;

- La relation entre les variables et les variables de résultat est linéaire.

Mais si la variable de résultat n'est pas continue, mais catégoriser les terres? Cette fois-ci sur l'utilisation de la régression logistique.

Les variables qualitatives ont été seulement appartiennent à une seule catégorie de variables. Par exemple, pour chaque semaine est du lundi au dimanche sept jours, alors vous ne pouvez pas le faire de prédire le nombre de jours.

Le premier jour de la semaine est le lundi, ce qui est arrivé lundi, ce qui est arrivé lundi. Rien de mal.

probabilité de sortie de modèle de régression logistique a une seule catégorie ou les autres points de données, plutôt que de la valeur conventionnelle. Ceci est également le modèle de régression logistique est principalement utilisé pour des raisons de classification.

Dans le monde de la régression logistique, les résultats des variables de probabilité log et variables indépendantes (log odds) a une relation linéaire.

- Ratio (odds)

Le noyau est de cotes de régression logistique. Par exemple:

Une classe a 19 élèves, dont six filles, garçons 13. Les femmes assument la chance de passer l'examen est de 5: 1, tandis que le mâle est 3:10 chances de passer l'examen. Cela signifie que six femmes, il y a cinq possible de passer le test, alors que 13 hommes ont trois passes possible le test.

Ainsi, les cotes et les probabilités (probabilité) ne sont pas les mêmes? Il n'est pas.

mesure de probabilité est le rapport du nombre total de nombre d'incidents et toutes les choses qui se passent, par exemple, jeter une pièce 40 fois 10 fois est une probabilité positive est de 25%, le rapport entre le nombre de fois les chances d'événements de mesure des événements, tels que le lancer 30 fois sur 10 est positif, les chances désigne le positif: 10 fois 30 fois en arrière.

Cela signifie que même si la probabilité est toujours limitée dans la gamme de 0-1, mais les chances peut être continuellement augmenté de 0 à l'infini!

Cela nous donne le modèle de régression logistique pose un problème, parce que nous savons que notre production attendue est la probabilité (numéros 0-1).

Alors, comment pouvons-nous de chances de probabilité?

Réfléchissons un problème de classification, comme votre équipe de football préférée et l'autre compétition par équipe, remportant six matchs. Vous pourriez dire que les chances de votre équipe a perdu 1: 6, ou 0,17.

Et les chances de gagner de votre équipe, parce qu'ils sont une grande équipe, est de 6: 1 ou 6. Figure:

Source:

https://www.youtube.com/watch?v=ARfXDSkQf1Y

Maintenant, vous ne voulez pas que votre modèle pour prédire votre équipe va gagner le prochain match, tout simplement parce que leurs chances de gagner beaucoup plus que la dernière chance de leurs échecs passés, non?

Il y a plus de facteurs à prendre en modèle considéré (peut-être le temps, peut-être les entrées, etc.)! Par conséquent, afin de rendre la taille des chances uniformément distribués ou symétriques, il fait référence à certaines des choses que nous calculons le rapport du logarithme (log-odds) a.

- log-odds

Notre soi-disant « normale »: la courbe en cloche classique!

Log-odds est le logarithme naturel de chances de sténographie. Lorsque vous utilisez quelque chose de naturel pour le numéro, vous pouvez essentiellement rendre la distribution plus normale. Lorsque nous faisons la distribution des choses plus normales, nous mettons essentiellement sur la balance un très facile à utiliser.

Lorsque nous utilisons les log-odds, les chances que nous allons aller de 0 à l'infini positif est converti à l'infini négatif à l'infini. Il peut être vu sur la surface supérieure de cette courbe en forme de cloche.

Même si nous avons encore besoin d'exporter entre 0-1, nous faisons l'acquisition par log-odds de symétrie pour obtenir ce que nous voulons sortie plus que jamais!

- fonction logit

« Fonction Logit » que nous devons obtenir log-odds et faire des maths!

terreur indescriptible mathématique. Euh, je veux dire la fonction logit.

fonction logit, tracée graphiquement

Comme vous pouvez le voir ci-dessus, la fonction logit par celui qui est le logarithme naturel de chance à notre infini négatif à l'infini.

- fonction sigmoïde

D'accord, mais nous n'avons pas atteint le degré de modèle de probabilité pour nous. Maintenant, tous nos chiffres sont l'infini négatif à l'infini des nombres. Nom: Fonction sigmoïde.

fonction sigmoïde, a présenté sa forme tandis que le nom de dessin, juste l'inverse des log-odds. Obtenu par les log-odds inverse, nous valorisons notre cartographie grand plus l'infini de l'infini moins à 0-1. À son tour, nous obtenons la probabilité, qui est ce que nous voulons!

Contrairement à la fonction logit de motif, dans lequel la valeur de y notre grande plage de l'infini négatif à l'infini positif, nous modèle sigmoïde de fonction ayant une valeur y de 0-1. Très bon!

Avec cela, nous pouvons maintenant insérer une valeur de valeurs x et y prédites retracée. La valeur y est la probabilité que la valeur x dans une catégorie ou l'autre catégorie.

- estimation du maximum de vraisemblance

Vous souvenez-vous que nous sommes la meilleure ligne d'ajustement pour trouver des moyens comment minimiser le RSS (parfois appelée méthode « moindres carrés ordinaires » ou OLS) ligne de régression en elle?

Ici, nous utilisons appelé l'estimation de vraisemblance maximale (MLE) choses pour obtenir les prévisions les plus précises.

MLE décrit le mieux nos données en déterminant le paramètre de distribution de probabilités pour nous fournir des prévisions les plus précises.

Pourquoi devrions-nous nous préoccuper de la façon de déterminer la répartition des données? Parce qu'il est cool! (Non)

Il est tout simplement plus facile d'utiliser nos données et notre modèle peut être généralisé à de nombreuses données différentes.

En général, afin d'obtenir MLE nos données, nous attirons votre attention sur les données s-courbe et les ajoute à la vraisemblance.

Au fond, nous voulons trouver des données Maximize log-vraisemblance de la courbe s. Nous continuons simplement de calculer le nombre de lignes par log-odds-vraisemblance (similaire à notre flux RSS pour chaque meilleur ajustement régression linéaire faire) jusqu'à ce que nous obtenons le nombre maximum.

Eh bien, jusqu'à présent, nous savons ce qui est une descente de gradient, la régression linéaire et un examen logique, la prochaine à parler, par la sur Audrey pour expliquer les arbres de décision, les forêts aléatoires et SVM.

Les liens de référence:

https://towardsdatascience.com/machine-learning-algorithms-in-laymans-terms-part-1-d0368d769a7b

Editeur: Huang Jiyan

Commenté par: Lin Yilin

- FIN -

attention Tsinghua - données Académie des sciences de Qingdao plate-forme publique micro-canal officiel " données d'envoi THU « Sisters et n ° » Les données envoyées THU « Pour plus de conférences et de bien-être contenu de qualité.