Le contenu principal sont les suivantes:

- statut en temps réel de la seule plate-forme de produits

- la pratique Flink seulement la volonté du produit

- Flink Sur K8S

- Planification de la relève

Tout d'abord, le statut sera le seul produit est actuellement une plate-forme en temps réel cadre informatique unifiée dans les produits CD sera plate-forme en temps réel, mais comprend Storm, Spark, Flink, y compris les trois principaux cadre informatique. Pour des raisons historiques, le nombre d'emplois actuellement sur la plate-forme Storm est le plus grand, mais depuis l'année dernière, l'accent d'affaires mis progressivement à Flink ci-dessus, il a été une augmentation substantielle du nombre de demandes cette année Flink ci-dessus.

Les grands panneaux d'affichage promotion des indicateurs statistiques, y compris les différentes dimensions (par exemple, des recommandations en temps réel en tant que fournisseur clé de l'électricité d'affaires, plus de fonctionnalités en temps réel comprennent :: diverses dimensions de l'ordre, les UV, les taux de conversion, l'activité de la plate-forme à temps réel entonnoir noyau se compose de huit parties etc.), pour la direction, les opérations, les décisions de ce produit à l'utilisation, le nettoyage des données en temps réel, enterré à partir du point d'utilisateur des données collectées, nettoyées et associé en temps réel, fournir de meilleures données pour chacune des activités en aval, en plus des services bancaires d'Internet, la sécurité du vent contrôle, et les amis de parité et d'autres services, ainsi que Logview, Mercure, Titan servant de système de contrôle interne, les systèmes de synchronisation de données VDRC en temps réel.

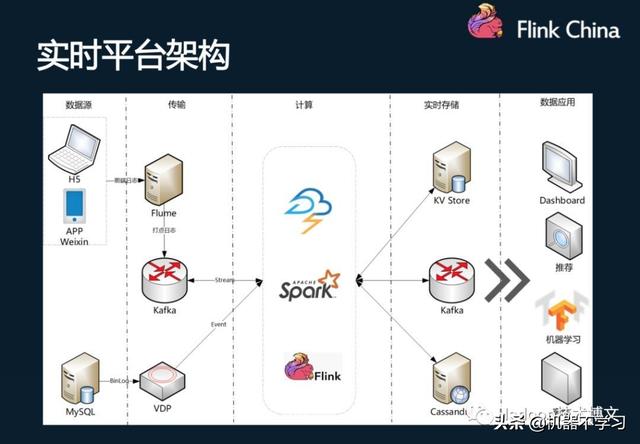

Les responsabilités comprennent la plate-forme en temps réel pour les plates-formes de calcul en temps réel et la base de données en temps réel. plate-forme de calcul en temps réel sur la base du cadre de calcul Tempête, Spark, Flink et ainsi de suite, de surveiller, la stabilité a fourni une garantie pour fournir des données d'entrée et de sortie pour le développement des affaires. base de données en temps réel contenant la définition et la normalisation du point en amont enterré, les données de comportement des utilisateurs, les journaux de données MySQL de nettoyage Binlog, jouant un traitement tel que large, fournir l'assurance de la qualité pour les données en aval.

Dans la conception du cadre, y compris les deux sources de données. On est enterré dans les données de point App, micro-lettres, H5 et d'autres applications, après kafka envoyés à la collecte de données primaires, l'autre est une ligne de journal MySQL Binlog données en temps réel de. Pour le calcul des données de trame qui ne association de nettoyage, les données brutes fournissant plus facile à utiliser par les applications d'entreprise en temps réel en aval ETL (y compris la largeur de la table en ligne, etc.).

Deux, scène Flink pratique d'un produit CD sera: Dataeye en temps réel Kanban

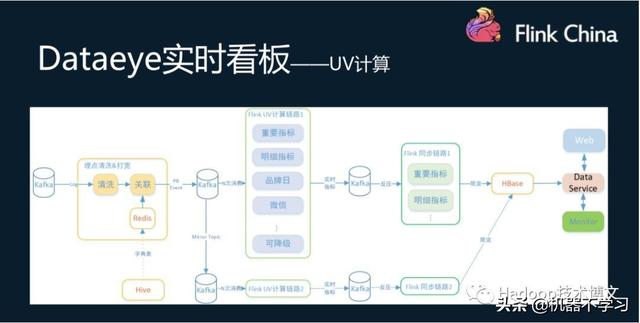

Dataeye en temps réel Kanban est les données pour appuyer la nécessité pour tous le point enterré, lorsque les commandes données calculées en temps réel, avec une grande quantité de fonctionnalités de données et nécessitent dimension statistique il y a beaucoup, comme station totale, deux plates-formes, catégorie, calendrier, foule activités, telles que la dimension temporelle, augmentent la complexité des calculs, l'indice de production de données statistiques a atteint des centaines de milliers par seconde.

UV pour calculer, par exemple, d'abord, les données de Kafka Buried lavées, puis les données associées à Redis, de bonnes données de corrélation sont écrites dans Kafka, les tâches de calcul Flink données associées à la consommation ultérieure de Kafka. Les résultats des calculs sont généralement tâche est grande (en raison notamment des dimensions de calculer et de mesures, peuvent atteindre des dizaines de millions), la sortie de données par aussi par Kafka comme un tampon, tâche de synchronisation de l'utilisation finale pour synchroniser HBase, comme l'affichage des données en temps réel. tâche de synchronisation écrirait limite de données HBase et le même type de fusion de l'indice, la protection des HBase. En même temps, il y a une autre façon de calculer comme un plan de reprise après incident.

Lorsque le calcul de tempête pour calculer le moteur est nécessaire d'utiliser comme un stockage REDIS état intermédiaire, mais après le passage à Flink, Flink lui-même comprend un stockage d'état, économisant de l'espace de stockage; Redis parce qu'aucun accès, mais aussi d'améliorer les performances, la ressource globale la consommation est réduite à 1/3 de l'original.

Dans le processus de tâches informatiques migrent progressivement de Storm à Flink, les deux programmes doivent migrer en même temps pour séparer les tâches informatiques et la synchronisation des tâches, les données sont écrites pour atténuer la pression sur la HBase.

Après le passage à Flink aussi besoin de suivre et d'améliorer un certain nombre de questions. Pour FlinkKafkaConsumer, pour des raisons d'affaires à kafka dans AOTU Commit à modifier, et le réglage du décalage, il est nécessaire de réaliser son soutien commutation de cluster de kafka. Pour les données d'état sans la nécessité de nettoyer manuellement la fenêtre. Il existe un cadre informatique problème commun - les problèmes de données doivent être pris en compte. En même temps, le nombre de tâches pour problème de poursuite synchrone, la tempête peut prendre des valeurs des Redis, Flink ne peut attendre.

Scène deux: Kafka Shuojuluode HDFS

Avant de réaliser tout au long de Spark Streaming, maintenant il est progressivement mis à Flink ci-dessus, le tableau de données Buried Ruche OrcBucketingTableSink sur le sol pour les HDFS. Flink en mono processus d'écriture des tâches jusqu'à 3,5K / s ou plus, après utilisation Flink consommation de ressources réduite de 90%, tout en réduisant le retard dans les années 30 à 3. À l'heure actuelle faire encore un soutien Flink pour le tableau Bucket Spark de.

Troisième scène: ETL-temps réel

Pour le traitement ETL, la présence est un point de mal à HDFS, et est en constante évolution de stockage de table dictionnaire, et les besoins de flux de données en temps réel pour se joindre à la table dictionnaire. Changement dans le tableau dictionnaire est causée par une tâche de traitement par lots hors ligne, la pratique actuelle est d'utiliser ContinuousFileMonitoringFunction et ContinuousFileReaderOperator le moniteur de synchronisation HDFS changements de données, les nouvelles données continueront dans les broussailles, les données les plus récentes ne rejoignent les données en temps réel.

Ensuite, nous prévoyons de faire d'une manière plus générale, à la table de soutien et Hive Stream, joindre, mettre en uvre des changements de données de table Hive, les données sont automatiquement poussé effet.

Trois, Flink Sur K8S

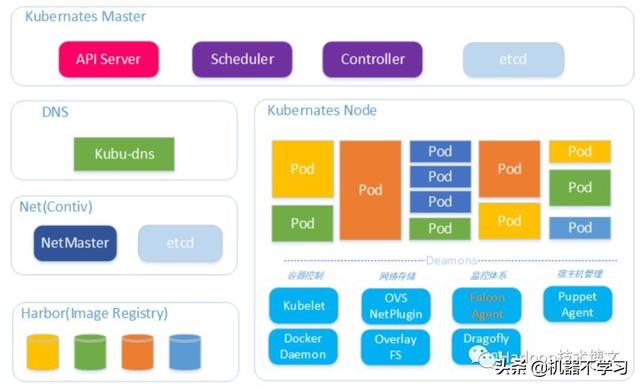

Il y a un certain nombre de différents cadres de l'informatique à l'intérieur du seul produit avec calcul en temps réel, il y a un apprentissage de la machine, ainsi que des calculs hors ligne, et donc la nécessité d'un cadre sous-jacent unifié pour la gestion, et donc migrera Flink au K8S.

Utiliser des composants de réseau Cisco sur K8S, chaque conteneur de docker a sa propre adresse IP, l'extérieur est visible. Fusion plate-forme temps réel architecture globale, comme indiqué ci-dessous.

Les différences dans la mise en uvre du programme seront fournis sur la communauté K8S Flink et le produit n'est encore très important. CD produits utiliseront le mode de déploiement K8S StatefulSet, la mise en uvre interne d'un certain nombre d'interfaces liées cluster. Un travail correspondant à un mini cluster et supports HA. Pour Flink, la plus grande raison d'utiliser StatefulSet une nacelle de nom d'hôte est ordonnée, de sorte que les avantages potentiels sont les suivants:

1.hostname de pod -0 -1 et peut être spécifié directement JobManager, peut être utilisé pour démarrer une statefulset un cluster, le déploiement doit être de 2, indépendamment l'un de TaskManager Jobmanager et le déploiement.

2. pod après pour diverses raisons échouent, en raison StatefulSet tirer à nouveau la nacelle du même nom d'hôte, le cluster récupérer le rapport de vitesse peut théoriquement un déploiement plus rapide (déploiement chaque nom d'hôte aléatoire).

Environnement miroir variable docker script qui entrypoint doit être réglé instructions d'installation:

grappes Flink correspondant à compter sur d'autres configurations telles que HDFS, à travers la création de ConfigMap pour gérer et maintenir.

kubectl créer ConfigMap hdfs-conf --from-file = hdfs-site.xml --from-file = core-site.xml

En quatrième lieu, le plan de suivi

systèmes à temps réel en cours, la plate-forme d'apprentissage de la machine pour les données à traiter dans une variété de composants de stockage de données distribuées, comme Kafka, Redis, Tair et HDFS ainsi de suite, comment un accès pratique et efficace, le traitement, le partage des données est un grand défi pour le courant accès aux données et la détermination prend souvent beaucoup d'énergie, un des points de douleur principaux comprennent:

Pour Kafka, Redis, Tair en binaire des données (format PB / Avro), les utilisateurs ne peuvent pas comprendre rapidement et directement le schéma et les données de contenu, les coûts d'acquisition de données de contenu et de communication sont élevés et l'écrivain.

Étant donné que l'absence d'un ensemble de données des services de système indépendant unifié, l'accès aux données binaires à Kafka, Redis, Tair et comme le besoin de compter sur les informations fournies par l'auteur, tels que la génération de classe proto, les définitions de format de données wiki, les coûts de maintenance élevés, sujettes à erreur.

L'absence de schéma relationnel afin que l'utilisateur ne peut pas directement basée sur une utilisation plus efficace SQL ou une entreprise de développement API couche LINQ.

Un des services pratiques distinctes pour publier et partager des données ne peuvent pas passer.

données en temps réel ne peuvent être fournis directement au lot moteur SQL.

De plus, pour la plupart de la source de données actuelle est aussi un manque de vérification d'accès, la gestion des droits, contrôle d'accès, le suivi et d'autres caractéristiques.

UDM (Unified Data Management System) comprend un emplacement gestionnaire, le schéma Metastore et des modules client proxy, principales caractéristiques comprennent:

1. Fournir un nom au service de mappage d'adresses de l'utilisateur pour accéder aux données par nom plutôt que l'adresse spécifique abstraite.

2. Les utilisateurs peuvent facilement via l'interface GUI Web facilement visualiser les données de schéma, le contenu des données d'exploration.

3. Fournir un soutien pour l'audit, le suivi, l'API client proxy fonctionnalités supplémentaires telles que la traçabilité.

4. Spark / Flink / Storm comme cadre, l'encapsulation des sources de données fournissant la forme la plus appropriée.

UDM structure globale tel que représenté sur la Fig.

les utilisateurs UDM, y compris les producteurs et les utilisateurs de temps réel, la plate-forme d'apprentissage automatique et les données hors ligne. Lorsque vous utilisez l'API SQL ou l'API de table, d'abord terminer l'enregistrement du schéma, puis utiliser le développement Sql, ce qui réduit la quantité de développement de code.

Tableau de calage de l'allumage pour accéder aux données décrit Kafka PB processus internes de l'UDM

Dans Flink, un UDMExternalCatalog de pont entre l'ouverture et le cadre de calcul UDM Flink, en mettant en oeuvre ExternalCatalog chaque interface, et de mettre en uvre la TableSourceFactory de source de données respective, l'accomplissement des fonctions de contrôle d'accès, etc. Schéma