Et d'erreurs lorsque des solutions sont proposées ici scrapy et l'installation et la configuration PyCharm, alors que l'interprétation des exemples de « ramper cresson neuf points de livres, » le réseau tutoriel classique, chaque Code étape donne la compréhension à l'éditeur, et les erreurs possibles de proposer une solution, et utilisable.

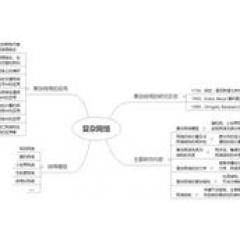

annuaire

I. introduction

II. Principe

2.1 processus d'analyse

Dictionnaire blocs départements 2.2

Analyse 2.3 flux de données scrapy

III. Comprise

IV. Combat

4.1 La première consiste à installer scrapy

4.2 projet de construction et télécharger la configuration PyCharm et PyCharm

titre 4.3 extrait et le nom auteur

4.4 scrapy analyse des flux

4,5 heures Difficulté Approfondir

V. projet pour établir un scrapy de rétroaction

5.1 Comment trouver le bug plus rapide

5.2 interprète peut conduire à la coexistence d'une variété d'erreur

VI. Connaissances supplémentaires

6.1 cours de Spider et méthodes

I. introduction

Scrapy pour le développement Python d'un rapide, l'écran de haut niveau de grattage et d'un cadre pour l'exploration exploration du Web des sites Web et d'extraire des données structurées à partir de la page. Scrapy large gamme d'utilisations, peut être utilisé pour l'extraction de données, la surveillance et les tests automatisés.

Les amateurs de reptiles là croient que les avantages scrapy est un degré élevé de reptiles pour l'étude et de la technologie de recherche autodéfinie, d'apprendre des connaissances est plus grande, et donc la réalisation d'un robot plus de temps. Il a également été dit, scrapy pas couru python3 ci-dessus, l'applicabilité ne pense pas si brillante.

Populaire crawler Web, il est un programme dirigé vers rampent ou des données sur Internet, la description est plus professionnel, analyse des données HTML pour une pages du site spécifique. Approche générale des pages d'exploration que la définition d'une page portail, puis une page ont généralement une URL vers une autre page, donc il a rejoint l'URL de la page actuelle à partir de laquelle pour se rendre à la file d'attente d'exploration de reptiles, puis entrez la nouvelle page puis récursive les opérations ci-dessus.

II. Principe

Scrapy Utilisez les bibliothèques de réseau Twisted pour gérer le réseau de communication asynchrone, l'architecture claire et contient une variété d'interfaces middleware, la souplesse nécessaire pour compléter une variété de besoins.

Dans notre première tentative de comprendre les résultats et les principes d'exploitation Scrapy de temps, nous utiliserons cette présentation graphique:

2.1 processus d'analyse

La ligne verte sur le graphique est le flux de données, à partir de l'URL initiale, Scheduler sera remis Downloader à télécharger, après avoir téléchargé l'araignée sera remis à l'analyse, les résultats de l'analyse sur Spider, il y a deux: l'un est la nécessité de poursuivre rampent liens, tels que des liens « Suivant » avant l'analyse, ces choses seront transférées à l'ordonnanceur, l'autre est la nécessité de sauvegarder les données, ils ont été envoyés à l'article pipeline, où il est (une analyse détaillée du post-traitement des données , filtration, stockage, etc.) lieu. En outre, dans le flux de données dans un canal, vous pouvez également installer une variété de middleware, un traitement nécessaire.

Dictionnaire blocs départements 2.2

-

Moteur (Scrapy moteur): Il est utilisé pour traiter le traitement de flux de données de l'ensemble du système, ce qui déclenche l'opération.

-

Le planificateur (Scheduler): Pour les demandes de réception envoyées sur le moteur, est enfoncé dans la file d'attente, et retourne à nouveau le moteur lorsque la demande.

-

Downloader (Downloader): Pour le téléchargement de contenu web, le contenu web et retour à l'araignée.

-

Spiders (Araignées): Spider est une uvre majeure, et l'utiliser pour élaborer des règles à des domaines spécifiques de résoudre ou une page web. classe de réponse écrite utilisée pour analyser et extraire l'élément (c.-à-point acquis) ou une URL de suivi supplémentaires. Chaque araignée est responsable de la gestion d'un site Web particulier (ou certaines).

-

Projet de pipeline (Pipeline article): Responsable des araignées tirées du projet Web, sa tâche principale est claire, valider et stocker des données. Lorsqu'une page est analysée araignée, le projet sera envoyé à la canalisation, et après quelques ordre spécifique de traitement des données.

-

Télécharger middleware (intergiciels Downloader) : Le cadre est situé entre le crochet et le téléchargeur moteur Scrapy, principalement le traitement des demandes et des réponses entre le moteur et le téléchargeur Scrapy.

-

araignée Middleware (intergiciels araignée): Crochets interposé entre le châssis et le moteur d'araignées Scrapy, un travail important est une réponse de sortie de processus à la demande d'entrée et d'araignées.

-

Middleware Planification (Planificateur intergiciels): Scrapy entre le moteur et l'ordonnancement de middleware, transmise depuis le moteur aux demandes de planification Scrapy et des réponses.

Analyse 2.3 flux de données scrapy

Les étapes suivantes:

ÉTAPE 1: Moteur ouvre un site web (ouvrir un domaine), le processus trouver araignée site à l'URL de demande d'araignée (s) premier à ramper.

ÉTAPE 2: Spider acquis du moteur à la première URL et d'être explorées planificateur de demande dans le planificateur (Scheduler).

ÉTAPE 3: Moteur URL requête suivante prise pour monter au programmateur.

ÉTAPE 4: Le planificateur renvoie une URL à être analysé au moteur, qui transmet l'URL au téléchargement (Downloader) en téléchargeant (direction demande (requête)) intermédiaire.

ÉTAPE 5: Une fois que la page est téléchargée, la réponse de téléchargement génère une page et télécharger le (sens retour (réponse)) middleware au moteur.

ÉTAPE 6: Reçue du moteur à la téléchargeur araignée réponse et envoie le processus intermédiaire par Spider (direction d'entrée).

ÉTAPE 7: traitement Point Araignée Réponse et retour à l'exploration et (suivi) une nouvelle demande au moteur.

ÉTAPE 8: Le moteur (araignée retour) à ramper à l'article de l'article Pipeline, la (Spider) retourner la demande au planificateur.

ÉTAPE 9: (A partir de la deuxième étape) est répétée jusqu'à ce qu'il n'y a pas de demande plus ordonnanceur, le moteur est arrêté sur le site.

Citation: « En savoir Scrapy Mise en route »

Auteur: JasonDing

Lien: http: //www.jianshu.com/p/a8aad3bf4dc4

III. Comprise

Alors que beaucoup de scrapy site de vulgarisation scientifique déposée, ce sera un reptile, dit cadre de scrapy. Le rôle du cadre est de faire de package travail répétitif.

Par exemple, si un ensemble de traitement des données en utilisant le système Linux nécessite quatre étapes, chaque étape de la nécessité de réécrire la ligne de commande et aura un nouveau répertoire, le milieu va prendre le temps d'attente, de sorte que cet ensemble de traitement de données prend beaucoup de temps et vous pouvez oublier la correspondance stockée dans le répertoire de fichiers, le plus pratique est que, lorsque le groupe traité même que d'autres personnes ont besoin d'autres données, ils doivent répéter votre travail, de sorte qu'il génère beaucoup de déchets inutiles de temps .

Ensuite, quelqu'un a pensé à fichier de commande d'écriture sh exécutée directement, éliminant ainsi la nécessité d'attendre entre quatre étapes, temps d'exécution n'a pas changé, mais le processus décentralisé dans le processus global, ce qui améliore à la fois efficacité, mais aussi aux personnes ÉVITEZ stationnées devant l'ordinateur pendant une longue période continue de commande lose.

Là encore, quelqu'un dans le fichier sh sur la base de la pensée précédente, ne peut pas écrire un cadre, les différences de différentes sources de données utilisateur, telles que le chemin d'entrée se vident, de sorte que ce cadre peut être utilisé par tous le même traitement similaire les gens utilisent les données, mais aussi pour éviter beaucoup de duplication de temps pour écrire le fichier sh.

Sur la base de ces idées, se pose lentement cadre.

cadre , Populaire, est de processus similaire de Les mêmes caractéristiques Extrait.

IV. Combat

4.1 La première consiste à installer scrapy

pip installer scrapy

Si vous désinstallez six 1.4.1 apparaît

Sera remplacé par la commande:

sudo pip install Scrapy --upgrade --ignore installé six

pip est en fait un outil de gestion des paquets python, et la plupart du temps lorsque vous téléchargez installer manuellement python, fonctionne pip sous Unix / Linux, OS X et les plates-formes Windows, vous pouvez module (module) pip Télécharger python dans le besoin et empaqueter.

-

Scrapy confirmer si l'installation a réussi

Version scrapy

L'affichage doit être une telle installation réussie:

-

Sur la question de common mac est « fonction d'initialisation du module dynamique n'est pas défini. »

ImportError: Module dynamique ne définit pas la fonction d'initialisation (init_openssl)

solution:

Ce problème semble la raison la plus probable est que python est 32bit, et l'ordinateur appartient à 64bit.

Comment vérifier la version python de celui-ci, et les ordinateurs médians OS faire?

uname -a

Vous pouvez obtenir des informations système d'exploitation informatique

plate-forme d'importation

platform.architecture ()

Vous pouvez connaître la version actuelle de la situation python, par exemple:

recommander ici un blog "Installation les stands Scrapy sur OSX" (

4.2 projet de construction et télécharger la configuration PyCharm et PyCharm

Dans l'exemple choisi ici, « ramper cresson neuf points de livres, » le classique, la liste livre de cresson lien: https: //www.douban.com/doulist/1264675/

4.2.1 établir projet

Tout d'abord, entrez la commande dans le terminal:

Le livre de scrapy

Établie avec succès, alors il y aura:

Nouveau projet Scrapy « livre », en utilisant le répertoire de modèle « /Library/Frameworks/Python.framework/Versions/2.7/lib/python2.7/site-packages/scrapy/templates/project », créé en:

/ Utilisateurs / wuxinyao / Desktop / livre

Vous pouvez commencer votre première araignée avec:

livre cd

scrapy genspider exemple example.com

À ce stade, vous revenez affermis dans le répertoire peut être vu pour générer un livre appelé un répertoire, construire la ligne principale de reptiles fichier python dans le répertoire avec la commande, des exemples nommés Douban. instruction:

scrapy genspider Douban https://www.douban.com/doulist/1264675/

Au-dessus de ce qui est l'URL de reptiles contre URL

après succès sera affiché le code suivant:

araignée créé « Douban » en utilisant dans le module « de base » modèle:

book.spiders.douban

4.2.2 l'étape suivante avec PyCharm

PyCharm le téléchargement URL: http: //www.jetbrains.com/pycharm/download/#section=mac

-

Mettre en place le fichier principal

Main.py doit être établie dans le répertoire du livre qui est généré automatiquement et assurer scrapy.cfg main.py dans la même couche.

Dans le type main.py:

de cmdline import scrapy

cmdline.execute ( "scrapy crawl Douban" .split ())

-

Modifier douban.py

Araignées trouvé dans le répertoire douban.py, commentait #allowed_domains = , et de mettre dans les fonctions suivantes:

def parse (self, réponse):

Imprimer response.body

-

ajouter < tête >

Dans setting.py Lane a ajouté:

USER_AGENT = 'Mozilla / 5.0 (Windows NT 6.3; WOW64; rv: 45,0) Gecko / 20100101 Firefox / 45.0'

4.2.3 FAQ: Télécharger le package ne peut pas être importé scrapy

référence non résolue « scrapy »

Et en raison de problèmes d'autorisation PyCharm ne peut pas télécharger scrapy directement sur l'IDE. Il sera répété erreur. L'émergence de ce problème sont la solution suivante:

-

essayez à nouveau télécharger scrapy sur l'IDE

fichier - > paramètres par défaut - > projet interprète

Sélectionnez une version interprète, plus le coin inférieur gauche, recherchez scrapy dans la nouvelle interface pop-up, cliquez sur l'installation, vous pouvez télécharger.

projet interprète interprète moyens, ordinateur Mac est livré avec un python, mais peut être diverses raisons beaucoup de gens vont choisir de télécharger de nouveaux python (tel que le système d'exploitation de 32 bits aimeraient changer 64), et stocké dans un autre chemin. Et Mac est livré avec python lors de l'introduction d'un nouveau package, il est facile de problèmes d'autorisations, afin que les utilisateurs de Mac ont souvent coexistent interpréteur python pluralité.

Dans cette interface, vous pouvez sélectionner un interprète que vous souhaitez utiliser:

Cela ne résout pas nécessairement le problème, il y a beaucoup de raisons pour un téléchargement a échoué, comme l'autorisation à la raison ou la version d'un paquet n'est pas nécessaire de télécharger de nouveaux scrapy. Elle correspond à l'opération dans un terminal: pip install commande scrapy.

Même si le téléchargement est réussi, pas en mesure d'exécuter avec succès. Mais ceci est une solution relativement simple, vous pouvez essayer.

-

Re-edit chemin

run - > Modifier la configuration

script écrit à l'intérieur chemin absolu main.py, l'interpréteur python sélectionnez dans la version que vous souhaitez utiliser l'interpréteur.

Si vous Scrapy pouvez exécuter dans le terminal, vous pouvez utiliser qui Scrapy pour trouver ce que scrapy position, puis choisissez un chemin similaire à la version python. Ou regardez le chemin absolu avec lequel python python travaillent, sélectionnez la version de l'interprète.

La sortie de l'exécution réussie:

Les premières lignes comme celle-ci, ce qui est équivalent ripped le site source. En fait, la source du navigateur site de vérification de code, montre les mêmes résultats.

titre 4.3 extrait et le nom auteur

Tout d'abord était de voir le code source du site:

trouvé dans < div class = "bd doulist-sujet" > Voici l'introduction aux livres que nous voulons

formulation auteur de référence extrait dans l'ordre suivant:

-

Extraction du cadre: < div class = "bd doulist-sujet" >

-

Extraction Titre: 'div / a / texte ()'

-

L'extraction de: ' < div class = "abstrait" > (. *?) < br '

-

Extraction Score: 'div / span / text ()'

Auteur voidsky_ enfants très intéressants (via le cresson) fournit ce morceau de code:

Sélecteur = scrapy.Selector (réponse)

livres = selector.xpath ( '// div ')

pour chacun dans les livres:

title = each.xpath extrait () ( 'div / a / texte ()').

taux = each.xpath ( 'div / span / text ()'). extract ()

auteur = re.search ( ' < div > (. *?) < br », each.extract (), re.S) .group (1)

imprimer 'Titre:' title +

imprimer « Note: » + taux

print auteur

imprimer « »

Citation: « Scrapy installer et démarrer très vite - ramper cresson 9 liste des points. »

Auteur: voidsky_ enfants très intéressants

Lien: http: //www.jianshu.com/p/fa614bea98eb

Ce code utilise XPath, XPath est une information de conclusion dans un langage de document XML, mais il peut aussi être utilisé en HTML. Obtenez la plupart du contenu de l'étiquette ne ont pas besoin d'écrire des expressions régulières complexes, peuvent être utilisés directement XPath. Le tableau suivant la commune d'expression:

Ce code est ajouté avant le douban.py la fonction parse (auto, réponse) ci-dessous, avant le « print response.body » a commenté, ce couplé directement.

4.4 scrapy analyse des flux

En fait, je vous écris, a été formé une applet complète, et la sortie résultante doit être:

Il est probable que le premier programme de laissez-passer ne peut pas obtenir un résultat d'une telle, l'émergence d'une variété d'erreurs, mais il peut voir une certaine structure pour faciliter la compréhension des choses Scrapy quand le débogage de:

2017-07-20 xx: 50: 53 INFO: extensions: Activé

......

20/07/201720:50:53 INFO: Activé téléchargeur intergiciels

......

20/07/201720:50:53 INFO: Activé araignée intergiciels:

......

20/07/201720:50:53 INFO: pipelines Enabled:

......

20/07/201720:50:53 INFO: Spider ouvert

......

20/07/201720:50:54 INFO: Spider fermé (fini)

......

Problèmes possibles:

Si vous ne recevez pas la sortie ci-dessus, puis a couru regarder de plus près le code, et s'il y a celui-ci:

UnicodeDecodeError: 'ascii' codec ne peut pas décoder octet 0xE6 en position 0: ordinal dans la plage (128)

Description du défaut python str est ascii de codage, le codage et les conflits unicode, de sorte que l'erreur sera signalé ce titre

Il suffit d'ajouter à main.py dans:

import sys

reload (sys)

sys.setdefaultencoding ( 'utf8')

Vous serez en mesure de résoudre le problème.

4,5 heures Difficulté Approfondir

Au-dessus que les petits projets plus près, l'objet et Pipline ne sont pas impliqués, juste ramper les données et aucune opération de stockage, les caractéristiques structurelles scrapy ne sont pas pleinement pris en compte, ce sera un autre classique avec un petit projet sur la structure et la fonction des scrapy une élaboration plus poussée.

4.5.1 La première étape pour les sous-répertoires générée explication:

Entrez la commande:

scrapy startproject myproject

ls myproject

-

scrapy.cfg: Profils de projets

-

/: Projet de module Python, après le code ajouté ici

-

monprojet / items.py: articles du projet Fichiers

-

myproject / pipelines.py: Pipeline Project Files

-

myproject / settings.py: Profils de projets

-

monprojet / araignées: l'araignée répertoire de dépôt

4.5.2 Le produit est comme un python dans le dictionnaire

D'après le contenu ci-dessus peuvent savoir, l'article est un conteneur pour le chargement de données, nous devons point modelée pour obtenir du site pour récupérer les données.

scrapy dans les commentaires de l'article ont été notés dans le libellé de la finale écrite dans le fichier python propre (comme un exemple de douban.py), le stockage peut saisir des données.

Dans le fichier python maison (dans ce cas appelé project.py), vous devez importer la fonction de l'élément

de MyprojectItem d'importation project.py

4.5.3 réglage des paramètres de sortie variable dans l'alimentation animale

Si elle veut Excel sous forme de tableau sous forme d'imprimer, puis, ont besoin d'être mis en settig.py dans les données d'élément capturé est stocké, ajoutez les deux lignes suivantes:

FEED_FORMAT: indique le format de sortie, csv / xml / JSON /

FEED_URI: une position indiquant la sortie, peut être local, ou peut être un serveur FTP

Par exemple:

FEED_URI = u'file: /// G: //dou.csv '

FEED_FORMAT = 'CSV'

Dans ce cas, le fichier de sortie existe des disques G, appelé dou.csv, est un fichier csv.

V. projet pour établir un scrapy de rétroaction

5.1 Comment trouver le bug plus rapide

Pour un novice, apprendre à écrire avec scrapy robots d'exploration, est plus difficile à configurer PyCharm et l'adaptation des expressions régulières, si ce projet est divisé en plusieurs blocs logiques, alors, il est de comparer la compréhension proposée du flux d'informations scrapy et flux de données, même si le programme a manqué du bug (en particulier grande probabilité) peut effacer rapidement quels fichiers à l'intérieur des problèmes. scrapy est pas très approprié pour le débogage bug de la console, il n'a pas directement affiché une erreur clé, il est préférable que le cerveau peut distinguer entre les blocs fonctionnels mentionnés ci-dessus, correspondant à trouver bug.

5.2 interprète peut conduire à la coexistence d'une variété d'erreur

L'objectif principal de cet article est d'introduire l'utilisation de scrapy ce cadre, mais se concentre également sur la réalisation d'un robot pourrait faire face à divers problèmes, y compris une variété d'erreurs qui peuvent se produire lorsque plusieurs ordinateurs dans l'interpréteur python, l'auteur conclut : Si le paquet a été donné le temps à importer pour modifier sa course / configuration dans l'interpréteur python, si vous avez une erreur dans la console, ne peut pas se connecter à la console, le projet de réaménagement, sélectionnez les bibliothèques externes sous le répertoire usr / bin.

VI. Connaissances supplémentaires

6.1 cours de Spider et méthodes

-

nom: le nom d'araignée doit être unique et de type chaîne, saisissez-le lorsque vous exécutez l'araignée

-

allow_domains: méthode permettent de domaine, peut être une chaîne ou d'une liste, en option, non obligatoire.

-

start_urls: Indique url la première visite

-

start_requests (): Get URL par défaut de start_urls à l'intérieur, et génère une demande à une URL par rappel par défaut pour analyser. La planification est réalisée à partir d'ici. Ici, il peut être réécrite afin de commencer à accéder à l'URL spécifiée, généralement utilisé lors de la simulation de l'atterrissage, obtenir le code dynamique. Ensuite, vous pouvez obtenir le code dynamique comme celui-ci:

de demande d'importation de scrapy.http, FromRequest

start_requests ():

retour # veulent obtenir cookies ajouté méta

Voici l'URL de votre code URL de connexion d'atterrissage, lorsque vous accédez à cette URL, le serveur vous renvoie une réponse, cette réponse lors de l'atterrissage à l'étape suivante qui devra être envoyé. Ensuite, la connexion de la fonction de rappel ici à cette méthode est que la réponse retournée de l'intérieur pour obtenir le code via une expression régulière ou une combinaison de XPath et ainsi de suite.

start_requests Downloader téléchargera le dos de réponse au rappel, c'est ma définition de la méthode de connexion, le processus de connexion, en plus d'analyser et obtenir un code dynamique, mais peut aussi être simulé l'atterrissage lors de la connexion peut être ajouté:

def connecter (self, réponse):

code = response.xpath ( '// h1 / text ()'). extract () # est d'obtenir un code, peuvent être extraits combinés re

headers = {} # atterrissage tête du navigateur analogique

Postdata = {} données #server à votre poste, y compris le code obtenus ci-dessus

retour

# Notez que postdata n'a pas utilisé le urlencode, et les cookies en utilisant une réponse renvoyée par le cookie, ce qui est au-dessus start_requests où l'enregistrement cookie. De plus à ce moment est l'adresse URL des données vraiment poste, peuvent généralement être obtenus par Firebug. En fait, ici vous ne pouvez obtenir ce cookie de temps, de sorte que vous pouvez obtenir après cookie atterrissage. Cette méthode est appelée après son atterrissage avec succès, puis une autre page est maintenant accessible après l'atterrissage en suivant cette méthode make_requests_from_url méthode loged.

# Ici si vous avez besoin d'entrer un code de vérification, et peut être utilisé pour télécharger des images manuellement entrées, vous pouvez voir un autre morceau de journal.

Si cette méthode est surchargée, start_urls puis à l'intérieur de l'URL ne sera pas accessible d'abord, quand vous souhaitez accéder aura spéciale « souligné. » Il sera décrit plus loin.

Notez également que, start_requests est automatiquement invoqué qu'une seule fois.

make_requests_from_url (url):

Cette méthode est lorsque vous spécifiez l'url de temps, grâce à cette méthode, il peut revenir automatiquement à analyser. méthode scrapy peut appeler automatiquement parse, il suffit de regarder mon étude, seulement deux (start_requests et make_requests_from_url). Ceci est important, car pour combiner ledit CrawlSpider derrière la règle.

URL peut être obtenue par start_urls d'accès à l'intérieur make_requests_from_url ():

def loged (self, réponse):

pour url dans start_urls:

rendement make_requests_from_url (url)

analyser ():

scrapy locale la réponse par défaut est transmise à l'parse (), ce qui suggère qu'il est utilisé pour extraire le contenu Web local, l'extraction de contenu web peut être réalisé ici en classe d'araignée, mais CralwSpider dans le parse () mettre en uvre la règle obtenue par le lien traitement ultérieur, il est recommandé de ne pas CrawlSpider réécrire la méthode parse.

règle ():

Downloader règle donne des indications sur la façon d'obtenir la fonction de lien, la mise en uvre spécifique est:

de LINKEXTRACTOR d'importation de scrapy.linkextractors comme LKE

Quote: ChrisPop

Lien: http: //www.jianshu.com/p/a1018729d695

conclusion: Choisissez d'utiliser une nouvelle méthode pour démarrer au début est toujours difficile de s'adapter à un nouveau bug logiciel est plein, aussi longtemps survécu au début de la scène, et plus tard deviendra ouvert en douceur. Scrapy souhaitent également que vous pouvez faire de plus en plus intéressant et amusant reptile petit programme!

Wu Yan Yao Les données envoyées membres du groupe de reptiles, en Chine Université agricole agronomie école professionnelle, et l'ordinateur principal biologique, cross-champ statistique, venant aux études sur le terrain des États-Unis effectués.