Tongling non Temple du fond de l'évidement

Qubit produit | Numéro public QbitAI

Imitez les plus brillants tweets de célébrités termes, vous pouvez maintenant le faire à chaque minute.

chercheur du MIT, professeur de cours d'apprentissage en profondeur Lex Fridman a fait une nouvelle demande:

DeepTweets , Une personne peut pousser le contenu classique Laid contenu mimique, génère automatiquement un nouveau pseudo Twitter.

Publié 10 heures, plus de 500 points dans l'étude des utilisateurs louange Lex Fridman, les utilisateurs @ArthDubey représente, dans une certaine mesure, vos requêtes de recherche et tweeté il est facile de déduire votre tendance à former la base de grandes quantités de données les prévisions.

Les résultats montrent

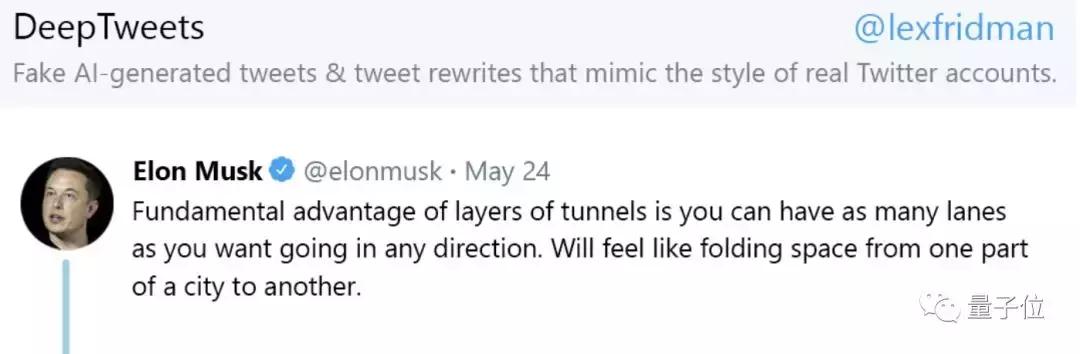

Jetez un oeil à DeepTweets faux tweets génèrent effectivement des résultats.

Prenez la plante vivace active dans le Twitter « réseau rouge » à l'exemple Musk, après Musk avait envoyé un tweet d'un tunnel à plusieurs niveaux:

Les forces fondamentales du tunnel multi-couche est que vous pouvez choisir la voie dans les deux sens, tout l'espace plié de la même partie de la ville est reliée à l'autre partie.

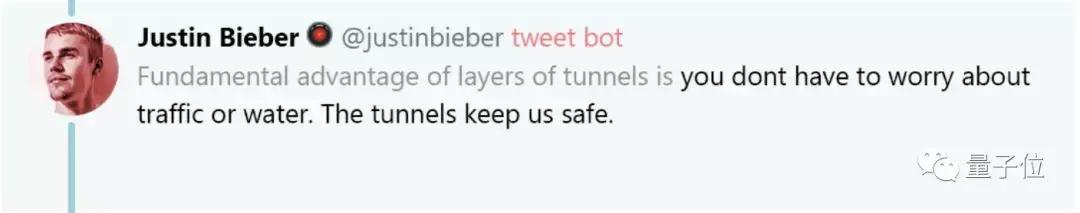

OK, maintenant que DeepTweets jouer, et il imite le ton du chanteur Justin Bieber, a fait un faux twitter réponse:

Les forces fondamentales du tunnel multi-couche est que vous n'avez pas à vous soucier de la circulation ou l'eau de surface, de sorte que nous sommes la sécurité des tunnels très multi-couches.

Ouais bien, peu importe la langue ou la cohérence logique du contenu de ce faux tweets un peu de façon transparente.

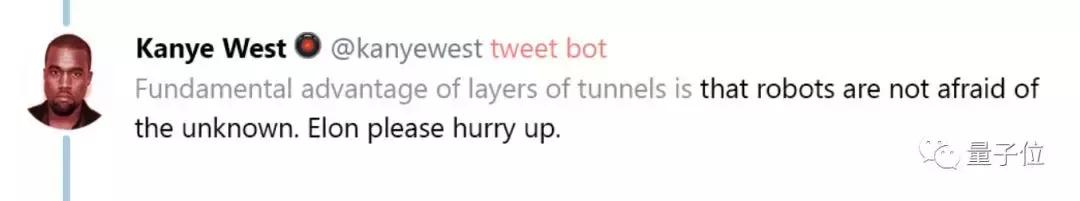

Un regard de rappeur américain Kanye West:

Les avantages du tunnel à couches multiples est que le robot ne craint pas les facteurs inconnus, ah accélération Elon.

Oui, celui-ci même interagir avec le propriétaire à dépenser.

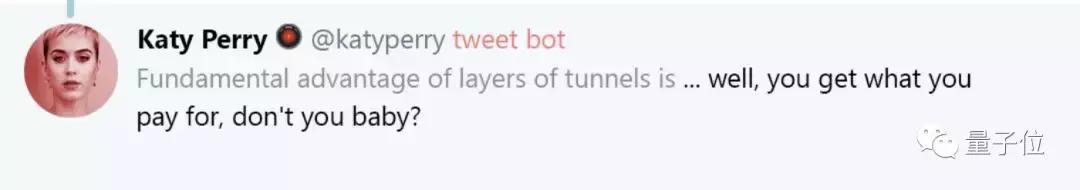

Continuer à regarder en bas, la chanteuse américaine Kate Perry a également rejoint dans le plaisir:

Les avantages du tunnel multi-couche qui ...... vous payez, le bébé ne pensez-vous pas?

DeepTweets vraiment maitrisées habitude de parole de chaque personne ah ......

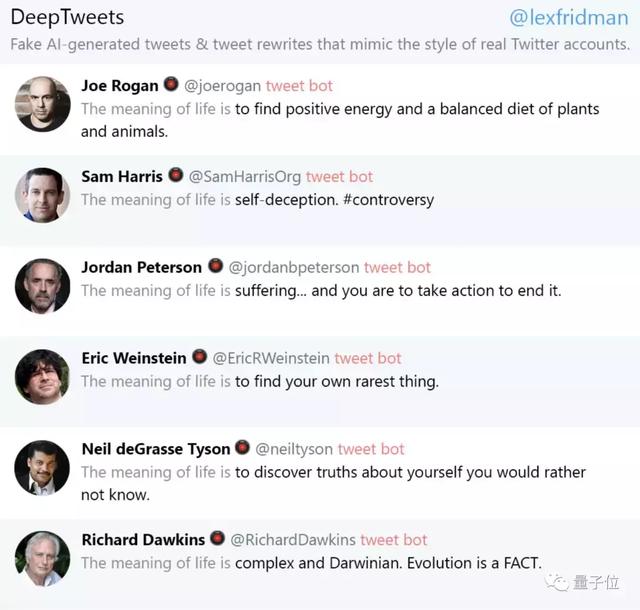

Il existe de nombreux exemples, comme pour en faire le « sens de la vie » au début, imiter les tweets de célébrités:

Frère Lex Fridman a dit qu'il avait formé twitter réponse modèle de nombreuses célébrités, comme Trump, Obama, Musc (Lex Fridman souvent interagir avec lui), talk-show Conan O'Brien, Alan de Jeni Naples, ces modèles sera publié.

TPG-2 et méritoires

Auteurs exprimé petit frère, DeepTweets sont formés dans la langue du modèle open source a GPT-2. GPT-2 dans la tâche de modélisation du langage, simplement comme gardes existence.

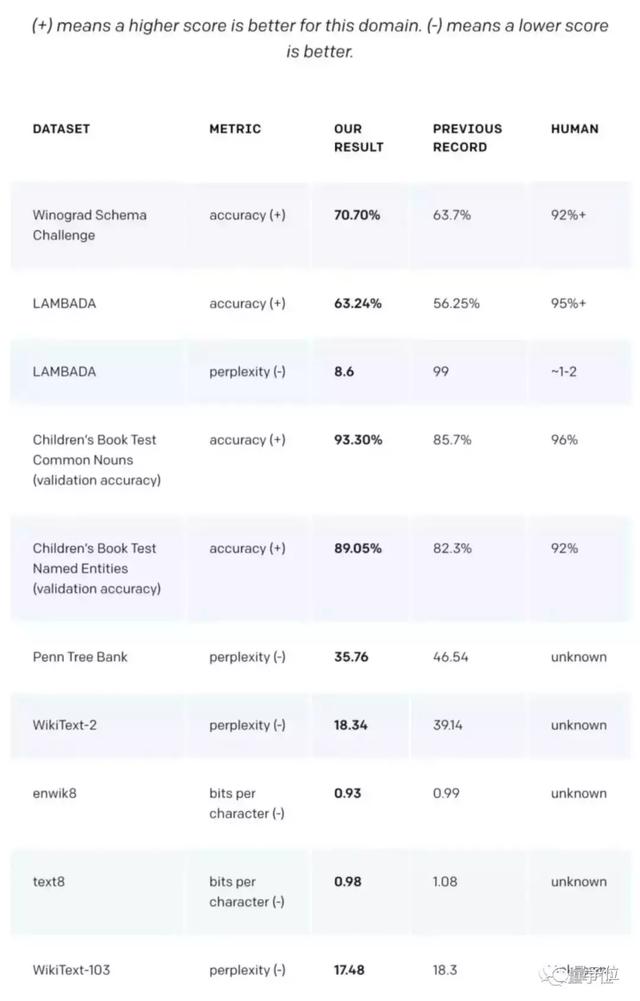

En tant que modèle sans aucune formation spécialisée dans le domaine des données, ses performances encore mieux que les modèles faits pour les zones spécifiques, a balayé les principales tâches de modélisation linguistique.

les résultats des tests GPT-2 sur les différentes tâches de modélisation linguistique (de gauche à droite: le nom du jeu de données, le type d'index, les résultats des tests GPT-2, ont les meilleurs résultats, le niveau humain)

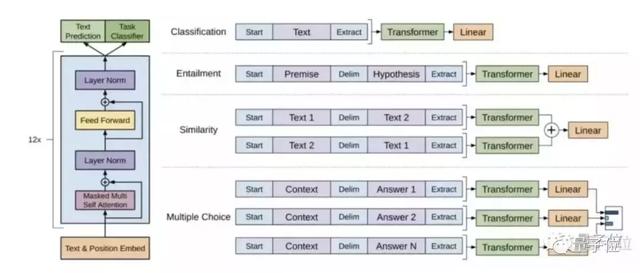

En termes simples, GPT-2 est un modèle à grande échelle l'architecture Transformer.

TPG algorithme GPT-2 est « une évolution », développez paramètre TPG de 10 fois, pour atteindre 1,5 milliard, soit 10 fois la quantité de données pour étendre l'utilisation de l'ensemble de données contenant 8 millions de pages, soit un total de 40 Go.

Cet énorme algorithme de modélisation du langage des utilisations en tant que signal de formation à la formation non supervisée un moyen de transformateur sur de grands ensembles de données, puis d'affiner le modèle de supervision sur un ensemble plus restreint de données pour l'aider à résoudre une tâche spécifique.

La figure de gauche section, il est la cible de l'architecture et de la formation Transformer utilisée dans l'étude. La partie droite est peaufinage pour des tâches spécifiques de. Tout jeton est converti en une séquence d'entrée structuré, le pré-formé de modèle de traitement, puis linéarisé + softmax traitement de la couche.

Sur le TPG-2, pour son objectif de formation est simple: selon tout le texte devant un mot donné, pour prédire le mot suivant.

Un début, OpenAI seulement un petit modèle de formation pré-version et les amis ridiculiser 117 M comme « ClosedAI ». OpenAI exprimé, n'est pas open source, mais pas le temps.

Le mois dernier, OpenAI a annoncé son modèle de pré-formation 345M des paramètres de source, plus 1.5B ouvert de son transformateur.

portail

Enfin, attacher les matériaux d'apprentissage connexes GPT-2.

GitHub Adresse de code:

https://github.com/openai/gpt-2

TPG-2 adresse ensemble de données:

https://github.com/openai/gpt-2-output-dataset

OpenAI introduit Page d'accueil:

https://openai.com/blog/better-language-models/#update

Lex Fridman expliquer la vidéo GPT-2 (nécessite aller scientifique):

https://youtu.be/O5xeyoRL95U

- FIN -

recrutement sincère

Qubits recrutent éditeur / journaliste, basé à Zhongguancun de Beijing. Nous attendons de talent, des étudiants enthousiastes de nous rejoindre! Détails, s'il vous plaît interface de dialogue qubit numéro public (QbitAI), réponse mot "recrutement".

Qubit QbitAI · manchettes sur la signature de

' « suivre les nouvelles technologies AI dynamiques et de produits