Ces dernières années, avec le développement rapide de la profondeur de l'apprentissage et un large éventail d'applications potentielles, de plus en plus d'attention par la technologie de lecture labiale basée sur la vision informatique, il a de nombreuses applications, telles que la reconnaissance vocale auxiliaire, l'authentification biométrique dans la pratique, l'aide malentendants et ainsi de suite.

Mais la difficulté est très élevée tâche la lecture labiale, est de savoir comment obtenir efficacement un point clé des informations de mouvement des lèvres, ainsi que la résistance à identifier les difficultés causées par le geste, la lumière change, l'apparence du haut-parleur perturbations, changement de vitesse de la parole, etc. De plus, comment l'image des lèvres comporte le texte et le vocabulaire de distinguer avec précision entre homophones ou association est aussi un défi.

De l'Université du Zhejiang, l'Académie chinoise des sciences chercheurs traitement de l'information intelligente et clé de laboratoire de l'Institut de technologie de l'informatique de ces problèmes, les caractéristiques locales et globales de la couche d'information de séquence de couches dans la retenue mutuelle, afin d'améliorer les caractéristiques visuelles et le contenu de la lèvre vocale relation.

En testant sur certains des principaux ensembles de données, l'équipe méthode proposée devrait en même temps a une bonne capacité d'identifier et de robustesse, afin d'obtenir la lecture labiale efficace.

Carte | Niveau de lecture labiale mot est une tâche difficile. (A), le mot de sous-titres de trame réelle « environ » comprend seulement un cadre à l'étape de temps T = 12 ~ 19. (B) la même étiquette de mot change toujours avec l'apparition en constante évolution. (Source: arXiv)

branche de la lecture labiale de l'art il y a un niveau technique important vocabulaire de lecture à savoir la lèvre pour cette tâche, la nécessité d'une vidéo d'entrée avec un commentaire pour chaque étiquette de mot unique, bien qu'il y ait d'autres mots dans la même vidéo, comme indiqué ci-dessus: (a) échantillons vidéo comprenant un total de 29, a été annotées comme « environ », mais le mot « environ » trame comprenant seulement le temps de l'étape réelle T = 12 ~ 19 du cadre, cela correspond de trame à des intervalles avant et après le mot « juste » et " TEN «plutôt que » sur ». Sur la base de l'étude de la lèvre visuelle, nous avons toujours difficile de tirer des limites exactes d'un mot.

Cette fonction nécessite un bon modèle pour apprendre à lire sur les lèvres caractéristiques potentielles mais cohérentes dans la même étiquette de mot réfléchi autre vidéo, permettant de se concentrer plus efficacement des images clés, et moins d'attention à un autre cadre sans rapport.

En plus des mots de défi aux limites imprécises, les échantillons vidéo correspondant au même mot d'étiquette est toujours une grande variété et le changement d'apparence, tels que (b), toutes ces caractéristiques sont nécessaires pour résister au modèle de séquence de lecture labiale bruit, capturant ainsi le mode dans les mêmes conditions de parole potentiels différents.

En même temps, en raison de la surface effective limitée de l'action des lèvres, des mots différents Speak peut présenter un phénomène similaire. la présence d'homonymie, différents mots peuvent sembler identiques ou très similaires, a augmenté le nombre de difficultés supplémentaires, ces attributs peuvent être trouvés dans la différence exigences du modèle à grain fine associés au niveau de la trame des mots différents pour distinguer chaque mot en particulier.

Pour résoudre ce problème, les chercheurs ont introduit la maximisation de l'information mutuelle (MIM) à différents niveaux pour aider à la robustesse du modèle d'apprentissage et de représentation distingué, afin d'obtenir une lecture labiale efficace.

Dans un aspect, en appliquant des contraintes locales afin de maximiser l'information mutuelle (LMIM) dans lequel à chaque pas de temps pour contraindre généré, une forte corrélation entre celle-ci et le contenu vocal, augmentant ainsi le mouvement du modèle de lèvres ont trouvé la possibilité de bien, nuances entre les mots sonnant similaires, tels que « dépenses » et « passer », d'autre part, l'introduction de la séquence d'information mutuelle des contraintes de maximisation (GMIM) au niveau mondial, de sorte que le modèle peut être plus pertinent de faire la distinction entre le contenu de la parole images clés et toutes sortes de bruit se produisant au cours de parler moins.

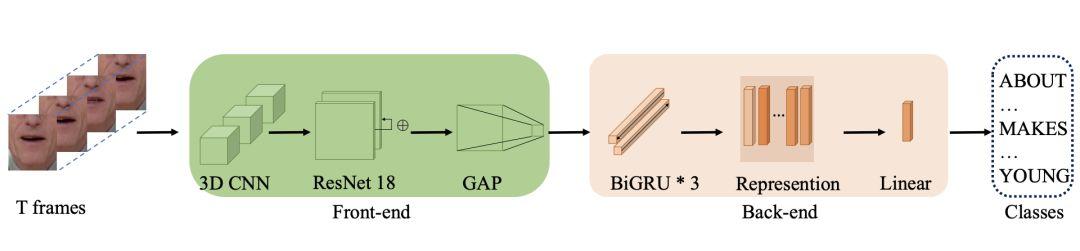

Carte | architecture de base (Source: arXiv)

En outre, GMIM forçant le modèle à apprendre différents échantillons de modèle global potentiel compatible avec une étiquette de mot, tout robuste aux changements de posture, l'éclairage, et d'autres conditions non liées; LMIM peut améliorer chaque grains fins pas de temps mots de sport du renforcer davantage les différences entre les différents mots. En combinant ces deux types de contraintes, le modèle peut automatiquement découvrir et cadre efficace important de distinguer entre le mot cible, tout en ignorant autre cadre sans rapport, afin d'améliorer encore la précision de la reconnaissance.

Carte | identifier les améliorations aux mots similaires sondage (source: arXiv)

Enfin, l'équipe en deux données mot-niveau à grande échelle définit LRW et la lecture labiale méthodes de modèle de reconnaissance traditionnels lèvre LRW-1000 homologues ont fait une évaluation comparative de l'échantillon proposé les deux ensembles de données sont d'une variété de collection d'émissions de télévision et les conditions de présentations varient considérablement, couvrant un large éventail de conditions d'éclairage, y compris la condition de parler, la résolution, la position, le sexe, etc., maquillage.

LRW publié en 2016, y compris l'échantillon à lèvres 500 mots, plus de 1000 le nombre de haut-parleurs d'instances, la formation devrait atteindre 488766, le nombre d'instances de chaque ensemble de vérification et de test pour 25000; LRW-1000 jeu de données est mot-niveau des ensembles de données de référence d'une grande distribution naturelle, un total de 1000 mots chinois, un total d'environ 718018 échantillons d'exemple, la durée d'environ 57 heures, mais l'ensemble de données est destiné à couvrir les modèles de la parole naturelle changement dans des conditions différentes d'imagerie et d'inclure des applications pratiques difficultés rencontrées.

Carte | par rapport au champ précédent des plus de résultats modèle test avancé (Source: arXiv)

Le jeu de données LRW, après l'introduction LMIM, en fonction de la précision au niveau de référence a augmenté d'environ 1,19%, LMIM devrait capturer plus à grains fins et des traits distinctifs de la tâche principale, tout en introduisant GMIM mis pour améliorer la précision de 84,41%, principalement grâce à son accent différent sur différents cadres.

Cependant, dans les données LRW-1000 définies en raison de sa voix plus grande aux conditions changeantes, y compris les conditions d'éclairage, la résolution, l'âge du haut-parleur, la position, le sexe, le maquillage, l'industrie avait les meilleurs résultats des tests de seulement 38,19%. Obtenir de bons résultats de reconnaissance sur cet ensemble de données reste un défi, de nouveaux modèles ont acquis une précision de reconnaissance 38,79% de, légèrement mieux que les derniers résultats disponibles.

Les résultats montrent que la méthode proposée dans cette équipe sans l'utilisation de données supplémentaires ou d'un modèle de pré-formation complémentaire, par rapport aux deux autres ensembles de données difficiles modèle de reconnaissance des lèvres, montrant un nouveau statut de performance en temps réel de . En outre, l'équipe a dit, la méthode peut également être facilement modifié comme modèle pour d'autres tâches, en fournissant des informations intéressantes pour l'étude d'autres tâches.