Les deux dernières années, le modèle d'attention (modèle Attention) est largement utilisé dans le traitement du langage naturel, reconnaissance d'image, reconnaissance vocale, et divers autres types de tâches d'apprentissage en profondeur, la profondeur de la technologie d'apprentissage est la technologie de base des plus intéressants et en profondeur la compréhension des a.

Dans cet article, la traduction automatique, par exemple, les visiteurs d'en apprendre davantage dans l'étude approfondie des mécanismes attentionnels et principes clés du système informatique, mais aussi sa nature abstraite de la pensée, l'attention et présente les scénarios d'application typiques du modèle dans des domaines tels que l'image et la voix.

Ces dernières années modèle d'attention est largement utilisé dans divers apprentissage de la profondeur de champs, que ce soit une variété de différents types de traitement d'image de tâche, la reconnaissance vocale ou le traitement du langage naturel, sont vulnérables à la figure modèle de l'attention. Par conséquent, l'attention pour comprendre le fonctionnement du mécanisme est très préoccupé par la nécessité de compétences en développement de la technologie de l'apprentissage en profondeur.

L'attention visuelle humaine

De la désignation du modèle d'attention, il est clair que le mécanisme attire l'attention de l'homme, et par conséquent, nous avons d'abord brièvement introduire le mécanisme de l'attention sélective de la vision humaine.

1 L'attention visuelle humaine

mécanisme de l'attention visuelle est unique au mécanisme de traitement du signal du cerveau visuel humain. En balayant l'image globale rapide visuel humain, pour obtenir la zone cible besoin de se concentrer sur, que l'on appelle généralement l'attention, et consacrer davantage de ressources à se concentrer sur ce domaine pour plus de détails sur la nécessité de se concentrer sur la cible, et inhiber d'autres informations inutiles.

Ceci est un moyen de ressources humaines avec une attention limitée filtrer rapidement des informations à partir d'un grand nombre d'informations de grande valeur, est un mécanisme de survie sous la forme humaine de l'évolution à long terme, le mécanisme de l'attention visuelle humaine améliore considérablement l'efficacité du traitement de l'information visuelle et précision.

La figure 1 montre une visualisation du système visuel humain cible est plus préoccupé quand ils voient une image de la façon dont l'allocation efficace des ressources limitées de l'attention, ce qui montre que la zone rouge, il est clair que pour le scénario illustré à la figure 1, les gens vont prêter attention à forcer plus dans le visage de la personne, le texte du titre de l'article et la première phrase et d'autres endroits.

étude approfondie du mécanisme de l'attention de l'essence et le mécanisme de l'attention visuelle sélective l'objectif fondamental de l'homme comme, est de sélectionner une information plus critique sur les objectifs de la mission en cours d'un certain nombre d'informations.

cadre COdeurDECodeur

Pour comprendre la profondeur de l'apprentissage modèle d'attention, vous devez commencer avec le cadre du codeur-décodeur, comme la plus grande attention est attachée au modèle dans le cadre du codeur-décodeur, bien sûr, en fait, le modèle d'attention peut être considérée comme une idée générale, lui-même ne dépend pas d'un cadre spécifique qui a besoin d'attention.

modèle de recherche-cadre COdeurDECodeur peut être considéré comme un des domaines d'apprentissage en profondeur, les scénarios d'application exceptionnellement large. La figure 2 est un champ de traitement de texte classique cadre COdeurDECodeur représente l'un des plus abstrait.

Figure 2 Cadre COdeurDECodeur champ de traitement abstrait texte

champ de traitement de texte cadre codeur décodeur pour comprendre intuitivement peut être si: ce qui peut être considéré comme approprié pour le traitement d'une phrase (ou chapitres) génère en outre une phrase (ou chapitres) du modèle de traitement général. Pour la phrase < Source, cible > Notre objectif est de phrase d'entrée donnée Source, attendant pour générer la phrase cible par cible cadre COdeurDECodeur. Source et cible peut être la même langue, il peut être deux langues différentes. Source et cible, respectivement, et la séquence de mots respective est composé de:

Codeur nom Source suggère est de coder la phrase d'entrée, l'entrée de phrase par la conversion non-linéaire à une représentation sémantique de l'intermédiaire C:

Décodeur pour le décodeur, sa mission et informations sur l'historique C est généré en fonction de la source phrase sémantique précédemment intermédiaire

Pour générer un moment pour générer mot i

:

Chaque yi sont séquentiellement générés de manière, il semble, est l'objectif de l'ensemble du système généré en fonction de la phrase d'entrée phrase cible Source. Si la source est une phrase chinoise, la cible est une phrase en anglais, alors il est de résoudre le problème de la traduction automatique cadre codeur-décodeur, si la source est un article, Target est une description générale de quelques déclarations, alors ceci est un résumé de texte du codeur-décodeur cadre; si la source est une question, la cible est une réponse, alors c'est un cadre Q & COdeurDECodeur du système de dialogue ou un robot. Ainsi, dans le domaine du traitement de texte, COdeurDECodeur d'une large gamme d'applications.

Cadre COdeurDECodeur largement utilisé non seulement dans le domaine du texte, il est souvent utilisé dans la reconnaissance vocale, le traitement d'image et d'autres domaines. Par exemple, la reconnaissance vocale, le cadre de la figure 2 est pleinement applicable, est tout simplement la différence entre le flux de la parole d'entrée est la section du codeur, correspondant aux informations de texte est sortie, alors que pour la tâche « description de l'image », la section d'entrée est un codeur vice-image, sortie décodeur est en mesure de décrire l'image d'un des descripteurs de contenu sémantique. En général, la reconnaissance vocale et de traitement de texte sont généralement utilisés modèle Encoder RNN, l'image de traitement du codeur CNN modèle couramment utilisé.

Modèle de l'attention

Cette première section à la traduction automatique comme un exemple pour expliquer les principes de base de la plus commune doux modèle de l'attention, après cadre dépassé COdeurDECodeur abstraire l'essence de l'idée des mécanismes attentionnels, et introduit l'idée de base récemment largement utilisé auto attention de.

Modèle Soft Attention

Montré dans le cadre figure COdeurDECodeur 2 est reflète pas le « modèle d'attention », il peut donc être considéré comme un modèle de distraction de l'inattention. Pourquoi nous nous concentrons pas? S'il vous plaît observer la cible phrase cible chaque mot est généré comme suit:

Où f est une fonction de transformation non linéaire du décodeur. Comme on peut le voir de cela, lors de la génération du mot cible dans la phrase, quelle que soit la génération mot, qui utilise le code phrase d'entrée sémantique source C est la même, aucune différence.

Le codage sémantique C par chaque mot de la phrase après générateur du codeur de code source, ce qui signifie que peu importe quel mot est généré,

ou

En fait, un mot dans une source de phrase pour générer un mot cible yi d'influence sont les mêmes, ce qui est de dire pourquoi ce modèle ne reflète pas la raison de l'attention. Ceci est similaire à un être humain regardant l'écran, mais les yeux ne sont pas les mêmes que le centre d'attention.

Si vous prenez la traduction automatique pour expliquer le modèle de distraction cadre du codeur-décodeur pour mieux comprendre, par exemple, entra dans la phrase anglaise: Tom chase Jerry, cadre COdeurDECodeur générer progressivement mot chinois: « Tom », « chasse », « Jerry ".

Dans la traduction de « Jerry » Le mot chinois quand les distractions modèle à l'intérieur de chaque mot anglais pour cible de traduction mot « Jerry » contribution est la même, il est clair que ce n'est pas raisonnable, il est clair « Jerry » Pour traduire par « Jie suisse « plus important encore, il est un modèle de distraction ne peut pas tenir compte de ce qui est la raison pour laquelle il n'y a aucune raison pour l'introduction de l'attention.

Modèle aucune attention au moment de l'introduction de la courte phrase d'entrée d'un gros problème, mais si vous entrez dans une longue phrase, cette fois pour représenter tout le entièrement sémantique par un vecteur sémantique intermédiaire, le mot lui-même a des informations disparu, on peut imaginer se perdre beaucoup de détails, ce qui est une raison importante pour laquelle l'introduction du modèle d'attention.

Dans l'exemple ci-dessus, si l'introduction du modèle de l'attention, il devrait être traduit par « Jerry » quand le mot anglais pour la traduction reflète le degré actuel d'influence de différents mots chinois, comme pour donner une distribution de probabilité similaire aux valeurs suivantes:

(Tom, 0,3) (Chase, 0,2) (Jerry, 0,5)

La probabilité de chaque mot anglais au nom de l'attention lorsque la taille du mot courant traduit « Jerry » modèle d'allocation d'attention attribuée à un des mots anglais différents. Ceci est la traduction de la langue cible correcte du mot est certainement utile, parce que l'introduction de nouvelles informations.

De même, l'objectif de chaque mot dans la phrase devrait apprendre à se concentrer informations sur la distribution de probabilité des déclarations de source correspondant dans le sous-mot. Cela signifie que chaque mot est généré

Lorsque l'original est la même représentation sémantique intermédiaire C est remplacé par le mot basé sur la génération actuelle et changeant

. L'attention est la clé pour comprendre ce modèle, à savoir, un intermédiaire représenté par une sémantique fixe mot C remplacé est ajustée en fonction de la sortie de courant est changé pour le modèle d'attention ajoutée

. COdeurDECodeur augmenté modèle d'attention pour comprendre le cadre comme indiqué sur la figure.

La figure 3 est introduit cadre COdeurDECodeur Modèle de l'attention

Tel est le processus de génération du mot cible phrase est devenue la forme suivante:

et chaque

Peut correspondre à une déclaration sous-mot autre source d'allocation d'attention des distributions de probabilités, comme pour la traduction ci-chinois, les informations correspondantes peuvent être comme suit:

Ce qui, la fonction f2 représente l'encodeur pour entrer un mot d'une fonction de transformation, comme le modèle RNN si l'encodeur est utilisé, alors le résultat est souvent une fonction f2 une entrée point

Etat valeur de nud caché; G représente une fonction de conversion intermédiaire synthétique représentative codeur phrase entière représentation sémantique des mots intermédiaires, dans la pratique générale, g est une fonction d'une somme pondérée des éléments constitutifs, à savoir, la formule suivante:

Parmi eux,

durée de la peine Source est représentative de l'entrée,

allocation d'attention Source phrase d'entrée de coefficient lorsque le mot dans le j-ième sortie du i-ème mot représentatif de la cible, et

phrase d'entrée source est dans le codage sémantique j-mot. hypothèse

I est un indice exemple mentionné ci-dessus « Tom », puis

Est 3, h1 = f ( "Tom"), h2 = f ( "Chase"), h3 = f ( "Jerry") sont la phrase d'entrée de codage sémantique de chaque mot, les poids correspondant du modèle d'attention sont 0.6,0.2,0.2, de sorte que essentiellement la fonction g est une fonction de la somme pondérée. Si l'image représente, puis traduit mot chinois « Tom » quand la formule mathématique intermédiaire correspondant représentation sémantique

La figure 4 est similaire au processus de formation.

4 Procédé de formation d'attention de la Fig.

Il y a aussi un problème: pour générer la phrase cible un mot, comme « Tom », nous savons comment attribuer une distribution de probabilité de la valeur de la phrase d'entrée des modèles d'attention exigent mot attention qu'il? Ce « Tom » probabilité d'entrée correspondant à chaque mot dans une phrase distribution Source: (Tom, 0,6) (Chase, 0,2) (Jerry, 0,2) est de savoir comment l'obtenir?

Pour plus de commodité d'explication, nous supposons un décodeur utilise également non-cadre Attention COdeurDECodeur Modèle raffinement. La figure 2, RNN en utilisant l'encodeur modèle, le modèle RNN, ce modèle est la configuration de forme plus commune, le cadre 2 est converti Fig. Figure 5.

La figure 5 RNN comme un cadre spécifique COdeurDECodeur Modèle

La figure 6 peut alors plus facilement illustrer le processus d'un usage général calculer la distribution de probabilité de valeurs de la distribution de l'attention.

La figure 6 est calculée distribution de probabilité de l'attention

Pour décodeur utilisant le RNN, en i temps, si vous voulez générer des mots yi, nous pouvons connaître la génération cible

I-1 avant le moment où la valeur de sortie du noeud caché i-1 fois

Et notre objectif est de générer l'informatique

Lors de la saisie des mots dans une phrase « Tom », « Chase », « Jerry » sur

Il est attribué une distribution de probabilité, la phrase peut être émis au moment i-1 statut de noeud de couche cachée cible

Hj par rapport à onze état de noeud de la couche cachée et RNN phrase d'entrée source correspondant à chaque mot, à savoir par la fonction F (

,

) Pour obtenir le mot cible

Et aligner la possibilité de chaque mot d'entrée correspondant à la fonction F peut prendre différentes approches dans différents papiers et sorties alors la fonction F Softmax normalisée obtenir l'attention de la distribution de probabilité de la distribution de probabilité conformément à la valeur de l'intervalle distribution des valeurs.

Attention, grande majorité des modèles prennent le cadre de calcul ci-dessus pour calculer la distribution de probabilité d'informations d'allocation d'attention, mais la différence peut différer de la définition de Fs. La figure 7 montre visuellement en anglais - après avoir ajouté le mécanisme de l'attention du système de traduction allemande, l'allocation d'attention probabilité source et cible deux phrases chaque mot de distribution correspondant.

7 Anglais - Distribution attention de la traduction allemande de probabilité

Au-dessus est l'idée de base du modèle classique Attention souple, alors comment comprendre la signification physique du modèle de l'attention de celui-ci? Dans les applications de traitement du langage naturel général où la production est considérée comme un modèle serait Attention phrase cible dans un modèle d'alignement de mots et de phrase entrée Source chaque mot, ce qui est très raisonnable.

Chaque mot de la phrase cible générée distribution de probabilité de la phrase de mots d'entrée correspondant peut être comprise comme une phrase d'entrée et l'alignement de mots la probabilité de génération de cible de la parole, qui, dans le contexte de la traduction automatique est très intuitif: traduction automatique statistique traditionnelle est généralement effectuée processus étape aura une phrase spéciale aligné, et l'attention du fait que le modèle est le même effet.

Figure 8 Google machine à réseau de neurones diagramme d'architecture du système de traduction

La figure 8 est le déploiement de Google en 2016 au système de traduction automatique basé sur des lignes de réseaux de neurones, par rapport au modèle traditionnel a augmenté pour effet considérablement la traduction, un taux d'erreur de traduction est diminué de 60%, sa structure décrite ci-dessus est représenté sur la figure ainsi que codeur-décodeur cadre de mécanisme de l'attention, la principale différence est simplement que 8 codeur et décodeur stratifiées à l'aide du modèle ajouté LSTM.

L'idée essentielle de l'attention de mécanisme

Si l'exemple mécanisme Attention de libération du codeur-décodeur du cadre, et encore une abstraction, peut être plus facile de comprendre l'essence de la pensée de ce qui précède sur le mécanisme de l'attention.

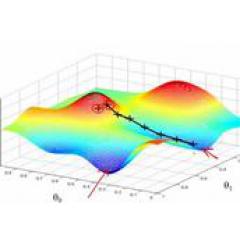

L'idée essentielle du mécanisme de la figure 9 Attention

Nous pouvons faire pour traiter le mécanisme de l'attention (voir la figure 9). Les éléments constitutifs de la Source comme une suite de < Clé, valeur > Les données de configuration, puis donnés un élément dans la requête cible, la requête, et en calculant la similitude ou la corrélation entre la clé respective, les poids principaux correspondant à chacun du coefficient de pondération obtenu la valeur et la valeur de la somme pondérée, à savoir, pour obtenir un attention, la valeur finale. Par conséquent, le mécanisme est essentiellement Attention Source La valeur est une somme pondérée des éléments, et la clé de requête utilisée pour calculer le coefficient de pondération correspondant à la valeur. Telle est l'essence de la pensée peut être réécrite comme la formule suivante:

Parmi eux,

|| = || Source Source de longueur représentant, à savoir le sens de la formule décrite ci-dessus. Des exemples de la traduction automatique citée ci-dessus, parce que dans le processus de calcul Attention, la source et la valeur de clé combinés, pointez sur la même chose, à savoir la phrase d'entrée sémantique de codage correspondant à chaque mot, il ne peut pas être facile de voir que cette idée peut incarner l'essence même de la structure.

Bien sûr, Conceptuellement, l'attention a compris encore être de grandes quantités d'informations dans une petite quantité de filtrer de manière sélective des informations importantes et de se concentrer sur ces informations importantes, en ignorant la plupart des informations sans importance, cette idée tient toujours. mise au point de procédés inclus dans le calcul du coefficient de poids est élevé, plus le poids de la valeur de mise au point de valeur correspondant à celle-ci, à savoir, les poids représentant l'importance de l'information et l'information correspondante de la valeur.

De la figure 9 peut être compris qu'un autre chef de file, l'attention peut également être considéré comme un mécanisme souple d'adressage (Adressage): Source peut être considéré comme le contenu stocké dans les éléments de mémoire par la valeur d'adresse et de la composition de valeur clé, il y a actuellement une clé = requête objet de requête correspondant à une mémoire est de prendre la valeur de la valeur, à savoir la valeur de l'attention. Par des éléments clé de requête et l'adresse de la mémoire à l'adresse comparaison de similitude, la raison pour laquelle un Adressage, à la différence se réfère uniquement à trouver un contenu de la mémoire adressables par le contenu de l'intérieur, mais de chacune des adresses possibles clés l'importance du contenu sont sorties, prises pour déterminer la similitude de la requête et la clé, puis somme pondérée de la valeur, qui peut être la valeur retirée valeur finale, à savoir la valeur de l'attention. Beaucoup de chercheurs Attention considéré comme un cas particulier de mécanisme d'adressage doux, ce qui est très raisonnable.

En ce qui concerne les détails du mécanisme de l'attention de calcul, si la majorité de la méthode abstraite en cours, alors, peut se résumer en deux processus: un premier processus selon Query Key et des coefficients de pondération sont calculées, le second procédé selon les coefficients de pondération Valeur somme pondérée. Le premier procédé peut être subdivisé en deux étapes: la première étape ou à la fois de calculer une similarité selon la corrélation et la clé de requête, la seconde étape de la première phase des scores bruts ont été normalisés; ainsi, le processus de calcul peut être résumé comme Attention 10 montrent trois étapes.

La figure 10 calcule processus en trois étapes Attention

Dans la première étape, une autre fonction peut être introduit et un système d'ordinateur, et en fonction d'une requête

, La similitude ou la pertinence, à la fois la méthode la plus commune de calcul comprend: la recherche d'un produit scalaire de vecteurs entre les deux, à la fois la recherche de vecteur de similarité de cosinus ou en introduisant réévalué supplémentaire par le réseau neuronal, à savoir de la manière suivante:

La première valeur de phase générée par des procédés spécifiques qui produisent plage de valeurs numériques différentes ne sont pas les mêmes, la mise en place de la deuxième étape est calculé d'une manière similaire à la partition SoftMax première étape de conversion numérique, d'une part peut être normalisée, la le score initial est calculé organisé en poids lourds de tous les éléments et pour la distribution de probabilité, d'autre part, peut aussi être important élément plus important du mécanisme interne SoftMax en poids. -À-dire généralement calculé selon la formule suivante:

Les résultats de la deuxième étape

à savoir

Des coefficients de pondération correspondant, et en additionnant les valeurs pondérées pour obtenir Attention:

En calculant les trois étapes décrites ci-dessus, pour obtenir des valeurs pour Attention requête, la méthode de calcul spécifique de la grande majorité des mécanismes d'attention répondre au-dessus de processus de calcul en trois étapes d'abstraction.

Modèle auto Attention

Attention, l'essence du genre au-dessus de la pensée, nous pouvons comprendre plus facilement le modèle auto Attention décrit dans cette section. Auto attention est également souvent appelé intra attention (attention interne), année la plus récente a également reçu relativement largement utilisé, comme dans le dernier modèle de traduction automatique de Google utilise beaucoup de modèle auto Attention.

Codeur-décodeur dans le cadre des tâches générales, saisissez le contenu de sortie source et cible ne sont pas les mêmes, par exemple pour l'anglais - langue dans la traduction automatique, phrase anglaise Source, Target est la traduction phrase chinoise correspondante, les mécanismes d'attention se produisent dans requête cible entre les éléments et tous les éléments Source. Auto Attention, son nom l'indique, fait référence au mécanisme de l'attention entre la source et la cible n'est pas, mais le mécanisme de l'attention se produit entre les éléments internes cible ou la source entre les éléments internes, peut être comprise comme cible = attention dans ce cas particulier Source le système informatique. Le processus de calcul spécifique est le même, mais la cible calculée change seulement, il ne se répète pas ici les détails de calcul.

Si elle ne correspond pas à l'attention conventionnelle Source cible dans le cas de calcul, la signification physique comme ci-dessus contraintes, telles que pour la traduction automatique, il est essentiellement un mécanisme d'alignement de mots entre le mot de la langue source et la langue cible un mot. Donc, s'il est mécanisme d'auto Attention, une question naturelle est: par auto Attention à la fin appris ce que la loi ou extrait quelles sont les caractéristiques il? Ou l'introduction du gain auto Attention ou à quoi bon? Nous sommes encore dans la traduction automatique auto attention à expliquer, 11 et 12 sont une représentation visuelle de contact entre soi Attention même mot dans une phrase en anglais produit.

Figure 11 Exemple de visualisation auto Attention

Visualisation auto Attention Exemple 12

Comme on peut le voir sur les deux graphiques (figure. 11, fig. 12), auto Attention syntaxiques peuvent être capturées entre le même mot dans une phrase (comme le montre la figure. 11 a une distance de la structure de phrase) ou traits sémantiques (tels que 12 sur la figure. montrer de ses référents droit).

De toute évidence, il serait plus facile de capture comporte l'introduction phrase interdépendant longue distance auto Attention, car si RNN ou LSTM, besoin de calculer, pour l'interdépendance à distance de fonction, de passer par un certain nombre de pas de temps dans l'ordre, la séquence des étapes les informations accumulées pour relier les deux, et plus la distance, la capture moins probable efficace.

Cependant auto Attention dirigera les deux mots de la phrase dans le processus de calcul par un lien directement lié étape de calcul, la distance en fonction de la distance entre les caractéristiques est grandement raccourci, propice à une utilisation efficace de ces caractéristiques. De plus en plus, l'attention auto pour augmenter le parallélisme a un calcul direct utile. C'est la principale raison pour laquelle de plus en plus l'attention auto largement utilisé.

Attention, d'application Mécanisme

Ce qui précède sont décrits, le mécanisme d'Attention étude approfondie des diverses applications ont un large éventail de scénarios d'utilisation. Dans le processus ci-dessus décrit, nous avons principalement des tâches de traitement du langage naturel dans la traduction automatique d'exemple, les éléments suivants sont des exemples d'application typiques puis sélectionnez à partir du traitement de l'image et le champ de reconnaissance vocale qui lui est appliqué pour être brièvement décrit.

13 images - Description du cadre COdeurDECodeur de la tâche

Description de la photo (image-Caption) est la profondeur d'une application d'apprentissage typique de combinaison graphique, une image d'entrée, une sortie de la phrase système d'intelligence artificielle décrite, la description sémantique montré dans l'image équivalente. Il est évident que ce scénario peut également utiliser le cadre COdeurDECodeur aux objectifs de la mission d'adresse, puis la section d'entrée du codeur est une image, l'image typiquement fonctionnalité extraction avec CNN, décodeur ou partiellement utilisé RNN LSTM à la sortie phrase en langage naturel (voir fig. 13).

L'attention a été ajouté à ce moment si le mécanisme peut améliorer de manière significative les résultats de la sortie du système, où l'attention du modèle joue un mécanisme similaire d'attention sélective visuelle humaine, une entité dans le mot de sortie sera le centre d'attention concentrée sur une région respective dans l'image. La figure 14 montre la phrase « Une personne est debout sur une plage avec une planche de surf. » Lorsque la procédure correspondant à chaque mot dans l'image de mise au point d'attention selon une région de génération d'image donnée.

l'attention figure la zone de mise au point 14 lorsque l'image de chaque mot dans la génération de phrase

La figure 15 montre un autre exemple de quatre illustre bien ce processus, chacun des exemples ci-dessus est laissé phrase d'entrée d'origine est décrit ci-instruction générée automatiquement AI, montre la figure en haut à droite du système lorsque l'AI généré lorsque l'instruction a souligné mot, la position correspondante dans la zone de l'image mise au point. Par exemple, lorsque la sortie du chien de mot, le système AI se concentrera plus d'images affectées à une position correspondant au chien.

Description de la tâche 15 dans l'image figure mécanisme une action de focalisation Attention

Attention entre la. Reconnaissance vocale figure 16 et la séquence de caractères de sortie audio

tâche de reconnaissance vocale objectif est de convertir les signaux vocaux en flux de texte, il est également des scénarios d'application typique COdeurDECodeur. section d'entrée Source encodeur est un signal de flux de la parole, section décodeur sorties du flux de parole correspondant à la chaîne de caractères.

La figure 16 montre visuellement après l'addition du mécanisme d'Attention trame codeur-décodeur, lorsque l'utilisateur en utilisant ladite phrase de parole combien serait un mandrin de marmotte, l'allocation d'attention entre le signal de son et la caractéristique de sortie de la partie d'entrée de caractères d'une distribution de probabilité, plus la plus la couleur attribuée à l'attention du représentant de la probabilité. Comme on le voit sur la figure, dans ce scénario, le mécanisme d'Attention joue le rôle d'entrée de signal de parole et de sortie alignés caractéristiques.

Ce qui précède sélectionné seulement quelques exemples d'application typiques mécanismes d'attention dans les différents domaines de l'intelligence artificielle, codeur-décodeur, plus l'architecture de l'attention en raison de leurs excellents résultats pratiques obtenus dans le domaine d'études actuel en profondeur une large plage d'utilisation, la compréhension et l'utilisation qualifiée ce cadre pour il y aura une grande aide pour résoudre des problèmes pratiques.