Ces dernières années, de plus en plus en profondeur l'étude approfondie de l'étude dans divers domaines ont également reçu beaucoup de percée. Sur la base de mécanisme attention de réseau de neurones (l'attention) est devenue une recherche chaude récemment réseau de neurones, j'ai appris récemment un mécanisme d'attention sur la base des documents de réseau de neurones dans le domaine Traitement du langage naturel (PNL), viennent maintenant à l'attention en PNL un résumé des applications, et de partager avec tout le monde.

Progress 1 Attention

mécanisme de l'attention a d'abord été mis en avant dans le domaine des images visuelles, il devrait être neuf ans pour mettre en avant l'idée, mais vraiment le feu jusqu'à l'esprit de Google devrait être pris en compte dans cette équipe de papier « Les modèles récurrents de l'attention visuelle » , ils modèle RNN en utilisant le mécanisme d'attention à la classification d'image. Par la suite, Bahdanau et al dans le document « Neural Traduction automatique par apprentissage conjointement à aligner et traduire » , un mécanisme similaire à l'attention de la traduction simultanée dans la traduction automatique et alignée sur la mission, leur travail est considéré comme le premier à proposer mécanisme d'attention appliquée au domaine de la PNL. RNN a suivi un modèle similaire basé sur le mécanisme d'attention a commencé à utiliser étendent une variété de tâches PNL. Récemment, les mécanismes d'attention à la façon d'utiliser CNN est devenue un sujet brûlant tout le monde. La figure ci-dessous montre l'évolution de la recherche sur les progrès de l'attention.

2 modèles récurrents de Visual Attention

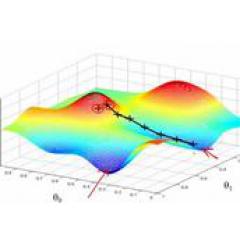

Avant l'introduction de la PNL Attention, je voudrais dire quelque chose généralement utilisé dans les idées d'attention d'image. Il est représentatif du papier « Modèles récurrents de l'attention visuelle » , la motivation de leur recherche est en fait inspirée par les mécanismes de l'attention humaine. Les gens qui effectuent image d'observation quand, en fait, pas une fois pris la position de chaque pixel de l'image entière sont vus, la plupart du temps en fonction des besoins de mise au point à une partie spécifique de l'image. Et l'avenir de l'humanité apprendra à observer l'attention de l'image doit être centrée sur la position de l'image observée avant. La figure est un diagramme schématique du modèle de base de ce document.

Le modèle est l'inclusion de mécanismes d'attention (hors de la partie du cercle rouge) sur un RNN classique, par une attention à la partie de l'apprentissage d'une image à traiter, l'état actuel de chaque apprendra à attirer l'attention selon l'état précédent l, et la position actuelle de l'image d'entrée, l'attention à traiter une partie des pixels, mais pas tous les pixels de l'image. L'avantage est que moins de pixels à traiter, réduire la complexité de la tâche. L'image peut être vu dans l'application de l'attention humaine et le mécanisme de mise au point est très similaire, nous allons jeter un oeil à l'attention en usage dans la PNL.

3 sur la base de l'attention RNN en PNL

3.1 Neural Traduction automatique par apprentissage conjointement à aligner et Traduire

Le document considéré comme une uvre de mécanismes d'attention à l'utilisation en PNL. Ils attention mécanisme utilise la traduction automatique de réseau de neurones (NMT) sur, NMT est en fait une séquence typique de modèle de séquence, qui est un codeur modèle de décodeur, l'utilisation traditionnelle de NMT deux RNN, une langue de codage de source RNN, codant pour la langue source à une dimension fixe du vecteur intermédiaire, puis décodée traductions dans la langue cible, selon le modèle d'usage traditionnel dans une figure RNN:

Ce document présente un mécanisme fondé sur l'attention de NMT, modèle à peu près comme indiqué ci-dessous:

Je ne figure pas tous les décodeurs en jeu de tirage de connexion, dessiner seulement les deux premiers mots, en fait, derrière les mots sont les mêmes. Vous pouvez voir l'expression (classique seulement après le dernier mot a appris l'expression) l'attention de NMT dans la base traditionnelle, il est la fin de chaque mot dans l'apprentissage en langue source et de prédire le lien de traduction mot courant, donc le contact se fait par leur attention de conception, après un bon modèle de formation, basée sur l'attention de la matrice, nous pouvons obtenir la source de la matrice d'alignement et les langues cibles du. section design d'une attention particulière sont les suivants:

Vous pouvez voir qu'ils utilisent une formule Perceptron à chaque mot de la langue source et le lien langue cible, et puis en fonction douce pour obtenir une matrice de distribution de probabilité normalisée est l'attention.

Par rapport aux résultats NMT classique à partir des résultats (RNNsearch est l'attention NMT, RNNenc de NMT traditionnel) beaucoup amélioré, la plus grande caractéristique est qu'il peut être visualisé alignés et ont un avantage dans le traitement des longues peines.

3.2 approches efficaces pour la traduction Neural machine à base de l'attention

Ce document est le deuxième sur un papier, un très représentatif des papiers, ils travaillent à dire à tous comment l'attention peut être étendue dans RNN, l'application ultérieure d'une variété de modèle basé sur l'attention en PNL papier un rôle important dans la promotion. Dans le papier, ils proposent deux mécanismes d'attention, on est mécanisme mondial (global), un mécanisme est partiel (local).

Nous examinons d'abord l'attention mécanisme mondial, en fait, cette idée d'attention et le document présenté est le même, il est le traitement du langage source tous les mots, sauf que le calcul de l'attention dans une matrice de valeurs, il proposé plusieurs versions d'extension simple.

Dans leur dernière expérience pour calculer l'effet de la méthode générale est le meilleur.

Penchons-nous sur leur version locale proposée. L'idée principale est de réduire le coût lorsque le calcul de l'attention quand l'attention calcul pas à tous les mots du côté de la langue source, mais selon une des fonctions de prédiction, la position de prédiction Pt pour aligner le côté langage courant source de décodeur, le contexte fenêtre, considérer que le mot dans la fenêtre.

Ce qui donne deux méthodes de prédiction, m locale et la p locale, l'attention au cours de la dernière recalcul de la matrice, dans la base d'origine par une position jusqu'à pt pertinente distribution gaussienne. Les résultats sont meilleurs que l'auteur de l'effet global de l'attention locale.

La plus grande contribution de cet article est d'abord me dire comment vous pensez que nous pouvons étendre l'attention des calculs, il y a la méthode d'attention locale.

4 sur la base de l'attention CNN en PNL

L'attention est alors basé sur le modèle RNN est largement utilisé au début de la PNL, le modèle est non seulement une séquence à la séquence, toutes sortes de problèmes peuvent être classés en utilisant de tels modèles. Ainsi, dans une étude approfondie et RNN même réseau de neurones de convolution populaire CNN que l'attention peut également utiliser le mécanisme? « ABCNN: Attention, basée sur Convolutif Neural Network pour la modélisation des paires de phrases » Ce document propose une méthode utilisée dans la troisième attention CNN, est l'attention dans les travaux d'exploration dans CNN plus tôt.

CNN dans la construction de vue du modèle de la phrase classique de ce qui précède, la manipulation par un seul canal par la phrase, la phrase, puis étudier l'expression, et enfin l'entrée au classificateur ensemble. Une telle classification d'entrée de modèle avant la phrase est sans contact entre eux, les auteurs ont voulu concevoir une attention par autre phrase mécanismes canal cnn sur le lien.

La première méthode est l'attention ABCNN0-1 avant convolution, calculer la phrase correspondante de la carte de fonction de l'attention par la matrice de l'attention, et ensuite en même temps que la fonction de convolution couche de carte ensemble d'entrée d'origine. Une méthode de calcul spécifique est le suivant.

La deuxième méthode est ABCNN-2 Attention lorsque mis en commun, une nouvelle pondération d'expression de l'attention par convolution, puis à la mise en commun, suivant le principe de la Fig.

Le troisième doit être utilisé conjointement avec CNN dans les deux premières méthodes, comme indiqué ci-dessous

Cet article fournit une attention que nous utilisation dans la directive CNN. Maintenant, il y a beaucoup d'utilisation d'une attention basée sur le travail de CNN, et ont obtenu de bons résultats.

5 résumé

Enfin, pour résumer. Attention, en PNL en fait, je pense que peut être considéré comme une pondération automatique, il peut mettre à lier deux modules différents, pondérés par formulaire de contact. La formule actuelle du courant principal sont les suivantes:

En concevant une fonction du module module source et cible ms mt liée, puis par une fonction douce pour obtenir la distribution de probabilité normalisée.

L'attention est actuellement en PNL a été largement utilisé. Il a un gros avantage est que la matrice peut être visualisé l'attention de vous dire quelles parties concernent le réseau de neurones au cours de la tâche.

Mais les mécanismes d'attention et les mécanismes d'attention humaine en PNL est encore différent, il est nécessaire de calculer la base ou tous les objets à traiter, et le stockage supplémentaire avec une matrice à son poids, en fait, de plus en plus les frais généraux. Plutôt que comme un être humain ne peut ignorer ne veulent pas se concentrer sur les parties à traiter seulement une partie de la préoccupation.

références

Bahdanau, D., Cho, K. & Bengio, Y. Neural Traduction automatique par apprentissage conjointement à aligner et à traduire. IPSC 20151-15 (2014).

Luong, M. & Manning, C. D. approches efficaces pour la traduction Neural machine à base de l'attention. 1412-1421 (2015).

Rush, A. M. & Weston, J. Un Neural modèle de l'attention pour abstractives phrase Summarization. EMNLP (2015).

Allamanis, M., Peng, H. & Sutton, C. Convolutif Network Attention Extreme Summarization du code source. Arxiv (2016).

Hermann, K. M. et al. Machines d'enseignement à lire et à comprendre. ArXiv 1-13 (2015).

Yin, W., Ebert, S. & Schütze, H. Attention basée sur Convolutif Neural Network pour machine Comprehension. 7 (2016).

Kadlec, R., Schmid, M., Bajgar, O. & Kleindienst, J. Compréhension de texte avec l'attention Somme réseau lecteur arXiv :. 1603.01547v1 (2016).

Dhingra, B., Liu, H., Cohen, W. W. & Salakhutdinov, R. Les lecteurs Gated-Attention pour texte Comprehension. (2016).

Vinyals, O. et al. Grammaire comme une langue étrangère. ArXiv 1-10 (2015).

Wang, L., Cao, Z., De Melo, G. & Liu, Z. Classification par Acl 1298-1307 (2016) Relation Attention à plusieurs niveaux CNNs..

Zhou, P. et al. Rencontre. Assoc. Comput. Linguist. (Volume 2 Court Pap. 207-212 (2016) Attention à base d'Bidirectionnel longue mémoire à court terme pour les réseaux Relation classification. Proc. 54e Annu..

Yang, Z. et al. NAACL (2016) Réseaux Attention hiérarchique pour la classification des documents..

Yin W, H Schütze, Xiang B, et al Abcnn :. convolutionnel basé Attention-réseau de neurones pour la modélisation de paires de phrases arXiv preprint arXiv :. 1512,05193, 2015.

mnih V, N Heess, Graves A. modèles récurrents de l'attention visuelle // Les progrès réalisés dans Neural Information Processing Systems 2014 :. 2204-2212.