Lei Feng.com [AI Technology Review] Press : Cet article est édité et compilé sur la base du rapport "Frontiers of Reinforcement Learning" réalisé par le Dr Yu Yang lors de l'AIDL Second AI Frontier Workshop de la Chinese Artificial Intelligence Society "Frontiers of Machine Apprentissage ". Leifeng.com n'a pas changé. Sur la base de l'intention initiale, certaines suppressions ont été effectuées, et cela a été corrigé et confirmé par le Dr Yu Yang, et je voudrais exprimer mes remerciements. Le texte intégral est divisé en parties supérieure et inférieure, et cet article est la partie suivante.

Le dernier portail : "Dr. Yu Yang de l'Université de Nanjing : Frontiers of Reinforcement Learning (Part 1)"

Le Dr Yang Yu est professeur agrégé et ses principaux domaines de recherche sont l'intelligence artificielle, l'apprentissage automatique et l'informatique évolutive. Il a obtenu son baccalauréat et son doctorat du Département d'informatique et de technologie de l'Université de Nanjing en 2004 et 2011, respectivement.

En août 2011, il rejoint le Département d'informatique et de technologie et l'Institut d'apprentissage automatique et d'exploration de données (LAMDA) de l'Université de Nanjing pour s'engager dans l'enseignement et la recherche scientifique. Il a remporté le National Excellent Doctoral Dissertation Award en 2013 et le Outstanding Doctoral Dissertation Award de la China Computer Federation en 2011. Publié plus de 40 articles, dont de nombreux articles dans des revues et conférences de classe mondiale telles que l'intelligence artificielle, IJCAI, AAAI, NIPS, KDD, etc. Les résultats de la recherche ont remporté les prix du meilleur article de IDEAL'16, GECCO'11, PAKDD' 08, et champion du concours d'exploration de données PAKDD'06, etc.

Il est le jeune rédacteur en chef adjoint de Frontiers of Computer Science, membre principal du comité de programme d'IJCAI'15/17, IJCAI'16/17 Publicity Chair, ICDM'16 Publicity Chair et ACML'16 Workshop Chair. Les étudiants formés ont remporté le prix du million du concours de recommandation Tmall "Double Eleven", la bourse Google, etc.

Voici une liste des conférences de Yu Yang à titre de référence pour les lecteurs :

-

1. Introduction

-

2. Processus décisionnel de Markov

-

3. Du processus décisionnel de Markov au renforcement de l'apprentissage

-

4. Approximation de la fonction valeur

-

5. Recherche de politique

-

6. Apprentissage par renforcement dans les jeux

-

7. Résumé de l'apprentissage par renforcement

-

8. Recommandation de ressources d'apprentissage par renforcement

La partie précédente a présenté le contenu des deux premières sous-sections, et voici le contenu de la partie suivante :

3. Des processus décisionnels de Markov à l'apprentissage par renforcement

Dans les tâches d'apprentissage par renforcement, la récompense et le transfert sont inconnus et doivent être appris. Il existe deux solutions spécifiques :

L'une consiste à restaurer la fonction de récompense et la fonction de transfert. Tout d'abord, restaurez le MDP, puis résolvez la stratégie sur le MDP. Ce type de méthode est appelé une méthode basée sur un modèle, et le modèle ici fait référence au MDP.

Il existe également une méthode correspondante, la méthode Model-Free, qui ne restaure pas les récompenses et les transferts.

approche basée sur un modèle

Dans ce type d'approche, l'agent maintient le modèle (c'est-à-dire le MDP) puis résout la politique à partir du modèle.

Commencez avec une stratégie aléatoire, placez la stratégie dans l'environnement à exécuter et récupérez le MDP à partir des données de séquence en cours d'exécution. Étant donné que les données de séquence peuvent fournir des informations de supervision sur les transitions environnementales et les récompenses, le simple fait de faire une régression peut savoir où un état se déplacera lorsqu'une action est effectuée, et combien de récompense il peut obtenir.

Voici un moyen très simple d'explorer l'environnement - RMax, qui utilise un modèle de régression très simple appelé counts.

Bien que cela semble très simple, la complexité de l'échantillon de restauration de MDP est le carré du nombre d'états, ce qui est beaucoup plus élevé que la complexité de la stratégie de solution mentionnée ci-dessus. On peut en déduire que la complexité de l'apprentissage du MDP est extrêmement élevée, de sorte que de nombreux travaux de recherche se concentrent sur l'apprentissage sans modèle.

apprentissage sans modèle

L'apprentissage sans modèle présente brièvement deux méthodes. L'une s'appelle la méthode de Monte-Carlo et l'autre la méthode des différences temporelles.

-

Introduction à la méthode d'échantillonnage de Monte-Carlo (méthode de Monte-Carlo)

L'apprentissage sans modèle est très similaire à l'itération de stratégie mentionnée précédemment. Tout d'abord, évaluez la stratégie actuelle ; deuxièmement, améliorez la stratégie actuelle.

Étape 1 Évaluez votre stratégie

Lors de l'évaluation d'une stratégie dans MDP, puisque les récompenses et les transferts sont connus, ces deux fonctions peuvent être utilisées directement pour calculer la valeur d'évaluation. Maintenant, ces deux fonctions ne savent pas, alors que faire ?

Cette fonction de valeur Q est en fait une attente, il suffit donc de remplacer l'attente par un échantillonnage. En d'autres termes, prenez la stratégie et exécutez-la dans l'environnement pour voir quel est le résultat.

Par exemple, après avoir couru, j'obtiens une piste : d'abord le soleil se lève, puis il fait nuageux, et enfin le soleil se lève ; puis je cours une deuxième fois et j'obtiens une piste, puis une troisième fois et j'obtiens une autre piste. Enfin beaucoup de trajectoires. Je sais quelle est la récompense pour chaque trajectoire, puis je fais la moyenne des récompenses pour ces trajectoires en tant qu'estimation de la fonction de valeur de cette politique, en utilisant la fréquence pour approximer l'attente.

Étape 2 Mettre à jour/améliorer la stratégie

De cette façon, nous pouvons évaluer la qualité d'une stratégie. Après avoir évalué une stratégie, vous pouvez prendre la meilleure action indiquée par la fonction de valeur Q comme une nouvelle stratégie comme avant, et le processus de mise à jour est le même.

L'ensemble de l'algorithme est relativement simple à écrire. Nous devons faire m échantillonnage, chaque fois que nous prenons la stratégie actuelle dans l'environnement pour l'exécuter, puis nous obtiendrons une séquence, additionnerons les récompenses en fonction de la séquence, puis mettrons à jour la valeur Q, qui est la valeur moyenne de l'échantillonnage dans l'histoire, et c est le compte.

Une fois qu'une trajectoire est en panne, après la mise à jour de la valeur Q, effectuez la deuxième trajectoire, ce qui permet d'obtenir une méthode d'apprentissage par renforcement qui ne repose pas sur le modèle MDP.

Cependant, cette méthode manque d'exploration environnementale et rend difficile la mise à jour de la stratégie

Cependant, il y a un problème avec cela - si une stratégie déterministe est obtenue, il est possible que les trajectoires prises à partir de 100 échantillons soient les mêmes, ce qui rend impossible d'évaluer les performances de la stratégie dans tous les états, donc la stratégie ne peut pas être amélioré. La clé ici est son manque d'exploration de l'environnement.

Comment explorer l'environnement pour une récompense maximale ?

Comment explorer ? On peut considérer le problème d'apprentissage par renforcement le plus simple : un état, deux actions, une action a une récompense plus élevée, une action a une récompense plus faible, mais les deux récompenses proviennent de deux distributions. Quelle action choisissez-vous à ce stade, ou comment pouvez-vous le faire pour en avoir le plus pour votre argent ? C'est en fait le modèle bandit.

-

À l'extrême, essayez 100 fois et faites chaque action 50 fois. À ce moment, je sais peut-être quelle action est la meilleure, mais la récompense n'est peut-être pas la plus élevée, car après 10 fois, je connais déjà la première action. Le retour est un peu plus élevé, et si l'investissement restant est toujours uniformément réparti, il n'obtiendra pas le rendement maximal.

-

À l'autre extrême, essayez chacun des deux mouvements une fois pour voir lequel a le gain le plus élevé, et les 98 fois restantes vont au gain le plus élevé. Cette méthode n'est pas non plus bonne, car elle n'est essayée qu'une seule fois et le rendement estimé est très instable.

Le premier cas est d'avoir suffisamment d'exploration (exploration), et le deuxième cas est d'avoir un meilleur investissement sans trop d'exploration (exploitation), il faut trouver un équilibre entre ces deux points.

Il existe plusieurs façons de résoudre ce problème. Le moyen le plus simple est d'utiliser la probabilité de 1-, d'investir dans celui qui est optimiste maintenant, et la probabilité restante est complètement aléatoire, et d'essayer chaque action. Cette méthode est appelée -gourmande.

Cette méthode peut garantir que tous les états ont une certaine probabilité, même une faible probabilité, d'être visités. Ainsi, après avoir fonctionné pendant un certain temps, il peut trouver la stratégie optimale.

Mais cette méthode présente également l'inconvénient qu'une valeur doit être spécifiée. Habituellement, cette valeur doit être diminuée jusqu'à ce qu'elle converge vers un meilleur résultat. Il y a aussi un problème d'efficacité. Par exemple, après 10 tentatives d'action A, le rendement moyen est de 10000, et après 10 tentatives d'action B, il est de 0,1. A ce moment, il n'est plus nécessaire d'essayer, car le la distance est très longue. Mais l'exploration de -gourmande ne s'arrête pas, il existe donc d'autres méthodes, comme softmax - qui prend en compte la valeur Q elle-même, si les valeurs des deux actions sont très différentes, la probabilité d'exploration est faible. Une autre méthode plus belle en théorie est UCB (Upper Confidence Bound) :

-

Tout d'abord, la valeur Q est considérée. Si la différence entre la valeur Q elle-même est relativement grande, la possibilité d'exploration est très faible ;

-

Deuxièmement, le nombre d'explorations est considéré. Si le nombre d'explorations est petit, sa confiance peut être relativement faible, et si le nombre d'explorations est important, la confiance sera relativement élevée.

Choisissez donc l'action en fonction de la valeur Q plus la limite supérieure de la confiance, et elle s'équilibrera automatiquement.

Cependant, la méthode la plus couramment utilisée est la première méthode -gourmande. Après avoir donné une stratégie , transformez-la en stratégie d'exploration, c'est-à-dire sélectionnez une action au hasard, et mettez cette stratégie avec exploration dans l'algorithme de Monte Carlo. De plus, cette trajectoire n'est pas générée à partir de , mais à partir de avec exploration, ce qui assure une mise à jour continue de la politique.

Voici une introduction à la politique On/Off : Apprentissage des politiques avec ou sans exploration.

Vous pouvez souvent entendre le terme politique de marche/arrêt.

Dans l'échantillonnage de Monte Carlo, la stratégie est utilisée pour échantillonner, et l'apprentissage n'est pas , mais avec exploration. Parce que les données utilisées pour l'évaluation sont générées à partir de la stratégie avec exploration, et non à partir de la stratégie que nous voulons apprendre. Cette distinction peut conduire à l'exploration dans le cadre de la stratégie. Cette politique d'échantillonnage et de mise à jour est le même algorithme appelé On Policy.

Mais souvent, ce que nous voulons apprendre est en fait une politique sans exploration, c'est-à-dire que nous devons échantillonner à partir de la politique avec exploration, mais seule la politique elle-même, à savoir Off Policy, est mise à jour. Le problème ici est que l'échantillonnage ne provient pas de la stratégie actuelle. La technique d'échantillonnage d'importance couramment utilisée modifie la distribution de l'échantillonnage en celle souhaitée. La distribution de la stratégie peut être modifiée par la simple méthode de pondération, puis cette distribution peut être ajoutée à l'algorithme spécifique. Autrement dit, en ajoutant un poids à la récompense, un tel algorithme devient un algorithme Off Policy, de sorte qu'il apprend lui-même.

Résumé des algorithmes de Monte Carlo

Dans l'ensemble, l'algorithme de Monte Carlo n'est pas un algorithme très efficace, mais il peut présenter les caractéristiques des algorithmes sans modèle.

Nous devons évaluer cette stratégie, puis trouver une direction d'amélioration après l'évaluation, et ensuite nous pouvons améliorer l'algorithme ; ici, afin de mettre à jour efficacement la stratégie, nous devons introduire l'exploration de l'environnement ; et dans l'exploration de l'environnement, nous devons noter les deux concepts de politique On/Off.

De plus, l'algorithme de Monte Carlo a un défaut évident : le modèle ne doit être mis à jour qu'après l'obtention de la trajectoire complète.

-

Méthode de différence temporelle

Le modèle peut-il être mis à jour à chaque étape du processus ? Il existe une propriété dans l'algorithme de Monte Carlo, c'est-à-dire que lorsque la valeur Q est mise à jour, la moyenne est en fait mise à jour.

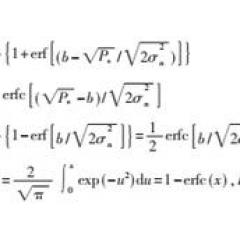

La moyenne mise à jour peut aussi s'écrire : t = t-1 + (xt _ t-1), ce qui signifie que ce que nous venons de mettre à jour est la valeur Q (la formule est montrée dans la figure ci-dessous), où R Q (st, at) est appelée erreur de Monte Carlo. Nous savons que Q est une estimation de la récompense, et R est la vraie récompense après avoir miné cette trajectoire. En d'autres termes, la mise à jour de la valeur Q d est la différence entre la valeur réelle et la valeur estimée, c'est-à-dire l'erreur de Monte Carlo.

Dans l'algorithme TD, nous avons franchi une étape et obtenu la vraie récompense, et nous ne sommes pas allés plus loin, donc nous ne savons pas quelle est la vraie récompense, mais nous pouvons estimer la récompense suivante à travers la valeur Q précédente. l'addition est l'information actuellement connue, et elle est utilisée pour remplacer ce R pour soustraire l'ancienne valeur estimée.Nous appelons ce processus la différence temporelle.

Si vous utilisez Monte Carlo, vous devez d'abord aller à la fin. Après avoir connu le résultat global, la différence de chaque étape peut être calculée ; pour TDL, vous n'avez besoin d'enregistrer que les informations d'une étape, vous pouvez donc vous mettre à jour en ligne .

-

SRAS

La programmation dynamique enregistre des informations sur tous les états. En remplaçant l'erreur de Monte Carlo par TD errpr, la méthode d'apprentissage par renforcement de la nouvelle méthode TD peut être obtenue. Cette méthode ne collecte pas la trajectoire entière, mais utilise TDL pour mettre à jour la valeur Q en fonction de la stratégie d'exploration, et met à jour le jugement de la stratégie courante à chaque étape, puis met à jour la stratégie. Cet algorithme est appelé SARSA, qui appartient à la politique On, et devient la politique Off. Une seule modification est apportée, et l'erreur TD est calculée par la stratégie de non-exploration, et l'algorithme Q-Learning est obtenu.

-

SARSA vs Q-learning

Il s'agit d'un problème d'escalade de réseau, un problème classique typique d'apprentissage par renforcement.

L'action consiste à marcher de haut en bas, de gauche à droite, et il y a une récompense de -1 pour chaque pas. De l'état initial à l'état final, prenez le chemin le plus court pour maximiser la récompense. Il y a une falaise sur l'image. Une fois que vous atteignez la falaise, la récompense sera extrêmement faible et vous devrez revenir à cet état initial.

L'utilisation de On Policy SARSA ici aura une certaine probabilité d'exploration, et elle peut tomber sous la falaise, donc la récompense sera relativement faible ; lors de l'utilisation de Q Learning, parce que la stratégie finale n'implique aucune exploration, il n'y a aucun hasard, donc le chemin est le plus court.

C'est la différence entre les deux types d'algorithmes d'apprentissage par renforcement. Vous pouvez voir dans le processus d'apprentissage que la valeur de Q Learning est faible, car l'apprentissage exploratoire doit être effectué lors de l'apprentissage, vous devez donc continuer à vous entraîner pendant le processus de formation.

De plus, la mise à jour d'erreur TD mentionnée ci-dessus est une mise à jour après une étape.En fait, une mise à jour en deux étapes et une mise à jour en N étapes peuvent être effectuées. Il existe donc un moyen de faire beaucoup d'étapes et de les combiner selon un poids de probabilité.Après la combinaison, vous obtenez un TD appelé -retour, qui est un TD d'une étape, de deux étapes et de plusieurs étapes.

4. Approximation de la fonction valeur

Toutes les questions que nous venons de mentionner, la prémisse est qu'elles peuvent être exprimées dans des tableaux. Mais de nombreux environnements du monde réel ne peuvent pas être représentés dans des tableaux. Par conséquent, dans les premiers jours du développement de l'apprentissage par renforcement, il n'a pas pu être utilisé dans des problèmes réels à grande échelle. Plus tard, tout le monde a pensé, comment mettre cet apprentissage par renforcement dans un espace d'état continu, même dans une situation où les actions sont continues, comme le contrôle d'un hélicoptère.

Vous pouvez penser qu'il y a une grande différence entre le processus d'apprentissage de l'apprentissage par renforcement et l'apprentissage supervisé, et les algorithmes et les modèles semblent être complètement différents. Mais après être entré dans l'espace d'état continu, il y aura de nombreuses similitudes entre les deux.

Une table peut être utilisée pour représenter une fonction de valeur ou une politique dans un état discret ; mais entrer dans un espace d'état continu nécessite une approximation d'une fonction, appelée approximation de la fonction de valeur.

Par exemple, nous pouvons utiliser une fonction linéaire pour représenter, la valeur V est une valeur inférieure à l'état s, l'état s a d'abord un vecteur caractéristique (s), cette valeur V est exprimée sous la forme d'un paramètre linéaire multiplié par la valeur interne du produit vedette. Il y a une action dans la valeur Q. En supposant que l'action est discrète, une façon est de mettre l'action et l'état ensemble dans une caractéristique, et l'autre façon est de créer un modèle pour chaque action.

Lorsque vous rencontrez le problème de l'espace continu, il semble naturel d'utiliser l'approximation pour représenter les fonctions de valeur V et Q, mais après approximation, on constatera que de nombreux résultats théoriques dans le passé ne tiennent pas.

Mais ignorons ces problèmes pour l'instant, regardons comment apprendre après avoir fait des approximations ? Ce que nous voulons savoir, c'est que la valeur Q ici doit se rapprocher le plus possible de la valeur Q réelle après que la valeur Q est approchée. Si vous connaissez déjà la vraie valeur de Q, comment l'approximer ? Le plus simple est de faire une régression par les moindres carrés. Une des solutions est la dérivation. Après la dérivation, la dérivée est exprimée comme la différence entre le Q réel et le Q estimé, puis multipliée par la dérivée du modèle de valeur Q. On peut voir que la signification exprimée par la dérivée est cohérente avec l'erreur Carlo du modèle précédent et l'erreur TD, mais le paramètre w est mis à jour. En mettant cette méthode de mise à jour dans l'apprentissage Q, rien d'autre n'a changé, seule la méthode Q-Learning approximée par la fonction de valeur est obtenue.

Quelle fonction utilise ce modèle ? Le plus simple est d'utiliser une fonction linéaire. Cependant, les fonctions linéaires ont de nombreuses limites et elles doivent travailler dur sur la conception des fonctionnalités, ce qui nécessite une bonne conception manuelle.

Pour le transformer en une fonction non linéaire, une méthode courante consiste à utiliser un réseau de neurones pour représenter directement la valeur Q avec un réseau de neurones. C'est aussi très simple lors de la mise à jour, il suffit de passer le gradient au réseau de neurones, car l'algorithme BP du réseau de neurones lui-même cherche aussi le gradient.

Améliorez-vous avec l'apprentissage par lots

Il y a aussi des pistes pour s'améliorer. Par exemple, lorsque nous formons un modèle approximatif, la formation sur un échantillon peut être instable, nous pouvons donc utiliser des modèles par lots pour accumuler un lot de données pour former le modèle.

Toutes les méthodes d'entraînement que nous venons de mentionner consistent à estimer d'abord la valeur V ou la valeur Q, puis à en déduire la stratégie. Nous appelons cette approche une approche d'apprentissage par renforcement basée sur la fonction de valeur.

5. Recherche de politique

Problèmes d'estimation de la fonction de valeur : dégénérescence des politiques

Cependant, il y a un problème avec l'estimation de la fonction de valeur - cette méthode peut converger vers la stratégie optimale, mais la prémisse doit être sous la forme d'un tableau ; si une approximation de la fonction est utilisée, la stratégie dégénérera, c'est-à-dire plus la valeur Q est estimée, plus elle est grande, plus la stratégie est mauvaise.

Pour donner un exemple simple, il y a maintenant deux états, l'un est l'état 1 et l'autre est l'état 2, la caractéristique de l'état 1 est 2 et la caractéristique de l'état 2 est 1. Nous fixons la récompense de sorte que la valeur V optimale pour l'état 2 soit supérieure à celle de l'état 1. À ce stade, si une fonction linéaire est utilisée pour représenter le V, c'est-à-dire que la caractéristique est multipliée par W. Cette caractéristique n'a qu'une seule dimension. La valeur V optimale 2 est supérieure à 1, la valeur propre de 1 est supérieure et la caractéristique de 2 La valeur est plus petite, donc le W optimal doit être un nombre négatif, ce qui rendra V(2) plus grand que V(1), de sorte que la politique optimale peut être dérivée.

Cependant, la méthode basée sur la fonction de valeur consiste à rendre la valeur V aussi proche que possible de la valeur V optimale, et la valeur V optimale est positive, ce qui conduira à ce W doit être positif, et la stratégie optimale ne peut pas être obtenue . De cette manière, plus la fonction de valeur est estimée avec précision, plus la politique est mauvaise, ce que l'on appelle la dégradation de la politique.

Résolution des problèmes de dégénérescence des politiques avec la recherche de politiques

Afin d'éviter la dégradation de la politique, notre méthode consiste à trouver la politique directement, c'est-à-dire la recherche de politique.

Tout d'abord, paramétrez la politique. Pour les actions discrètes, les paramètres peuvent être définis comme la politique de Gibbs, c'est-à-dire que chaque action a un paramètre, puis normalisez-le afin que chaque action ait une probabilité. S'il s'agit d'une action continue, elle peut être décrite par une distribution gaussienne. À l'intérieur de ce paramètre, ce que j'ai écrit ici est un processus linéaire, mais il peut aussi être remplacé par un réseau de neurones.

La méthode pour optimiser directement les paramètres de la stratégie afin de maximiser le rendement total reçu est la recherche de politique.

Avantages de la recherche de politique

Quels sont les avantages et les inconvénients de la recherche de politiques par rapport aux méthodes basées sur la fonction de valeur ?

-

Premièrement, il peut gérer des états et des actions continus ;

-

Deuxièmement, les performances globales sont meilleures pour les données de grande dimension.

-

Troisièmement, les stratégies aléatoires peuvent être apprises directement

-

Quatrièmement, la compatibilité entre Policy Search et l'apprentissage supervisé est relativement bonne.

Le troisième point est très utile, par exemple, au jeu "roche papier ciseaux", si vous choisissez une stratégie déterministe, vous perdrez définitivement, vous devez faire une sortie probabiliste pour gagner.

Il existe un autre exemple pour vous expliquer pourquoi la stratégie du hasard est nécessaire.

Le squelette signifie que vous mourrez lorsque vous l'atteindrez ; la stratégie optimale est certainement d'aller au milieu, mais il y a ici deux grilles grises, qui représentent l'état d'observation incomplète, c'est-à-dire qu'après avoir marché jusqu'à la grille grise, vous ne sais pas s'il faut aller à gauche ou à droite. ;

-

Si la stratégie déterministe est à nouveau utilisée à ce moment, elle ne peut qu'aller à gauche ou à droite, et elle ne peut qu'être déterminée, et il est possible de rencontrer un chemin qui ne peut pas être suivi.

-

Si vous utilisez une stratégie aléatoire, la probabilité d'aller à gauche et à droite est de 50 %, donc peu importe la direction que vous prenez, vous atteindrez toujours l'objectif.

Cela reflète également les avantages de la recherche stratégique.

Quatrièmement, la compatibilité entre la recherche de politiques et l'apprentissage supervisé est relativement bonne.

Cette stratégie est exprimée en termes de paramètres et son objectif est de maximiser la récompense. Maximiser la récompense revient à énumérer toutes les trajectoires dans l'espace. Parce que la stratégie a une certaine probabilité de générer ces trajectoires, dans un certain état, la probabilité que la stratégie fasse l'action correspondante est déterminée par la stratégie, et la probabilité de générer cette trajectoire est obtenue en multipliant les probabilités de toutes les actions sur tous trajectoires probabilité. Par conséquent, son rendement global attendu est l'espérance de toutes les trajectoires, c'est-à-dire la probabilité de chaque trajectoire multipliée par la récompense pouvant être obtenue par chaque probabilité, ce qui est également une autre façon d'écrire le rendement total. L'avantage de cette façon d'écrire est qu'elle est liée à l'objectif du paramètre de politique, donc je peux directement dériver la récompense pour résoudre la politique. Une autre façon d'écrire est la distribution stationnaire, qui est complètement équivalente à l'écriture ci-dessus, signifiant exactement la même chose, donc je vais la sauter ici.

La recherche de politique a également un inconvénient, dont l'un est qu'il existe de nombreuses solutions optimales locales, ce qui perd la garantie de convergence de l'optimalité globale, et le second est que la variance du processus d'apprentissage est très élevée.

-

Méthode de dérivation de stratégie précoce : différence finie

Je crois que tout le monde pourra prendre la dérivation, mais il y a un moyen que vous n'avez peut-être pas vu - la différence finie, qui est la méthode utilisée pour la dérivation de stratégie au début.

Quand utilise-t-on la différence finie ? Il se peut que le système soit trop compliqué pour être dérivé facilement, de sorte que cette dérivée peut être approximée de manière simple. Obtenez un paramètre , la dérivée de est de voir dans quelle direction est la plus rapide, ajoutez donc une petite valeur de perturbation à , échantillonnez la zone locale autour de , et l'échantillonnage croît le plus rapidement, cette direction comme direction dérivée. C'est la méthode la plus simple.Bien sûr, cette méthode a de nombreux défauts, surtout dans le cas de grandes dimensions, elle nécessitera beaucoup d'échantillonnage, donc la méthode la plus directe est de dériver directement.

Enfin, une dérivée est obtenue, et la forme dérivée est la suivante :

E est l'attente, 1 à T représentent que la trajectoire de T étapes est considérée, et la trajectoire de chaque étape prend la dérivée du logarithme de la valeur de sortie de la politique, puis multipliée par la récompense réelle (la récompense n'est pas logarithmique) . La récompense est une constante, c'est-à-dire la valeur de récompense obtenue par la trajectoire.

L'espérance peut être approximée par échantillonnage. Après une politique, exécutez quelques trajectoires, puis calculez le gradient moyen comme une approximation de l'espérance du gradient.

Comme nous venons de le mentionner, cette méthode a un gros défaut, c'est-à-dire que sa variance est très grande.Pour mettre à jour la politique directement avec le gradient calculé (vallina policy gradient), en gros, vous ne pouvez pas obtenir une bonne politique car sa variance est trop élevée. et instable.

Méthodes de contrôle de la variance 1. Acteur-Critique

Il existe plusieurs façons de contrôler la variance, dont l'une s'appelle Acteur-Critique. La stratégie est obtenue par dérivation directe, qui est appelée Acteur ; la fonction de valeur est estimée et utilisée pour évaluer la stratégie, qui est Critique, ce qui signifie qu'elle est un évaluateur.

Nous voulons maintenir un modèle de la fonction de valeur Q. De plus, lorsque vous utilisez la méthode dérivée pour trouver le gradient de la politique, au lieu d'utiliser directement la récompense, utilisez la valeur Q fournie par Criitic. Donc Actor-Critic maintiendra deux modèles, le premier est le modèle de la politique, et le second est le modèle de la fonction Q.

Lors de l'approximation de la fonction Q, la formule est la même que la forme dérivée ci-dessus, et la récompense d'expérience qu'elle contient est remplacée par la valeur Q. Lors du calcul du gradient politique, la valeur Q est une constante et n'est pas mise à jour. Elle a sa propre méthode de mise à jour et correspond généralement à la valeur Q réelle.

Méthode de contrôle de la variance 2. Introduction d'un terme de biais

Une autre forme de contrôle de la variance consiste à introduire un terme de biais. Tant que la fonction est une fonction qui n'est liée qu'à l'état et n'a rien à voir avec l'action, son intégrale est 0, ce qui n'affecte pas la direction de la gradient, mais affecte la variance du gradient.

Pour la forme simple, nous pouvons directement trouver quel est l'écart optimal. Dans une forme plus générale, nous pouvons utiliser la valeur V au lieu du biais. Étant donné que la valeur V est une valeur estimée de l'état et n'a rien à voir avec l'action, elle sera de 0 lorsqu'elle sera intégrée à l'intégrale.

Lorsque la valeur V est introduite, ce dernier Q devient Q-V, qui est appelé fonction d'avantage, ce qui signifie : dans cet état, la valeur V équivaut à une valeur moyenne, et la valeur Q fait référence à la mesure dans laquelle une action est supérieure à la valeur moyenne. L'utilisation de la fonction Advantage améliorera le contrôle de la variance une fois le gradient de politique effectué.Ce n'est que lorsque la variance est bien contrôlée que ce type d'algorithme peut vraiment fonctionner.

Autres méthodes d'amélioration

La méthode d'amélioration du gradient est également Nature Policy Gradient. En apprentissage supervisé, les gradients stochastiques sont facilement parallélisés. Il y a eu des travaux théoriques récents qui explorent également que son parallélisme n'affecte pas ses propriétés théoriques. Dans le gradient politique, on peut aussi faire ce gradient en parallèle, ce qui peut le rendre très rapide.

Il existe également des méthodes de dérivation directe des politiques, telles que l'optimisation sans dérivation. Ce type de méthode n'a pas d'importance ce que fait l'apprentissage par renforcement, mais optimise directement les paramètres de la politique. Après avoir optimisé les paramètres, essayez la stratégie pour savoir quelle est cette valeur.

De cette manière, l'algorithme optimisé peut ajuster les paramètres du modèle en fonction de la valeur globale de la récompense. D'une manière générale, il est moins efficace que d'utiliser Gradient Policy.Comme le processus intermédiaire est négligeable, il a un meilleur effet sur des problèmes particulièrement complexes, tels que les jeux Tetris.

6. Apprentissage par renforcement dans les jeux

La dernière partie, parler de l'apprentissage par renforcement et des jeux.

Pourquoi parler de jeux ? D'une part, c'est parce que certains problèmes qui doivent être surmontés dans les jeux sont souvent rencontrés dans des applications réelles ; d'autre part, le coût d'utilisation des jeux pour effectuer des tâches d'apprentissage par renforcement est relativement faible.

-

Le jeu stimule l'apprentissage par renforcement profond

En 2015, DeepMind a utilisé des réseaux profonds pour entraîner l'apprentissage par renforcement directement à partir d'images d'écran sur les jeux Atari, favorisant directement le développement de «l'apprentissage par renforcement profond».

Utilisez un réseau neuronal profond, placez-le dans le gradient de politique, en tant que modèle de la politique ; ou placez-le dans la méthode basée sur la fonction de valeur, en tant qu'estimation de la valeur Q de la fonction de valeur. Une telle approche est appelée apprentissage par renforcement profond.

apprentissage par renforcement profond

En fait, beaucoup de travail dans l'apprentissage par renforcement profond consiste à étudier comment rendre le réseau plus stable. Surtout lorsque les données d'entrée sont relativement petites, la fluctuation de la variance du réseau sera relativement importante. Cela peut être résolu avec des "mises à jour paresseuses" - avec des réseaux de neurones profonds, la mise à jour du modèle à chaque étape du processus peut faire beaucoup trembler le modèle. Et avec "mise à jour retardée", par exemple, vous ne pouvez pas mettre à jour la stratégie en 100 étapes, il suffit de mettre à jour le réseau de neurones, ce réseau de neurones n'est pas mis dans la nouvelle stratégie, puis de le mettre à jour après que le réseau de neurones ait une montée relativement stable Stratégie . De plus, ne jetez pas les données accumulées, mais retirez-les également pour rendre le réseau de neurones plus stable. Ces deux compétences sont réunies dans Q-Learning, qui est DQN.

-

Réseau Q profond (DQN)

DQN est sans doute le premier et probablement le plus connu à revendiquer un algorithme d'apprentissage par renforcement profond. Fondamentalement, sa structure globale est une approximation de fonction Q Learning, mais CNN est utilisé pour créer une fonction approximative.

Au moment de jouer au jeu, il avait déjà un million d'historique enregistré. Chaque fois qu'un réseau de neurones est formé, 32 d'entre eux doivent être formés une fois, et la stratégie n'est pas mise à jour après la formation, mais après un certain nombre d'étapes, la stratégie est mise à jour. De plus, au lieu de prendre une trame d'image directement depuis l'écran, il s'agit de mettre ensemble plusieurs trames de l'écran dans l'historique pour obtenir une vue d'ensemble de la trame courante et des trames précédentes selon l'entrée de CNN. Cependant, dans les derniers travaux, ce processus a été remplacé par un réseau de neurones récurrent : au lieu d'assembler plusieurs couches, plusieurs trames sont entrées dans un réseau tel que LSTM.

De nombreux jeux qui utilisent l'apprentissage par renforcement pour trouver des stratégies ont été mieux joués que les humains, et l'avantage de bien jouer se reflète principalement dans la vitesse de réaction. Mais dans les jeux qui nécessitent une réflexion approfondie sur les relations logiques, personne ne fait bien l'apprentissage par renforcement.

Jetons un coup d'il aux résultats de son rapport de match.

Ici, "avec relecture" et "sans relecture" signifient si les données historiques sont utilisées, et "avec cible Q" et "sans cible Q" utilisent CNN ou un réseau linéaire. Nous pouvons voir que le réseau de neurones ne contribue pas le plus ici. Si nous n'utilisons que le réseau de neurones sans relecture, l'effet n'est pas aussi bon que l'utilisation de la relecture, mais uniquement le modèle linéaire sans CNN. Bien sûr, il est préférable d'utiliser simultanément des modèles approfondis et l'apprentissage par renforcement, ce qui peut accomplir certaines choses qui ne pouvaient pas être faites dans le passé.

Application dans AlphaGo

Le cadre de base du système AlphaGo est la recherche arborescente de Monte Carlo, qui est une méthode de recherche arborescente classique. Cependant, la recherche arborescente de Monte Carlo ne peut à elle seule donner de très bons résultats, et seule la recherche arborescente ne peut atteindre que cinq ou six sections amateurs. Un point innovant dans AlphaGo est l'introduction de l'apprentissage par renforcement pour améliorer la profondeur et la largeur de l'arbre de recherche.

Trois réseaux de neurones sont utilisés ici.

-

Le premier réseau de politiques, qui fonctionne lors de l'expansion de l'arbre de Monte Carlo pour rechercher des nuds. Ce réseau est entraîné à l'aide de la méthode du gradient de politique.

-

Le second est un très petit réseau de neurones qui est utilisé pour effectuer des recherches approfondies plus bas dans la recherche arborescente de Monte Carlo, de sorte qu'il puisse être calculé très rapidement. Ce petit réseau est appris par apprentissage supervisé.

-

Le troisième réseau est utilisé pour corriger la valeur. Il est appris à travers des données générées au milieu de l'apprentissage par renforcement.

Étant donné que tout le monde connaît DQN, lorsque vous essayez un apprentissage en profondeur, la plupart des algorithmes qui vous viennent à l'esprit sont DQN. Mais comme il s'agit d'une méthode d'apprentissage par renforcement basée sur l'estimation de la fonction de valeur, cette méthode peut ne pas fonctionner dans un environnement d'application légèrement plus complexe, et tout le monde aura le sentiment que l'effet de l'apprentissage par renforcement avec DQN n'est pas si bon. Mais c'est aussi le jeu de Go créé par DeepMin. Sa méthode d'apprentissage par renforcement a été changée en Policy Gradient, et de nombreux futurs algorithmes sont également basés sur Policy Gradient. Cette méthode est meilleure pour traiter des problèmes complexes.

Application sur d'autres jeux

C'est précisément parce que le coût de la simulation de jeux sur ordinateur est très faible que les chercheurs continuent d'utiliser les jeux pour développer l'apprentissage par renforcement. Par exemple, utile dans les jeux de tir à la première personne en 3D, où vous pouvez vous promener dans le monde et chercher des choses. L'année dernière, il y avait un concours de jeux "DOOM", dans lequel les concurrents utilisaient des personnages contrôlés par ordinateur pour filmer en 3D du premier point de vue. Avec l'apprentissage par renforcement, le concurrent peut contrôler le personnage du jeu et lui faire effectuer certaines actions. En raison de l'environnement complexe de ce jeu, certaines méthodes innovantes ont également été développées dans le processus de jeu.

Par exemple, dans un jeu, si vous laissez un apprentissage par renforcement apprendre directement dans l'environnement du jeu, il devra ramasser des boîtes médicales, des armes, etc., ce qui est trop compliqué. Et l'une des équipes a adopté cette approche : ils ont laissé l'apprentissage par renforcement passer du simple au complexe, et apprendre étape par étape - apprenez d'abord une stratégie, comme ramasser une boîte médicale, puis apprenez à apprendre en fonction de cette stratégie pour tirer , comment tirer sur l'ennemi, etc.

En fait, il existe de nombreux défis très difficiles dans le jeu, dont l'un est un jeu très compliqué appelé StarCraft. Ce jeu a une histoire de plusieurs années, et maintenant de nombreuses personnes, y compris DeepMind, espèrent montrer une bonne performance dans un jeu aussi complexe, car la complexité de ce jeu est si grande qu'il peut être utilisé dans de nombreuses applications réelles. est comparable, même si les gens apprennent ce jeu, il faudra beaucoup de temps pour apprendre. Dans le passé, l'apprentissage par renforcement était utilisé, et un seul des petits problèmes était pris à résoudre. Par exemple, l'adversaire et moi envoyons chacun trois pions, essayant de trouver un moyen de voir comment ces six pions se battent. C'est une bataille très locale, mais c'est plutôt bien d'apprendre quelque chose comme ça. Si vous voulez apprendre à jouer à l'ensemble du jeu, cela implique beaucoup de problèmes. Premièrement, son échelle est beaucoup plus grande que celle du Go. Deuxièmement, il y a beaucoup d'informations sur les adversaires qui ne peuvent pas être observées, comme les actions. de l'ennemi. Bien qu'au début de cette année, les machines aient battu les joueurs humains dans le jeu Texas Hold'em, le Texas Hold'em est en fait un jeu de cartes très simple. Nous voulons que l'apprentissage par renforcement soit utilisé dans les tâches de jeu à grande échelle sans observer les informations de l'adversaire. Sous le commandement, plus de 200 unités sont chargées de faire des exercices continus, et elles doivent marcher des centaines de milliers de pas pendant plus d'une demi-heure, ce qui n'est toujours pas bien fait.

7. Résumé de l'apprentissage par renforcement

L'introduction précédente n'est qu'une petite partie de l'apprentissage par renforcement. L'apprentissage par renforcement comprend également beaucoup de choses :

Par exemple, s'il y a une situation non observable dans MDP, elle n'appartient pas à Markov, et il existe une direction spéciale telle que POMDP pour résoudre ce problème.

Il y a aussi Learning from Demonstrations, ce qui signifie que les gens font d'abord des démonstrations, puis enseignent à l'agent à partir des données de démonstration. Par exemple, AlphaGo, lors de la formation, n'est pas allé directement à l'apprentissage par renforcement, mais a d'abord collecté beaucoup de données sur le combat humain.

Il existe de nombreuses façons de concevoir la fonction de récompense.

Vous trouverez ci-dessous un résumé des deux problèmes qui nous préoccupent le plus.

-

Première question : l'apprentissage par renforcement a-t-il mûri ? Comment choisir un algorithme dans un problème d'apprentissage par renforcement ?

Si vous rencontrez un problème d'apprentissage par renforcement relativement simple, vous pouvez utiliser une méthode basée sur la fonction de valeur, telle que DQN, pour des problèmes plus complexes, vous pouvez utiliser la méthode Policy Gradient pour effectuer le gradient de politique.

Cependant, à en juger par l'état de développement actuel, la maturité de l'apprentissage par renforcement est loin d'être suffisante, c'est-à-dire que dans le domaine de l'apprentissage par renforcement, il y a encore beaucoup de place à l'amélioration, et il est possible de faire un nouvel algorithme avec de meilleures performances. Mais les problèmes à grande échelle sont encore difficiles à résoudre. Cette grande échelle signifie qu'il a un grand espace d'état et un nombre d'étapes particulièrement important.

-

La deuxième question : Quels goulots d'étranglement seront rencontrés dans l'application de l'apprentissage par renforcement dans les domaines pratiques ?

1. L'apprentissage par renforcement nécessite une exploration, ce qui comporte des risques dans de nombreux scénarios.

Prenons l'exemple des actions recommandées. J'avais déjà une stratégie de parrainage qui me convenait et me rapportait un million par jour. Mais maintenant, pour former l'apprentissage par renforcement, pour explorer, essayez des actions aléatoires. Si je vous dis que cette exploration va vous faire perdre plusieurs millions aujourd'hui, et qu'un mois plus tard vous pouvez gagner 100 millions, alors il faut mesurer le risque de regarder la surface, et oser l'utiliser.

2. Pourquoi l'apprentissage par renforcement est-il davantage utilisé dans de nombreux jeux ?

Les jeux fonctionnent sur des ordinateurs à haute vitesse et à faible coût. S'il est exécuté dans le monde réel, comme s'il s'exécute sur la ligne du système de recommandation, il doit alors gérer l'environnement réel. Son processus d'apprentissage nécessite une exploration continue, et il peut rencontrer de nombreux problèmes lorsqu'il est déployé dans un environnement réel. S'il existe un meilleur simulateur, ces problèmes peuvent être réduits. De plus, s'il existe de meilleures données d'apprentissage supervisé, il sera également une stratégie initiale peut être fait, mais cette stratégie peut partir d'un point de départ légèrement plus élevé. Les robots ont généralement un simulateur de robot, donc ils le font généralement d'abord dans le simulateur, puis mettent la stratégie sur le robot pour apprendre. Mais d'autres problèmes du monde réel peuvent ne pas être aussi bons dans le simulateur.

8. Livres recommandés pour les ressources d'apprentissage par renforcement

Il n'y a pas beaucoup de livres sur l'apprentissage par renforcement. Le livre le plus classique est le manuel de Richard S. Sutton ; le livre de Masashi Sugiyama est une monographie ; Reinforcement Learning: State-of-the-Art est une anthologie avec une large couverture, mais nécessite que les lecteurs aient une certaine base ; il existe également des livres sur le MDP ; en outre, l'apprentissage par renforcement est mentionné dans les livres d'apprentissage automatique.

Ressources en ligne

OpenAI Gym : Une plateforme d'apprentissage par renforcement de base avec de nombreux environnements sur lesquels les chercheurs peuvent faire des expériences, ce qui favorise grandement ce domaine. Il y a aussi une vidéo d'enseignement en ligne de David Silver, le directeur technique d'AlphaGo, qui est très bien.

L'endroit où le journal a été publié

Les articles sur l'apprentissage par renforcement sont principalement publiés dans des revues et des conférences sur l'IA. Les revues incluent l'intelligence artificielle, JAIR, JMLR, Machine Learning, JAAMAS, etc., et les conférences incluent IJCAI, AAAI, NIPS, ICML, ICLR, AAMAS, IROS, etc.

Ce qui précède est le discours du Dr Yu Yang. Pour plus de contenu, veuillez continuer à prêter attention à Lei Feng.com.