Ji-won nouveau rapport

Source: Université Jiaotong de Shanghai

Auteur: Zeping Yu, Liu Gongshen

Editeur: Xiao Qin, Jin Lei

[Introduction de nouveaux Zhi Yuan ] Université Jiaotong de Shanghai récemment réseau de neurones récurrents de découpage proposé (SRNN), sa vitesse est 136 fois la norme RNN, et aussi plus rapide! Analyse expérimentale de six grands ensembles de données montrent des émotions, SRNN de performances que la norme RNN.

Documents et Open Source Adresse:

https://arxiv.org/pdf/1807.02291.pdf

https://github.com/zepingyu0512/srnn

Dans de nombreuses tâches de la PNL, réseau de neurones récurrents (RNN) a obtenu un grand succès. Cependant, une telle structure cyclique qui les rend difficiles à paralléliser nécessite donc beaucoup de RNN de formation à temps.

Zeping Yu Université Jiaotong de Shanghai et Gongshen Liu, dans le journal « Réseaux de neurones récurrents en tranches » dans l'architecture nouvelle proposée « tranche du réseau de neurones récurrents » (SRNN). parallélisme SRNN peut être réalisé par la séquence en plusieurs séquences. SRNN à travers plusieurs couches pour obtenir des informations de niveau élevé, sans avoir besoin de paramètres supplémentaires.

Les chercheurs ont démontré que l'utilisation d'une fonction d'activation linéaire standard RNN est un cas particulier de SRNN. Sans changer l'unité de circulation, SRNN vitesse est de 136 fois la norme RNN Et quand la séquence de formation plus pourrait être plus rapide . Analyse expérimentale de six grands ensembles de données montrent des émotions, SRNN meilleures performances que la norme RNN.

RNN variété de méthodes pour améliorer la vitesse de formation

Recurrent Neural Network (RNN) a été largement utilisé dans de nombreuses tâches de la PNL, y compris la traduction automatique, la réponse aux questions, la catégorisation de texte et image description. RNN est possible d'obtenir des informations d'ordre de la séquence d'entrée. Top deux unités de circulation est Mémoire à court et à long terme (LSTM) et Unité à recyclage porte (GRU) , Qui tous deux peuvent être stockées dans la mémoire précédemment caché, et utiliser le mécanisme de déclenchement doit être déterminé avant la mémoire doit être combiné avec le courant d'entrée dans quelle mesure. Cependant, en raison de sa structure cyclique, RNN ne peut pas parallèle calcul. Par conséquent, la formation RNN besoin de passer beaucoup de temps, ce qui limite la recherche académique et les applications industrielles.

Pour résoudre ce problème, certains chercheurs tentent dans le domaine de la PNL réseau neuronal convolutif (CNN) au lieu de RNN . Cependant, CNN n'a pas pu obtenir une séquence d'information de séquence, et des informations d'ordre est très important des tâches de la PNL.

Certains chercheurs ont essayé RNN d'augmenter le taux en améliorant l'unité de circulation Et obtenu de bons résultats. En combinant RNN et CNN, un réseau de neurones vitesse quasi-cyclique (QRNN) a augmenté de 16 fois. 2017 Tao Lei, qui a proposé une unité de cycle simple SRU (simple unité récurrente), par rapport LSTM 5-10 fois plus rapide. De même, Recurrent Neural Networks fortement typé (T-RNN) et une unité de grille de plancher (MGU) procédé peuvent également améliorer l'unité de cycle.

Bien que plus rapide RNN réalisé dans ces études et l'unité de circulation est améliorée, mais la séquence complète de la structure cyclique reste constante. Nous avons encore besoin d'attendre la sortie de l'étape précédente, existe donc toujours goulot d'étranglement RNN. Dans cet article, nous vous proposons une boucle de tranche réseau de neurones (SRNN), sans changer dans l'unité de circulation peut être beaucoup plus rapide que la norme RNN. Nous montrons que lors de l'utilisation d'une fonction d'activation linéaire standard RNN est un cas particulier de SRNN, SRNN en mesure d'obtenir la séquence d'information de haut niveau.

Pour notre modèle est comparé à la norme RNN, nous avons choisi comme unité de cycle GRU. Autre unité de circulation peut être utilisée dans notre structure, parce que nous pouvons améliorer la structure globale de l'ensemble de la séquence RNN, plutôt que de changer l'unité de circulation. Nous avons terminé les expériences sur les six grands ensembles de données, prouvent la performance SRNN sur tous les ensembles de données que la norme RNN.

Nous code d'implémentation open source:

https://github.com/zepingyu0512/srnn

Tranche structure de réseau de neurones récurrent SRNN

Nous avons construit une nouvelle structure de RNN appelé le cycle de découpage du réseau neuronal (SRNN), comme représenté sur la Fig. Dans la Fig. 2, également appelé une unité de cycle A.

Figure 2: Structure SRNN. Il est obtenu en divisant une séquence d'entrée en plusieurs égale une séquence de longueur minimale construit. unité de circulation peut fonctionner simultanément sur chaque séquence, l'information peut être transmise par une multicouche.

X est la longueur de la séquence d'entrée est T, la séquence d'entrée est la suivante:

Où x est l'entrée de chaque étape, il peut avoir une pluralité de dimensions, par exemple le mot intégré. X est ensuite divisé de manière égale en une longueur de n sous-séquences, chaque séquence de longueur n est égal à:

Où n est le nombre de tranches, la séquence X peut être exprimée sous la forme:

Dans lequel chaque séquence est la suivante:

De même, nous allons couper à nouveau chaque sous-séquence N égale longueur n sous-séquences, l'opération de découpage en tranches est répété k fois, jusqu'à ce qu'on ait une séquence minimale d'une longueur appropriée (que nous appelons la première couche est égal à 0, comme représenté en bas 2), obtenu par la tranche k + 1 couche k-th. Une longueur de séquence minimale de la couche 0:

Une couche de séquence de nombre minimal est 0:

Etant donné que la couche p (p > Chaque séquence du parent 0) est découpé en n parties, le nombre de sous-séquence de la première couche p est la suivante:

Et la longueur de sous-séquence de la couche p est la suivante:

2, par exemple. T longueur de la séquence est de 8, le nombre k de la tranche 2, les numéros de tranche n sont chacun couche p est égal à 2. Au bout de deux sections de séquence, la première couche était de 04 une longueur de séquence minimale de chaque séquence est un 2 minimal. Si la longueur de la séquence ou sous-séquence de celle-ci un ne peut pas être divisé par n, on peut utiliser le processus de remplissage ou de sélectionner un nombre différent de tranches dans chaque couche. K et n peuvent être différentes pour différentes tâches et ensembles de données.

La différence entre la norme et la SRNN dans lequel la séquence d'entrée RNN SRNN une coupe minimale en un certain nombre de séquences à l'aide d'une unité de circulation pour chaque séquence. De cette manière, les séquences peuvent être facilement parallélisées. Au niveau 0, chaque unité de circulation pour le fonctionnement d'une séquence minimale de la structure de connexion. Ensuite, nous obtenons le statut final de chaque peau une séquence minimale sur la couche 0, qui est utilisée comme une entrée à sa séquence d'état-mère dans la première couche. On utilise alors les derniers états cachés sur chaque sous-séquence de (p-1) pour la couche parent en tant que sa séquence sur la couche p, et, enfin, une séquence d'états cachés est calculée sur la couche p:

parmi

L est le nombre de caché sur la première couche p, MSS est une séquence minimale de la couche 0 peut être utilisé sur différentes couches de différents GRU. A chaque répétition de la séquence de chaque sous-opération entre le parent, jusqu'à l'obtention d'une couche supérieure (k-ième couche) est caché finale F:

Expérience: Plus la longueur de la séquence, l'avantage de la vitesse de traitement plus SRNN

Dataset

Nous avons évalué SRNN sur six à grande échelle des ensembles de données d'analyse de l'humeur. Le tableau 1 énumère les ensemble de données. Nous avons sélectionné 80% des données utilisées pour la formation et 10% pour la vérification, 10% pour les tests.

Tableau 1: Les informations d'ensemble de données. mots max représente la longueur de séquence maximale, les mots moyenne dans chaque ensemble de données représente la longueur moyenne de la peine.

Résultats et analyse

Les résultats obtenus pour chaque ensemble de données comme indiqué dans le tableau 2. Nous avons choisi une des valeurs de n et k pour donner différents SRNN. Par exemple, SRNN (16,1) indique n = 16 et k = 1, lorsque T est 512, il est possible d'obtenir une longueur de séquence minimale de 32, quand T est de 256, il est possible d'obtenir une longueur de séquence minimale de 16. Nous 4 SRNN par rapport à RNN standard. Chaque jeu de données en caractères gras représente le plus haut et le plus rapide modèle de performance du modèle.

Tableau 2: Précision sur chaque ensemble de test de validation des données et le modèle et le temps de formation. Nous avons construit quatre structure SRNN différents. DCCNN est dilatée réseau de neurones de convolution occasionnel.

Les résultats ont montré que, presque sans paramètres supplémentaires, la performance SRNN et de vitesse dans tous les ensembles de données sont supérieures à RNN standard. SRNN différents sur différents ensembles de données ont réalisé les meilleures performances:

-

SRNN (16,1) sur Yelp 2013, 2015 Yelp, Amazon_F et Amazon_P ont la plus grande précision;

-

Performance SRNN (8,2) sur la meilleure Yelp 2014;

-

SRNN (4,3) la meilleure performance sur Yelp_P.

-

Lorsque K est supérieur à 1, SRNN ensemble de données Yelp près de 15 fois plus rapide que la norme RNN, selon l'avantage de vitesse visible k, n et T.

-

SRNN (4,3) sur Yelp 2015 le plus rapide, tandis que SRNN (8,2) le plus rapide (sauf DCCNN) dans l'ensemble de données restantes.

Nous notons, SRNN sur SRNN (2,8) sur les ensembles de données et Yelp Amazon des ensembles de données (2.7) n'a pas atteint la meilleure performance, mais cela n'a pas gâché trop en termes de précision. Cela signifie que l'effet de la transmission SRNN à travers de multiples couches d'information, par conséquent, lorsque nous formons des séquences très longues, SRNN peuvent obtenir significative. Lorsque n est 2, SRNN DCCNN ayant le même nombre de couches, et la précision est beaucoup plus élevé que SRNN DCCNN. Ainsi, cela indique que la structure cyclique est SRNN convolutif neural structure de réseau occasionnel dilatée supérieure.

Nous utilisons le modèle de formation NVIDIA GPU GTX 1080 sur le document 5120, parce que si vous utilisez plus de données, les normes de formation RNN prend trop de temps. Le tableau 3 montre le temps de formation.

Des résultats surprenants dans le tableau 3: Plus la longueur de la séquence, l'avantage de la vitesse à atteindre une plus grande SRNN . Lorsque la longueur de la séquence est 32768, SRNN seulement 52s, alors que la norme RNN prend presque 2 heures. la vitesse SRNN est 136 fois la norme de la RNN! Et si vous utilisez une séquence plus longue, l'avantage de la vitesse peut être supérieure. Par conséquent, SRNN peut être réalisé plus rapidement dans la longue séquence de tâches telles que la reconnaissance vocale, la classification des textes et de caractère niveau langage de modélisation.

Tableau 3: temps de formation et avantages de vitesse de différentes longueurs de séquences. Pour la longueur de chaque séquence, nous avons choisi une structure SRNN différente.

avantages SRNN et importance

Dans cette section, nous allons discuter des avantages et de l'importance de SRNN. Avec succès RNN dans de nombreuses tâches de la PNL, de nombreux chercheurs ont proposé des structures différentes pour améliorer la vitesse de RNN. En améliorant les unités de circulation, de nombreuses études peuvent accélérer la vitesse de RNN. Cependant, la structure classique de connexion RNN être remis en cause à peine, et cette structure à chaque étape de l'étape précédente et elle est associée. Il est cette structure de connexion limite la vitesse RNN. SRNN améliorer les méthodes de connexion classiques. Nous avons construit une structure de tranche (structure en tranches) pour paralléliser la RNN. Les résultats de l'analyse de l'ensemble de données dans six à grande échelle montrent émotionnelle, SRNN que RNN standard a de meilleures performances. Pour les raisons suivantes:

(1) lorsque la structure de connexion standard RNN, une unité de circulation (par exemple GRU et LSTM) ayant une structure de transmission sélective est utile, mais quand une longue séquence, on ne peut pas stocker toutes les informations importantes. longue séquence SRNN peut être divisée en plusieurs séquences courtes, et les séquences courtes pour obtenir des informations importantes. structure multicouche SRNN peut être transmis de la couche 0 à la partie supérieure de l'information importante.

(2) SRNN capable d'obtenir des informations de haut niveau de la séquence, plutôt que des informations de niveau de mot. Lorsque nous utilisons les mots dans le texte 512 dans SRNN (8,2), la couche 0 peut être obtenu à partir des informations mot phrase de niveau intégré dans la première couche 1 peut obtenir des informations à partir du niveau du paragraphe information de niveau de la phrase, la deuxième couche peut générer des paragraphes la représentation au niveau du niveau de document final de l'information. RNN seulement obtenir les informations de niveau lexical standard. Bien que chaque document a huit paragraphes, ont chacun huit phrases, chaque phrase il y a huit mots, mais la structure globale de l'information de séquence et l'information est cohérente. A l'information de paragraphe, par exemple, les gens expriment toujours leurs points de vue au début ou à la fin de l'article, et illustré au milieu de l'article. Par rapport à RNN standard, SRNN un accès plus facile à ces informations au niveau supérieur.

(3) en termes de la séquence de traitement, un mécanisme similaire à SRNN le cerveau humain. Par exemple, nous, les humains se dans un article et a demandé de répondre à quelques questions, nous ne nécessitent habituellement pas en profondeur lire l'article complet. Nous allons essayer de trouver les informations spécifiques mentionnées dans le paragraphe, puis trouver des phrases que vous pouvez répondre à des questions et des mots dans un paragraphe. SRNN à travers de multiples couches peut facilement le faire.

En plus d'améliorer la précision, le plus grand avantage est que vous pouvez SRNN calcul parallèle pour atteindre des vitesses plus rapides. Nous montrons SRNN beaucoup plus rapide que courir expérience dans une norme RNN longueurs de séquence différentes. De plus, dans la séquence plus longue, SRNN peut être plus rapide. Avec le développement de l'Internet, chaque jour, des centaines de millions de données générées, SRNN peuvent être utilisés comme une nouvelle méthode pour traiter ces données.

Conclusions et travaux futurs

Dans cet article, nous vous proposons une tranche réseau de neurones récurrents (SRNN), qui est RNN amélioration globale de structure. SRNN peut être réalisé beaucoup plus rapidement que la norme RNN et une meilleure performance dans six ensembles de données à grande échelle d'émotion.

succès SRNN dans la classification texte. Dans les travaux futurs, nous voulons promouvoir à d'autres applications de la PNL tels que des jeux-questionnaires, texte et résumé la traduction automatique. La séquence dans le modèle de séquence, SRNN peut être utilisé en tant que codeur et du décodeur peut être améliorée en utilisant une structure inverse de SRNN. De plus, nous voulons utiliser SRNN dans une longue séquence de tâches, comme modèle de langage, de production de la musique et de la production audio. Nous voulons découvrir des variantes plus SRNN, par exemple, vous pouvez ajouter une structure à deux voies et les mécanismes d'attention.

Selon les commentaires Reddit, a déjà été reproduit avec succès un résultat, vous pouvez aussi essayer rapidement ~

New Ji-won AI MONDE 2018 Assemblée de billets Early Bird []

En solde!

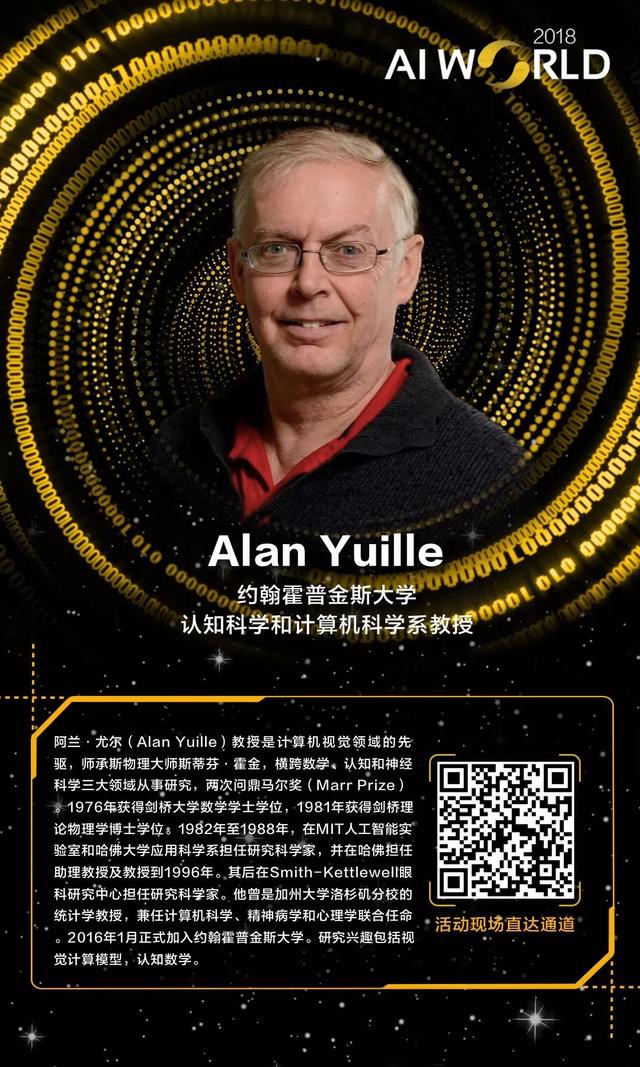

New Ji-won aura lieu le 20 Septembre à l'Assemblée générale de Beijing National Convention Center AI WORLD 2018, invitant pionnier de la vision par ordinateur Alan Yullie, parrain d'apprentissage de la machine, le professeur CMU Tom Mitchell, Maike Mark Si-Tiger, Zhou Zhihua, un grand Cheng Tao, Chen Yiran, etc. en mettant l'accent sur l'intelligence de la machine avec les dirigeants de la destinée humaine IA.

Le site officiel de l'Assemblée générale:

Maintenant jusqu'au 19 Août, Ji-won nouveau numéro d'édition limitée de billets Early Bird communication étroite avec le leader mondial de l'IA, l'intelligence artificielle, témoin de l'industrie mondiale à pas de géant.

-

Billets de ligne active lien:

-

billet de ligne active de code à deux dimensions: