Auteur | dix, années

Modifier | chameau

Le cerveau humain est évidemment la poursuite de l'intelligence artificielle des normes les plus élevées.

Après tout, le cerveau humain afin que les êtres humains ont la capacité et la capacité d'apprentissage dépendant du contexte d'apprentissage continu.

Cela peut continuer à absorber de nouvelles connaissances et les capacités des différents environnements adapter avec souplesse leur comportement en fonction du nouvel environnement, il est également une raison importante pour le système d'apprentissage en profondeur est loin du cerveau humain.

Voulez-vous le système d'apprentissage profondeur traditionnel pour obtenir une capacité d'apprentissage continu, la chose la plus importante est de surmonter le réseau de neurones artificiels apparaîtra dans « l'oubli catastrophique » le problème une fois que le nouvel ensemble de données pour former le modèle existant, qui perdra l'original la capacité d'identifier l'ensemble de données.

En d'autres termes: que le réseau de neurones pour conserver l'ancien connaissances tout en apprenant de nouvelles connaissances.

Il y a quelque temps, l'équipe de recherche de l'Université de Zurich et de l'ETH Zurich, a publié un article intitulé « super réseau d'apprentissage continu » (apprentissage continu avec hypernetworks) la recherche. proposé état des tâches de super-réseau (pour générer un modèle cible en fonction du poids des propriétés de la tâche du réseau) . Cette méthode peut résoudre le problème de l'oubli catastrophique.

Plus précisément, la méthode peut aider à la formation d'un réseau pour des tâches multiples, de traiter efficacement avec problème catastrophique oubliée . En plus de l'accès de référence d'apprentissage continu standard pour les meilleures performances de pointe, la séquence de tâches à long terme des expériences supplémentaires ont montré que les conditions de travail sur un réseau (hypernetworks tâche conditionné) ont montré une capacité de mémoire très importante des réserves précédentes.

hypernetworks

Institut fédéral de technologie de Zurich et l'Université de Zurich dans ce travail, le plus important est l'application de super-réseau (hypernetworks), et avant l'introduction de l'apprentissage continu sur le réseau, nous avons super réseau à faire une introduction.

HyperNetwork est un réseau très bien connu, Il est tout simplement d'utiliser un réseau pour générer un autre paramètres réseau . Le principe de fonctionnement est le suivant: les données d'entrée en utilisant un ensemble de formation HyperNetwork, le paramètre de sortie, ce qui correspond à la sortie du meilleur modèle est telle que ces paramètres peuvent obtenir de bons résultats sur l'ensemble de données de test. En termes simples HyperNetwork est en fait un réseau de méta.

L'approche traditionnelle consiste à former un ensemble de formation du modèle directement, mais si vous n'utilisez pas la formation de HyperNetwork, abandonner et inverser la propagation de la descente de gradient, paramètre de sortie directe, ce qui équivaut à HyperNetwork a appris à apprendre la reconnaissance d'image.

Articles voir la fin du texte

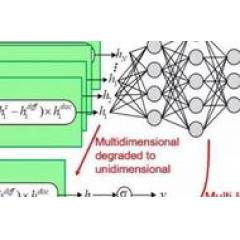

Dans « HyperNetwork » ce document, les auteurs utilisent HyperNetwork générer des poids RNN trouvés pour générer des poids non partagés, et mis en uvre sur un langage de modélisation au niveau des caractères, la génération de caractères manuscrits et les tâches de modélisation séquence nerf de traduction automatique la plus LSTM avancée résultats. Ultra réseau en utilisant un ensemble d'entrées contiennent des informations concernant le droit à restructurer, et générer le poids de la couche, comme représenté sur la Fig.

Droite génération de flux transmettre réseau réseau ultra poids: Noir et paramètres de connexion associés au réseau primaire, et les paramètres de connexion orange associés au super-réseau.

modèle d'apprentissage continu sur le réseau

Tout au long de l'opération, d'abord supposer que les données d'entrée {X (1), ...... x (t)} peuvent être stockées, et peuvent être calculées (T -1) en utilisant l'entrée de données. En outre, les données ne peuvent être utilisées et les données ont été utilisées pour éviter d'oublier le mélange. Supposons que F (x, ) est le modèle, puis l'ensemble de données mélangées {(X (1), Y (1)),. . . , (X (T-1), Y (t-1)), (x (t), Y (t))}, dans laquelle où Y (t) est un modèle f (., (t-1)) la combinaison résultante en une cible.

Cependant, les données stockées est clairement contraire aux principes de l'apprentissage continu, de sorte que dans le document, les auteurs proposent une nouvelle métamodèle fh (e (t), h) en tant que solutions, de nouvelles solutions peuvent être attention Un seul point tournant à partir du paramètre d'entrée-sortie de données ensemble { (T)}, et pour atteindre les exigences de non-stockage. Cette tâche méta-modèle super-état appelé réseau, l'idée principale est de créer une tâche stockée e (t) et la pondération des relations avec la cartographie, il est possible de réduire la dimension de l'ensemble de données, très SAUV.MEM.

Dans le « super réseau d'apprentissage continu, » ce document, la partie principale du modèle comporte trois parties, la première condition est la tâche sur le réseau. Tout d'abord, le réseau ciblera les paramètres super-modèle, qui ne sont pas les paramètres directs pour un modèle particulier de l'apprentissage, mais l'apprentissage des paramètres du modèle d'élément, donc les sorties méta-modèle sur les poids du réseau, qui est un peu plus le générateur de poids de réseau.

Génération d'un réseau cible sur les poids de réseau du paramètre de régularisation; la figure b :: figure itérative en utilisant un plus petits morceaux produisent le réseau cible sur les poids du réseau.

Ensuite, en utilisant une sortie continue du réseau d'apprentissage ultra régularisation. Dans ce document, les auteurs utilisent un processus en deux étapes afin d'optimiser la mise en place de contraintes de sortie du réseau de super de rétention de la mémoire. Tout d'abord, calculer h (h calculé sur la base du principe de l'optimiseur de sélection utilisé ici d'Adam), à savoir, trouver le paramètre peut minimiser la fonction de perte. l'expression de la fonction perte comme indiqué ci-dessous:

Note: * h est un paramètre de l'apprentissage précédent modèle super-réseau; h de variables exogènes, paramètre output est utilisé pour contrôler l'intensité de régularisation.

Considérez alors le modèle e (t), il est comme h même. A chaque étape de l'algorithme d'apprentissage, il est nécessaire de mettre à jour, et pour minimiser la perte de la fonction. Après la tâche d'apprentissage, la sauvegarde finale e (t) et ajouté à l'ensemble {e (T)}.

La seconde partie de modèle du modèle est comprimé par le bloc de super-réseau. Ultra réseau produit l'ensemble des objectifs fixés de poids réseau de neurones. Cependant, sur le réseau peut être des appels à chaque étape itérer remplir seulement une partie du modèle de bloc cible. Cela suggère que les petites applications permettent sur le réseau peuvent être réutilisés. Fait intéressant, l'utilisation des tâches de réseau super-bloc peut être résolu dans un état comprimé, dans lequel le nombre de paramètres d'apprentissage (ceux sur le réseau) est en fait inférieur au nombre cible de paramètres réseau.

Afin d'éviter l'introduction de la masse entre le réseau cible re-partition partagée respective, l'introduction de l'ensemble de bloc intégré {C} comme entrée supplémentaire sur un réseau. Ainsi, le corpus cible paramètres de réseau _trgt par une méthode itérative = C générée à, e reste inchangé dans le processus. Ainsi, sur le réseau peut générer un poids distinct sur chaque bloc. En outre, afin de simplifier le processus de formation, l'utilisation d'un ensemble de blocs partagés adapté à toutes les tâches.

La troisième partie du modèle: contexte raisonnement indépendant: tâche d'identification inconnue (inférence hors-contexte: identité de tâche inconnue). Déterminer les tâches à traiter du point de vue des données d'entrée. Super-tâche réseau intégrée nécessite l'entrée pour générer les poids du modèle cible. Dans certaines applications, l'étude continue, étant donné que l'ID de tâche est claire, ou peut être facilement déduit des indices de contexte, et peut donc choisir le approprié intégré immédiatement. Dans d'autres cas, un choix approprié de l'intégration n'est pas si facile.

Les auteurs discutent des stratégies d'apprentissage continu utilisent deux tâches différentes sur un réseau de conditions dans le document.

Une stratégie: l'incertitude prévisions dépend de la tâche. modèle de réseau de neurones dans le traitement de la distribution des données en dehors de la plus fiable. Pour la distribution de cible de classification, des données de haute entropie idéalement invisible produit une sortie à plat, tandis qu'un pic de faible entropie est générée en réponse à des données de distribution. Cela représente une tâche simple raisonnement (HNET + ENT), à savoir, une tâche donnée identifiant les modèles d'entrée inconnus, sélectionnez la tâche de prédiction la plus petite d'incertitude de quantification et la distribution entropie intégrée de la sortie.

Stratégie II: Lors de la génération des modèles sont disponibles, la tâche en cours peut être données synthétisées avec des données passées afin d'éviter catastrophique oublié mixte. En plus de protéger le modèle génératif lui-même, les données de synthèse peut également protéger les autres modèles. Cette stratégie, en fait, est souvent une solution optimale de l'apprentissage continu. Inspiré par ces expériences réussies, les auteurs explorent avec la lecture du réseau (réseau de lecture) pour améliorer le système d'apprentissage en profondeur.

Synthèse de la lecture (relecture synthétique) est un puissant mais pas parfait mécanisme d'apprentissage continu, puisque le motif résultant est facile à la dérive, les erreurs ont tendance à accumuler au fil du temps et l'amplification. Sur la base d'une série d'observations critiques sur la décision: comme un réseau cible, le modèle de lecture peut être spécifiée par super-réseau, et permet à la sortie de la formule de régularisation. Au lieu d'utiliser leur propre modèle de données de lecture. Ainsi, dans le procédé de cette combinaison, les conditions de synthèse et les tâches de modélisation d'éléments de reproduction fonctionnent simultanément, évitant catastrophique oublié.

repères

Les auteurs ont utilisé MNIST, CIFAR10-100 et ICRA ensemble commun de données pour la méthode du papier ont été évalués. Ces évaluations se concentrent sur deux aspects: (1) La condition tâche d'apprentissage continu HyperNetwork et la rétention de mémoire dans les trois milieux, (2) le transfert d'informations entre les tâches d'apprentissage de l'étude séquentielles.

Plus précisément dans les expériences d'évaluation, selon la tâche d'identifier si un trois clairs scénarios d'apprentissage continu: CL1, tâche identifiable, CL2, l'identité de la tâche n'est pas claire, n'a pas besoin d'une inférence claire, CL3, l'identité des tâches peut être clairement déduit. En outre ensemble de données MNIST construit dans un réseau entièrement connecté, dans lequel le paramètre de référence supérieur réglage méthode Dissertation van de Ven & Tolias (2019). ResNet-32 est sélectionné en tant que cible dans l'expérience de neurones ICRA réseau.

van de Ven et Tolias (2019):

.. Gido M. van de Ven et Andreas S. Tolias Trois scénarios pour l'apprentissage continu arXiv prépublication arXiv: 1904.07 73 4, 2019.

Afin d'illustrer davantage le processus du document, les auteurs considèrent référence quatre problèmes de classification d'apprentissage continu: régression non linéaire, PermutedMNIST, Split-MNIST, Split-10 ICRA / 100.

les résultats de la régression non linéaire sont les suivantes:

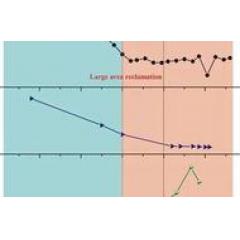

Note:. A la figure: la tâche de sortie l'état du réseau de régularisation sur les séquences peuvent être facilement modélisés nombre polynomial d'incréments, tout en étant en mesure d'obtenir l'effet de l'apprentissage continu. Figure b: des solutions similaires multi-tâches et réseau cible de formation directe trouvée. Figure c: apprendre étape par étape conduira à l'oubli.

Dans PermutedMNIST, le pixel des données d'image d'entrée et la permutation aléatoire. CL1 trouvé, les conditions super réseau le plus performant des tâches dans la séquence de tâches de T = 10 longueur. A condition de tâche PermutedMNIST sur la performance du réseau est très bon, par rapport à l'aspect synaptique à puce (Synaptic Intelligence), méthode CEE en ligne, ainsi que la profondeur pour générer la lecture (relecture profonde générative) fait une différence, en particulier intelligent et DGR synaptique + distillent volonté la dégradation se produit, en ligne CEE ne parvient pas à une très grande précision, comme indiqué ci-dessous a. Tâche compte tenu de la précision de l'appareil d'essai de taux de compression moyen, sur le réseau permet au modèle de compression, les paramètres même si le nombre dépasse le nombre de paramètres du réseau cible sur le modèle de réseau, la précision reste constante, comme représenté sur la. Figure B.

Split-MNIST Comme autre apprentissage continu de référence populaire, appariement ordonné dans chaque Split-MNIST numérique, et la formation de cinq tâches de classification binaire, et a constaté que l'état super-tâche performance globale du réseau le mieux. Dans la duplication des tâches d'addition sur le problème de MNIST split, peut transmettre des informations sur les tâches, et a constaté que l'algorithme converge vers le réseau cible peut produire des paramètres super modèle tout en répondant aux tâches anciennes et nouvelles de tâches de configuration. Comme le montre la figure.

Figure A: même dans l'espace de faible dimension a encore la haute performance de classification et forget ne se produira pas. Figure b: même si la dernière tâche occupe une région plus-capacité, et dans le cas de la dégradation de vecteur à distance intégré encore acceptable, la performance reste élevé.

Dans les expériences ICRA, les auteurs ont choisi ResNet-32 comme les réseaux de neurones cibles, au cours de l'expérience, les auteurs ont constaté que l'utilisation des conditions super-travail élimine presque complètement le réseau oublié, en plus de l'information avant la rétroaction se produira, ce qui signifie que la première conditions par rapport à l'apprentissage seul chaque tâche, la tâche de la connaissance du passé peut rendre le réseau plus performant.

En résumé, dans le document, les auteurs proposent un nouveau modèle de réseau de neurones pour l'apprentissage continu - condition de tâche sur le réseau, qui a la flexibilité et la polyvalence, en tant que méthodes d'apprentissage indépendant et continu peuvent être utilisés conjointement avec la lecture de formule . Cette méthode permet d'obtenir une mémoire longue durée de vie, et peut transmettre des informations aux tâches futures de répondre aux deux caractéristiques fondamentales de l'apprentissage continu.

références:

HYPERNETWORKS:

https: // ar xi v.org/pdf/1609.09106.pdf

CONTINU AVEC L'APPRENTISSAGE HYPERNETWORKS

https: // ar xi v.org/pdf/1906.00695.pdf

https: //mp.wei xi n.qq .com / S / hZcVRraZUe9xA63CaV54Yg