Auteur | Université nationale Chiao Tung équipe Zhao

Modifier | Camel

Source: informatique et de génie, Université Jiaotong de Shanghai

Conférence internationale sur les représentations d'apprentissage (IPSC) (Conférence internationale d'étude de caractérisation) est la réunion de haut de la profondeur de l'apprentissage. IPSC 2020 aura lieu le 26 Avril 2020 dans la capitale éthiopienne Addis-Abeba, la session en cours a reçu un total de 2594 articles, 687 ont été reçus, dont 48, 108 projecteurs orals et 531 affiche Pian. Il a été engagé dans ce 687 l'article 34 est sur papier. Shanghai Jiaotong University Département de l'interaction intelligente informatique et génie cognitif, Laboratoire clé de Shanghai professeur Gao Xiao Zhao et ses collaborateurs papiers a été nommé l'un des ICLR2020 sur papier.

Thèse intitulée: « Avant gaussienne en fonction de données objectives pour la génération de langage », le premier auteur du document est un guide candidat au doctorat Professeur Zhao de huiler les étudiants, le professeur Zhao est co-auteur correspondant.

la compréhension du langage Pearl est la plus haute intelligence artificielle. Comme Richard Feynman (Richard Feynman) la maxime bien connue, « Je ne peux pas créer quelque chose, je ne peux pas le comprendre. » génération de langue reflète le niveau de développement de la compréhension du langage.

Ces dernières années, le modèle de génération de langage fait d'importants progrès, en particulier dans le réseau de neurones profond (DNN) un développement rapide. Il existe plusieurs génération de modèle de langage typique, telle qu'une séquence de modèle de séquence (seq2seq), généré contre le réseau (GAN), la variation du codeur (VAE) et le réseau autorégressif.

génération de langue est souvent modélisé comme une tâche de prédiction de la série, la séquence en utilisant l'estimation de vraisemblance maximale (MLE) en tant que lignes directrices de formation standard (c.-à-la cible). MLE en raison de sa nature et de flexibilité intuitive a été un grand succès. Cependant, en raison de la MLE, la séquence prédit la présence des questions suivantes:

-

Exposition Bias: pas de modèle dans le processus de formation est exposé à toutes les erreurs;

-

perte Mismatch: dans le processus de formation, nous maximisons la vraisemblance, et dans le processus de raisonnement, le modèle est évalué par les différents indicateurs (par exemple, ou ROUGE BLEU);

-

Le manque de diversité: ennuyeux texte généré, ordinaire, tel que le manque de vision et de la répétabilité;

-

ignorance de la diversité négative: MLE incapable de répartir la fraction appropriée des différents résultats du modèle d'erreur, ce qui signifie que toutes les erreurs dans les sorties de processus de formation sont traités de manière égale.

En plus de la diversité de l'ignorance que négative, il y a eu une variété de travail peut atténuer ce qui précède MLE que l'absence d'objectifs de formation. l'ignorance de la diversité négative est injustement sous-estimé l'unité association située dans la cible, en raison de la présence de l'unité de génération de langue cible proche définie, etc. exprimant une situation similaire, ce qui rend la séquence de langage de génération de tâche spécifique à la tâche de prédiction générale. Lorsque l'on compare la MLE sa séquence cible et prédire la séquence réelle, elle a adopté une politique qui correspond à la fois. séquence Prévisible sera donnée les étiquettes binaires correctes ou incorrectes. Cependant, ces formations de prédiction incorrecte peut varier, donc savoir quel modèle plus précisément prédit erroné ou incorrect, peut-être plus efficace que d'autres erreurs de modèle d'orientation de la formation des prévisions.

Par exemple, la phrase « la peu garçon est assis sur le fauteuil « génération, par exemple (figure 1), la génération du » fauteuil «les étudiants peuvent devenir à tort » canapés «mais ne devrait généralement pas être confondu avec » champignons ».

Figure 1: Exemple de production D2GPo

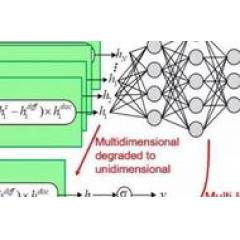

Afin d'alléger le problème de la diversité ignorante négative, nous avons ajouté un but avant gaussienne supplémentaire pour ajouter un élément supplémentaire de déviation de perte Kullback-Leibler (KL) pour améliorer la formation MLE actuelle. Est calculé en comparant deux perte distribution de probabilité supplémentaire, la distribution de probabilité à partir d'une première formation détaillée d'un modèle prédictif, la deuxième unité de distribution de probabilité de la véritable répartition spatiale, et est définie comme étant une distribution a priori gaussienne des données relatives à. Ensuite, le terme de divergence KL gaussienne après les données, avant liées à la cible (D2GPo) est injecté dans la perte finale. D2GPo avec éloignées données Gaussienne avant (L2 régularisation) indépendant commun, L2 régularisée but MLE est de simplifier la formation, qui est directement appliquée sur les pertes MLE.

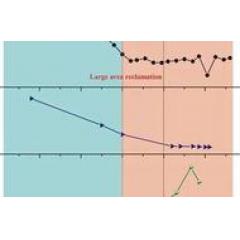

Les résultats expérimentaux montrent que cette méthode peut effectivement utiliser les données plus en détail l'information préalable, et peut améliorer considérablement les performances d'une des tâches typiques de génération de langues, y compris la traduction automatique supervisée et non supervisée, texte résumé, la narration et les images résumé ( la figure 2).

Figure 2: Résumé des exemples d'image

Figure 2: Modèle de référence Exemple D2GPo dans l'image, nous présentons un résumé de la tâche. Comme on peut le voir dans les exemples ci-dessus utilisent des rendements du modèle de formation CSTD plus précis et un résumé détaillé de l'image et le modèle formé utilise le retour D2GPo à une des phrases grammaticales plus complètes, qui démontrent l'efficacité de D2GPo dans la tâche de génération de langage.

Documents lien: https: //openreview.net/pdf id = S1efxTVYDr?

Pour plus d'informations IPSC 2020, aura lieu dans « groupe d'échange IPSC 2020 », les moyens ajouté de groupe: Ajout AI Yanxishe haut assistant (AIyanxishe2), notes « IPSC » invité dans le groupe.