Lei Feng réseau par AI Yanxishe : Avec la taille du réseau de neurones apprentissage en profondeur augmente, la profondeur de la formation d'un réseau de neurones (Deep Neural Networks, DNN) prennent souvent des jours ou des semaines même. Afin d'accélérer l'apprentissage, ont souvent besoin distribués CPU / cluster GPU pour terminer toute la formation. Dans cet article, il est simple pour tout le monde à expliquer brièvement comment le modèle d'apprentissage de la profondeur de la formation distribuée.

Lei Feng réseau dans un avenir proche AI Yanxishe de classe en ligne ouverte, de l'ingénieur de recherche IBM Systems Dr. Wu Wei pour tout le monde à faire un thème de « étude approfondie de la formation distribuée » dans le partage en ligne, vous avez manqué la diffusion en direct des étudiants Si vous avez regardé le papier ont des doutes, mais aussi au Collège des AI Mu Lei Feng montre de classe de réseau lecture vidéo .

Ce qui suit est Lei Feng réseau de contenu vidéo en direct de faire un bref rappel:

dimension militaire, IBM Systems Ingénieur R & D, a travaillé au sein du Groupe Data Products Big Huawei et IBM China Research Institute, en tant qu'ingénieur systèmes / chercheur, le Dr System Engineering, Université Xi'an Jiaotong, la direction principale du développement de l'apprentissage distribué dans le cadre de la formation en profondeur et modèle.

grandes lignes de l'action:

-

Pourquoi la formation distribué et distribué modèle d'apprentissage tensorflow architecture profondeur.

-

la réplication et la réplication entre la figure tensorflow figure.

-

modèle de formation d'apprentissage en profondeur asynchrone et la formation synchrone.

-

Étude de cas: Comment le modèle autonome de distribution.

-

présentation de la performance de formation de modèle distribué.

Partager le contenu:

Bonjour à tous, je suis une dimension militaire, la première partie d'aujourd'hui pour expliquer pourquoi la part de la formation à utiliser et distribué architecture distribuée de tensorflow, la deuxième partie de la réplication et la réplication parler entre carte Figure tensorflow, la troisième partie concerne la formation distribuée synchrone brève formation et asynchrone. La quatrième partie est sur la façon dont le modèle distribué autonome dans un modèle distribué, la cinquième partie porte sur la performance de la présentation de la formation distribuée.

Pourquoi l'utiliser distribué la formation, la formation distribuée portent principalement sur des problèmes, et comment traiter?

La figure ci-dessous un schéma de l'architecture du centre de données sur TPU

La première raison est d'augmenter le débit de la formation; deuxième raison est que pour un grand train miniature, grand modèle est adapté en général dans un seul appareil.

Ce qui suit peut être considéré comme l'abscisse gauche est le nombre de GPU, l'ordonnée est la vitesse de traitement d'image.

Comment former pour le grand modèle? L'approche est maintenant en train de démanteler le modèle à différentes cartes GPU à l'intérieur, chaque carte GPU dans une partie de la formation, de sorte que vous pouvez mettre en place un grand modèle de formation distribuée.

Comment parvenir à ce processus

La gauche est une opération de base du tensorflow de processus.

processus de développement tensorflow

architecture distribuée tensorflow, son architecture est basée sur le maître et l'architecture négrier.

Ce sont la profondeur de parler maître et négrier du point de vue de l'apprentissage d'une architecture distribuée, ce qui suit du point de vue du travailleur:

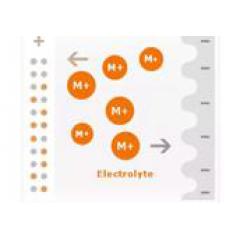

étude approfondie des premiers paramètres de formation, qui paramètres distribués stockés dans le serveur de paramètres, si le travailleur a besoin d'opération, il lit d'abord les paramètres du serveur aux paramètres de la CPU. À l'heure actuelle, la plupart de la profondeur de l'apprentissage et de la formation sont effectuées sur le dispositif GPU, de sorte que vous devez copier les données à lire sur le GPU, le GPU peut commencer à fonctionner de gauche à droite. Enfin trouvé par la variable de dérivation correspondant à la pente, et le gradient dans la machine est copiée dans la CPU correspondante, CPU lui envoie alors au serveur via un paramètre de communication de réseau, ce qui est de voir le travailleur toute dans la perspective d'une architecture distribuée.

Tensorflow dans la formation distribuée il y a deux concepts les plus importants sont « la réplication entre la figure » « copie dans la carte » et. Distribué des moyens de formation il y a un groupe, définir un cluster distribué. Ce qui suit est une copie de la figure intérieure, cas unique pour plusieurs cartes.

Si plus d'une fois l'ordinateur, la distribution de données causée par les goulets d'étranglement de données sera relativement importante, si la vue de la réplication, les goulots d'étranglement de transmission de données se produisent. Le temps nécessaire pour copier une salle de dessin, deux graphiques milieu des variables partagées peut résoudre le problème de la distribution des données de formation, cette méthode est applicable à la formation de carte multi-machine. la réplication de la figure entre plusieurs clients, copier un seul client dans le diagramme.

Tensorflow encapsule avancés le API, les paramètres sont déployées automatiquement le paramètre de serveur, l'opération arithmétique est établie à l'ouvrier, qui est réalisé une pluralité de code qui peut être exécuté sur travailleur, simplifie la préparation du programme client.

Comment trouver la valeur optimale distribuée W? la formation de la formation synchrone et asynchrone Quelle est la différence?

descente de gradient stochastique: une première quantité de calcul d'équation de valeur dérivée partielle est trop important, peu pratique. Typiquement dérivé de calcul, solution analytique.

Procédé d'algorithme du gradient stochastique distribuée

Procédé de formation asynchrone: la formation asynchrone pour la tâche sur chaque noeud sur tensorflow méthodes d'entraînement indépendant, il ne nécessite pas la synchronisation avec d'autres noeuds sur le serveur de paramètre de gradient.

la synchronisation de processus de formation: les besoins en formation et d'autres noeuds synchrones Réduire gradient sur le serveur de paramètres.

La quatrième partie est de savoir comment écrire un exemple de formation de modèle distribué, vous pouvez regarder la lecture vidéo.

Voici un exemple d'une version autonome du modèle de régression linéaire

La cinquième partie est Comparaison des performances de la formation distribuée

L'évaluation est généralement divisé en aspects du modèle et des plates-formes. En ce qui concerne le modèle des indicateurs couramment utilisés sont: la précision, le taux de rappel, AP et ainsi de suite. plate-forme

Principalement pour voir le SpeedUp débit.

la formation Asynchronous débit mieux que la formation synchrone, la formation afin que la formation synchrone asynchrone rapide.

Comparaison des algorithmes synchrones et asynchrones algorithmes

Ce sont le contenu principal de la part, le code qui met en uvre certaines des recommandations directement aux élèves regardent la lecture vidéo, mais également préoccupé par la dimension militaire des clients adresse GitHub.

Micro-canal numéro public: « AI Yanxishe » programme à long terme pour fournir des vidéos en direct gratuitement, s'il vous plaît faites attention!