Lei Feng réseau AI Technology Review par: IPSC 2018 qui se tiendra au début du mois de mai à Vancouver, au Canada. Papier « efficace Sparse-Winograd Convolutif Neural Networks' sont engagés IPSC 2018, le premier auteur, l'Université de Stanford étudiant au doctorat Liu Xingyu a écrit le manuscrit pour l'interprétation exclusive de Lei Feng réseau AI Technology Review, Tous droits réservés.

introduction

Circonvolution réseau de neurones reflète les avantages énormes dans de nombreuses applications d'apprentissage de la machine. Calcul des performances et de la consommation d'énergie est principalement déterminée par le nombre d'opération de multiplication de convolution. Cependant, l'énorme quantité de calcul de convolution réseau de neurones limite son application sur un dispositif mobile.

Il existe deux méthodes principales pour réduire le nombre de multiplications CONVOLUTIONNELS réseau de neurones:

-

1) à l'aide des propriétés algébriques linéaires de convolution, la convolution par exemple Winograd algorithme permet de réduire le nombre de multiplications par la transformation linéaire et les neurones du noyau de convolution;

-

2) la compression du réseau de neurones, par exemple, par l'utilisation de poids et les neurones dans le sparsity élagage chaînons depuis généré sparsity RELU.

Cependant, les deux directions incompatibles mentionnées ci-dessus: une transformation linéaire des neurones et leur noyau de convolution feront l'absence de parcimonie d'origine, il ne peut pas être utilisé pour accélérer la parcimonie. Utilisez l'algorithme de convolution Winograd sur le réseau de neurones rares de convolution, mais augmentera la quantité de calcul.

En réponse à ces problèmes, ce document propose deux améliorations.

-

Tout d'abord, nous allons passer le domaine de la fonction d'activation Winograd Relu si nerveux quand la multiplication yuan est rare;

-

D'autre part, nous sommes à droite après la Winograd transformer la taille lourde, de sorte que lorsque le droit d'exploiter la multiplication lourde est clairsemée.

Les résultats expérimentaux montrent que la perte de précision de 0,1%, le nouveau procédé proposé permet de réduire le nombre de multiplications respectivement 10,4 fois, 6,8 fois et 10,8 fois dans le ICRA-10, ICRA-100 et IMAGEnet rapport de réduction ensemble de données par rapport à multiplier par rapport à la version 2.0 d'origine à 3,0 fois la mise à niveau de référence.

convolution Sparse Winograd

Traditionnellement algorithme de convolution Winograd à effet de champ d'entrée de taille de cellule de base dans laquelle d est PXP pièces de figure, après un domaine temporel du noyau 3 x 3 convolution convolution de g (P-2) x (p-2) le bloc de sortie S. Tous les blocs de sortie correspondent ensemble pour obtenir la caractéristique de sortie de la Fig.

Pour ce faire: d et g, respectivement la matrice de transformation G et B obtenus B p x p et la taille de domaine Winograd ^ TdB ggg ^ T, avec la multiplication de la matrice de Hadamard transformée A ont été obtenus après deux S. Lorsque p est égal à 4, les matrices B et A contient uniquement des éléments 0, 1 et -1, de sorte que la multiplication de A et B ne nécessite que l'addition et la soustraction. Formule de calcul ci-dessous:

Temps réseau la taille du domaine: Lors de l'utilisation réseau d'élagage ordinaire (Han et al. 2015) lorsque, RELU effet de la fonction d'activation de la couche précédente de l'entrée dans le domaine temporel d, g poids du domaine simultanément est taillé. Le bloc de sortie S est calculée par l'équation suivante:

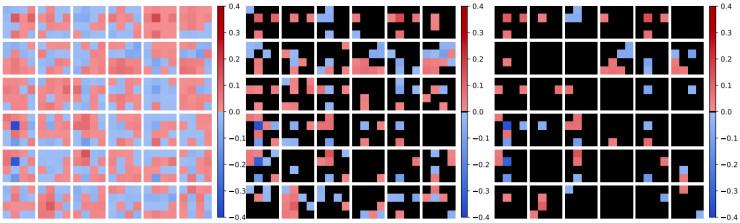

Lorsque le calcul comme représenté sur la Fig. 4 p =. Bien que d et g, respectivement, en raison RELU et la taille sont rares, cependant, G () G ^ T ^ T et B () Temps B domaine de transformation efface 0. Par conséquent, la faible densité de réduire le nombre de multiplications.

Winograd réseau d'élagage local: Lors de l'utilisation du Winograd élagage réseau local (Liu et al. 2017, Li et al. 2017) lorsque, l'effet RELU de la fonction d'activation de la couche précédente de l'entrée de domaine de temps d, alors que les coefficients de pondération domaine Winograd ggg ^ T est taillé. Le bloc de sortie S est calculé par la formule suivante

Lorsque le calcul comme représenté sur la Fig. 4 p =. Bien que les poids élagage Winograd poids ggg ^ T de domaine sont rares, cependant, B ^ T () B-domaine de transformation efface d 0 contenu. Par conséquent, le domaine temporel d Relu due sparsity ne peut toujours pas apporter de réduire le nombre de multiplications.

convolution Winograd-RELU réseau neuronal: Pour résoudre ce problème, nous proposons convolution Winograd-Relu réseau de neurones. Nous Relu d'exploitation sur le domaine Winograd plutôt que le domaine temporel. Ainsi, lors de l'opération de multiplication, poids lourd Winograd domaine ggg ^ T et l'entrée B ^ BDT sont rares, le nombre de multiplications peuvent être encore réduits. Le bloc de sortie S est calculé par la formule suivante

Lorsque le calcul comme représenté sur la Fig. 4 p =.

Il est intéressant de noter que nous avons complètement abandonné le temps noyau de convolution de domaine. Parce que RELU couche convolutionnel est liée à la précédente, l'opération de domaine Relu Winograd est effectivement démarré à partir de la deuxième couche. Il est à noter que la nouvelle architecture de réseau de neurones convolutionnels proposés et les réseaux de neurones convolution générale ne sont pas équivalents en mathématiques. Par conséquent, la formation, la taille et les réseaux de nouvelle formation doivent être modifiés comme suit.

formation: Nous noyau de convolution directe après Winograd transformer la formation de domaine. Après l'optimisation du noyau de convolution initialisation aléatoire calculé directement à partir de la rétro-propagation de gradient.

Taille: Nous convolution de domaine Winograd de taille: la valeur absolue de tous les éléments est inférieure à la valeur de seuil t est réglé sur 0. Atteint est obtenu en élaguant un taux requis r calculé la valeur de seuil t. Dans nos expériences, la taille de toutes les couches est le même.

La formation de poids: Nous utilisons le masque avant l'étape d'élagage pour obtenir le recyclage. Dans le processus de formation re, des poids sont taillées forcées à 0 par le masque. gradient de la fonction de perte de calcul de neurones d'entrée du réseau et des gradients de pondération dans le domaine Winograd peuvent être transmis par l'amont à travers les rendements de la règle de la chaîne:

Expériences et résultats

Nous la méthode ci-dessus est appliquée à différents ensembles de données de différentes architectures de réseau. Nous avons choisi l'infrastructure de réseau expérimental dans la plupart de la taille du noyau de convolution 3x3, qui peut garantir la couche la plus de convolution peut être convertie en couche de convolution Winograd. Nous classons les ensembles de données d'image ont été utilisés 10 ICRA, et 100-ICRA expérience IMAGEnet. Chaque architecture de réseau, nous comparons ce qui précède trois types de réseaux. Trois types de réseaux commencent à partir de zéro et de la formation itérative taille - processus de re-formation.

10-ICRA:

Nous utilisons des expériences de réseau VGG-nagadomi. VGG-nagadomi peut être considéré comme léger VGGNet, dans lequel la couche 8 couche de convolution 3x3. Nous dès la première couche de forte densité de 80%, la couche restante la taille itérativement de 80% à 20%.

Peut être vu de la figure, lorsque la perte est inférieure à taux de précision de 0,1%, la taille du réseau dans le domaine temporel, pruneau Winograd réseau local peut être élagué à seulement 60% la densité, nous avons proposé réseau Winograd-Relu peut être élagué à densité de 40%.

Le tableau compare la quantité calculée du réseau et d'un poids et les neurones d'entrée respectifs après densité élagage. temps émondage réseau de domaine, la taille Winograd réseau local peut être calculé seulement à réduire la quantité de 5,1 et 3,7 fois, respectivement. Et nous avons proposé réseau Winograd-Relu peut réduire une quantité de calcul 13,3 fois, par rapport aux deux réseaux de référence de mise à niveau 2.6 et 3,6 fois, respectivement.

-100 ICRA:

Nous utilisons des expériences de réseau ConvPool-CNN-C. ConvPool-CNN-C 9 Les couches de convolution, qui convolution 3x3 sept couches. Nous dès la première couche de forte densité de 80%, la couche restante la taille itérativement de 80% à 20%.

Peut être vu de la figure, lorsque la perte de vitesse de précision inférieure à 0,1%, Winograd la taille réseau local peut être élagué à la densité de 70%, tandis que le domaine du réseau et la taille de notre réseau Winograd-Relu proposé peut être élagués à 60 densité%.

Le tableau compare la quantité calculée du réseau et d'un poids et les neurones d'entrée respectifs après densité élagage. temps émondage réseau de domaine, la taille Winograd réseau local peut être calculé seulement à réduire la quantité de 3,5 et 3,2 fois, respectivement. Et nous avons proposé réseau Winograd-Relu peut réduire la quantité de calcul 7,1 fois, par rapport à deux réseaux de référence de mise à niveau respectivement 2,1 et 2,2 fois.

IMAGEnet:

Nous réseau RESNET-18 en utilisant une variante de l'expérience. La différence entre la variante originale ResNet-18 est que nous utilisons 1x13x3 étape de convolution et une couche de cellules pour remplacer 2x22x23x3 étape de convolution. Nous avons également enlevé la dernière piscine de la couche, de sorte que la taille du dernier groupe d'une couche de convolution est 14x14. Nous allons re-densité poids de convolution couche la taille itérativement de 80% à 10%.

Peut être vu de la figure, lorsque la perte est inférieure à taux de précision de 0,1%, le temps réseau d'élagage de domaine, Winograd la taille du réseau local ne peut être élagué respectivement 60% et 50% de la densité, nous avons proposé le réseau peut Winograd-Relu taillés à 30% / densité de 35%.

Le tableau compare la quantité calculée du réseau et d'un poids et les neurones d'entrée respectifs après densité élagage. Élagage temps réseau de domaine, la taille Winograd réseau local peut être calculé seulement à réduire le montant de 5,1 et 4,5 fois, respectivement. Et nous avons proposé réseau Winograd-Relu peut réduire la quantité de calcul 13,2 fois, par rapport à deux réseaux de référence de mise à niveau 2.6 et 2,9 fois respectivement.

discuter

Nous visualisons noyau de convolution proposé réseau Winograd-Relu. Nous avons choisi le premier six canaux d'entrée et de sortie de la couche res2a_2a. On peut voir le noyau de convolution réseau Winograd-Relu ne montre pas de signification physique évidente. Cependant, nous avons trouvé (2,2) élément (de gauche à droite et de haut en bas, l'objectif initial de 1) est habituellement plus important que les autres éléments. Une raison possible est que, (2,2) des éléments dans les neurones d'entrée est un champ particulier dans Winograd: il est le seul dans les neurones B ^ TDB seulement et non pour la soustraction par l'additionneur linéaire transformation. caractéristique entrée lisser la figure, ces moyens (2,2) est le seul élément de l'élément a une moyenne non nulle.